对于学习规则,可分为一般δ规则和广义6规则, 常见的有以下3种。 ①6学习规则。 它优于感知器学习,因为△W不是固定的量而与误 差成正比,即 △W,=7o' (6.3) 这里7是全局控制系数,而,δ,=t-V即期望值δ 和实际值之差。 学习规则和感知器学习规则一样只适用于线性可分函 数,无法用于多层网络。 11

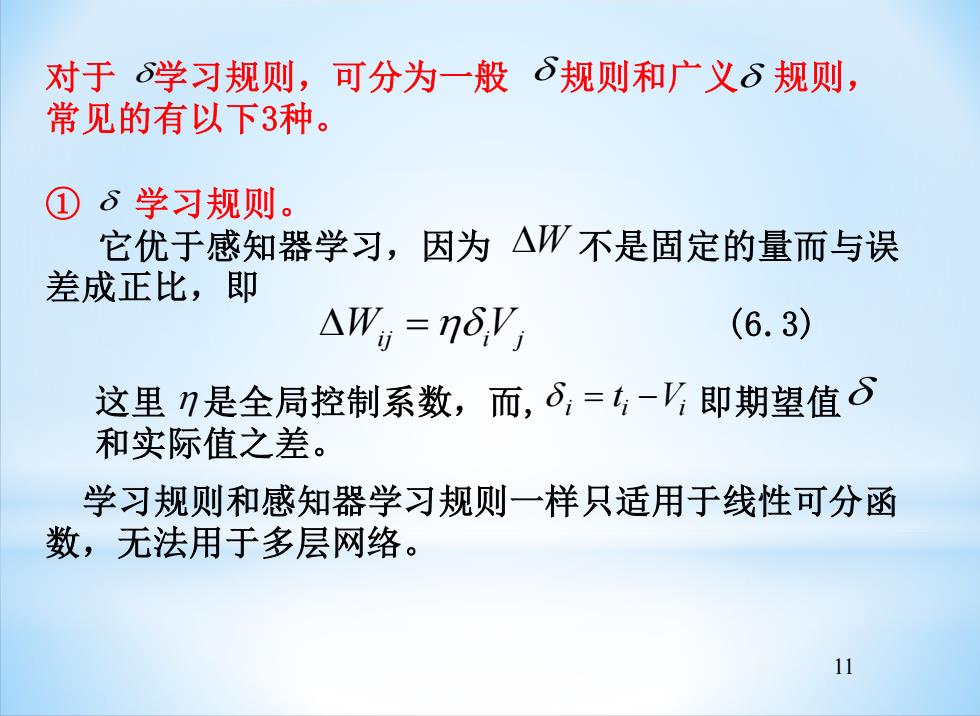

11 对于 学习规则,可分为一般 规则和广义 规则, 常见的有以下3种。 ① 学习规则。 它优于感知器学习,因为 不是固定的量而与误 差成正比,即 W Wij =i Vj (6.3) 这里 是全局控制系数,而, 即期望值 和实际值之差。 i i i = t −V 学习规则和感知器学习规则一样只适用于线性可分函 数,无法用于多层网络。

②广义δ规则。 它可在多网络上有效的学习,其关键是对隐节点的偏差δ 如何定义和计算。对BP算法,当i为隐节点时,定义 6,=f(net)*∑oWa (6.4) 这里Ma是节点i到上一层节点k的权值,为连续的一 次可微函数,将某一隐节点馈入上一层节点的误差的比 例总和(加权和)作为该隐节点的误差,通过可观察到的 输出节点的误差,下一层隐节点的误差就能递归得到。 广义的 规则可学习非线性可分函数。 12

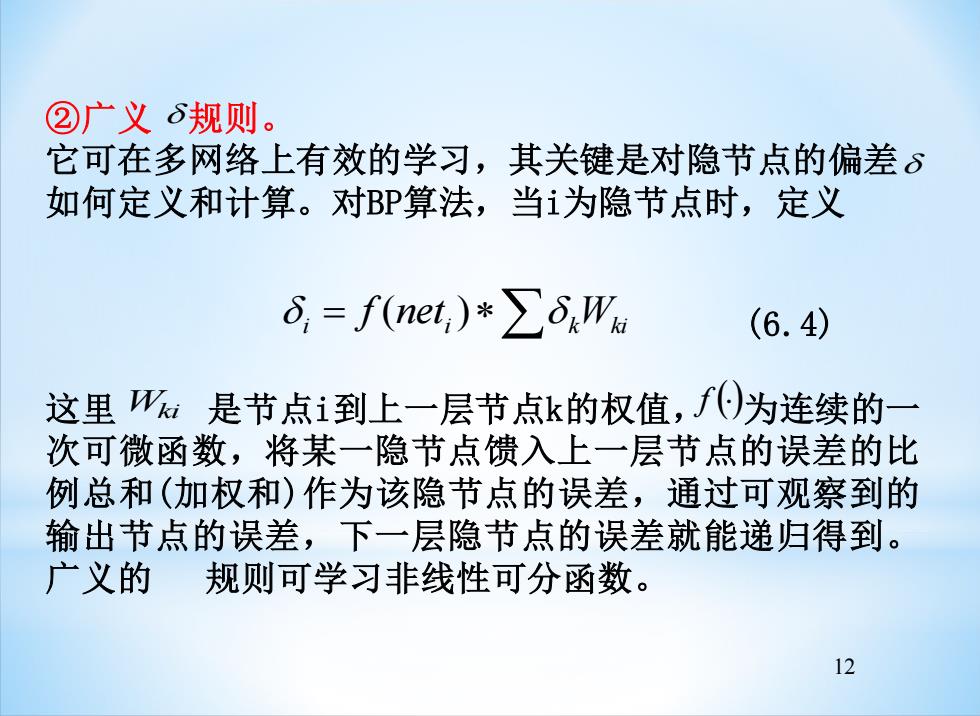

12 ②广义 规则。 它可在多网络上有效的学习,其关键是对隐节点的偏差 如何定义和计算。对BP算法,当i为隐节点时,定义 i = neti k Wki f ( ) (6.4) 这里 是节点i到上一层节点k的权值, 为连续的一 次可微函数,将某一隐节点馈入上一层节点的误差的比 例总和(加权和)作为该隐节点的误差,通过可观察到的 输出节点的误差,下一层隐节点的误差就能递归得到。 广义的 规则可学习非线性可分函数。 Wki f ()

(3)无教师学习规则 在这种学习规则中,关键不在于实际节点的输出怎样与 外部的期望输出相一致,而在于调整参数以反应观测事 件的分布。诸如的自适应共振理论(ART)、自组织特征 映射和K1opf的享乐主义神经元都是无教师学习。 这类无教师学习的系统并不在于寻找一个特殊函数表示, 而是将事件空间分类成输入活动区域,且有选择的对这 些区域响应。它在应用于开发由多层竞争族组成的网络 等方面有良好的前景。它的输入可以是连续值,对噪声 有较强的抗干扰能力,但对较少的输入样本,结果可能 依赖于输入顺序。 13

13 (3)无教师学习规则 在这种学习规则中,关键不在于实际节点的输出怎样与 外部的期望输出相一致,而在于调整参数以反应观测事 件的分布。诸如的自适应共振理论(ART)、自组织特征 映射和Klopf的享乐主义神经元都是无教师学习。 这类无教师学习的系统并不在于寻找一个特殊函数表示, 而是将事件空间分类成输入活动区域,且有选择的对这 些区域响应。它在应用于开发由多层竞争族组成的网络 等方面有良好的前景。它的输入可以是连续值,对噪声 有较强的抗干扰能力,但对较少的输入样本,结果可能 依赖于输入顺序

2)常用神经网络的学习方法 (1)Hebb学习方法 基于对生理学和对心理学的长期研究,D.0.Hebb提出了生物 神经元学的阶段,即当两个神经同时处于兴奋状态时,它们 之间的连接应当加强。这一假设可描述成 w(k+1)=w(k)+I,I (6.5) 式中w,)为连接从神经元到神经元j的当前权值;,1,为神经 元i,j的激活水平。 Hebb学习方法是一种无教师的学习方法,它只根据神经元连 接间的激活水平改变权值,因此这种方法亦称相关规则。 14

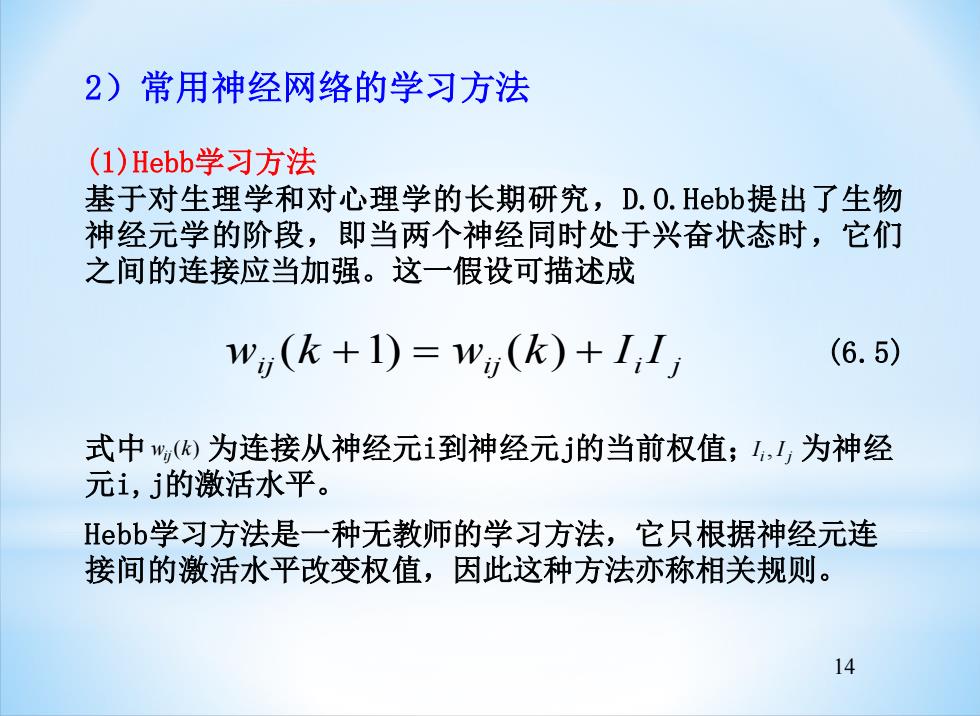

14 2)常用神经网络的学习方法 (1)Hebb学习方法 基于对生理学和对心理学的长期研究,D.O.Hebb提出了生物 神经元学的阶段,即当两个神经同时处于兴奋状态时,它们 之间的连接应当加强。这一假设可描述成 i j i j i j w (k +1) = w (k) + I I (6.5) 式中 为连接从神经元i到神经元j的当前权值; 为神经 元i,j的激活水平。 w k ij( ) I I i j , Hebb学习方法是一种无教师的学习方法,它只根据神经元连 接间的激活水平改变权值,因此这种方法亦称相关规则

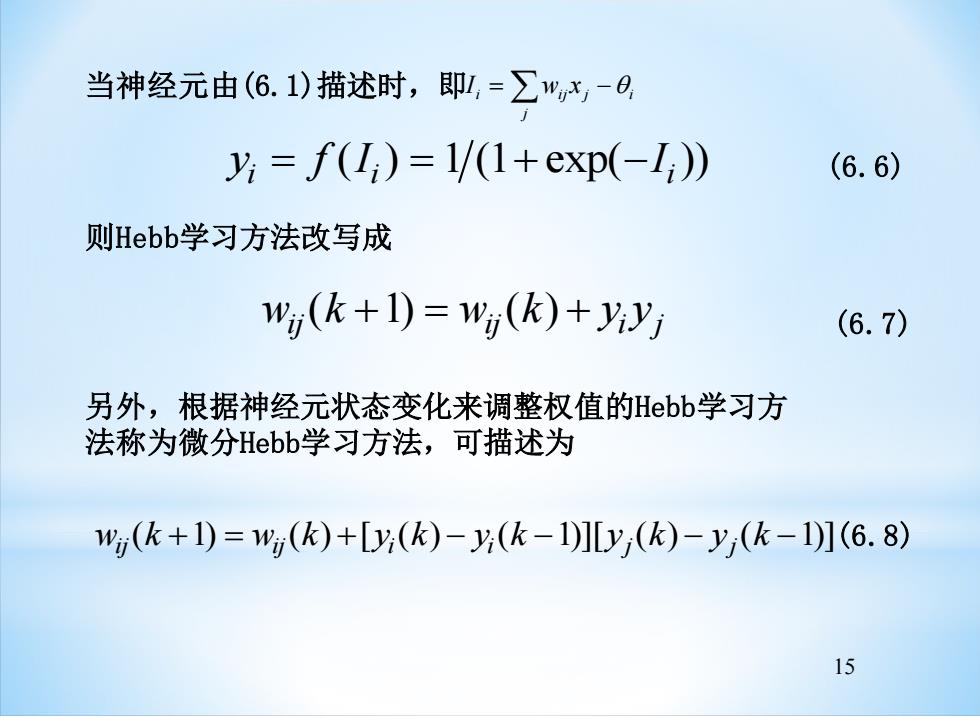

当神经元由(6.1)描述时,即,=∑",x,-0 y=f(I)=1/(1+exp(-I) (6.6) 则Hebb学习方法改写成 wij(k+1)=Wij(k)+yyj (6.7) 另外,根据神经元状态变化来调整权值的Hebb学习方 法称为微分Hebb学习方法,可描述为 w(k+1)=w(k)+[(k)-(k-1][y(k)-y(k-1](6.8) 15

15 当神经元由(6.1)描述时,即 = − j i ij j i I w x y f I I i = i = + − i ( ) 1 (1 exp( )) (6.6) 则Hebb学习方法改写成 w k w k y y ij ij i j ( +1) = ( ) + (6.7) 另外,根据神经元状态变化来调整权值的Hebb学习方 法称为微分Hebb学习方法,可描述为 w k w k y k y k y k y k ij ij i i j j ( +1) = ( ) +[ ( ) − ( −1)][ ( ) − ( −1)] (6.8)