(2)梯度下降法 梯度下降法是一种有教师信号的学习。假设下列准则函数 J(W)=o(W.k)=(Y(k)-Y(W.k)2 (6.9) 其中Y(k)代表希望的输出,m,k为期望的实际输出,W是所 有权值组成的向量,(w,)为W,k)对以的偏差。现在的 问题是如何调整W使准则函数最小。 梯度下降法(Gradientdeclinemethod)可用来解决此问 题,其基本思想是沿着J(W)的负梯度方向不断修正W(k)值, 直至J(W)达到最小。这种方法的数学表达式为 长+0=+A2) (6.10) lw=W(k) 16

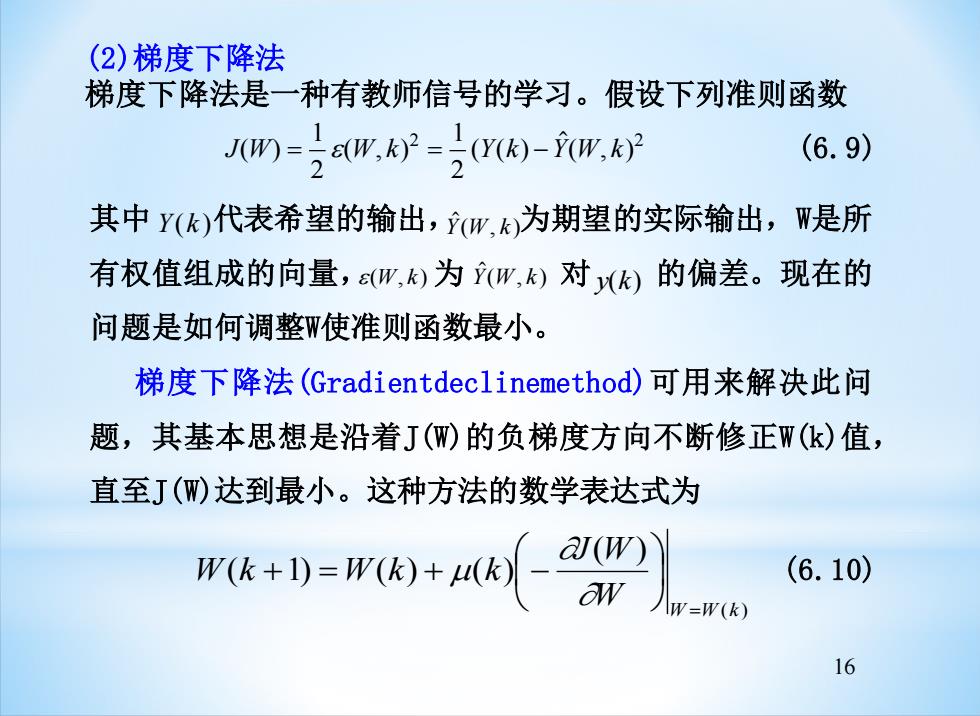

16 (2)梯度下降法 梯度下降法是一种有教师信号的学习。假设下列准则函数 J(W) (W, k) (Y(k) Y W k = = − ( , ) 1 2 1 2 2 2 (6.9) 其中 代表希望的输出, 为期望的实际输出,W是所 有权值组成的向量, 为 对 的偏差。现在的 问题是如何调整W使准则函数最小。 梯度下降法(Gradientdeclinemethod)可用来解决此问 题,其基本思想是沿着J(W)的负梯度方向不断修正W(k)值, 直至J(W)达到最小。这种方法的数学表达式为 Y(k ) Y(W, k) (W, k) Y(W, k) y(k) ( ) ( ) ( 1) ( ) ( ) W W W k J W W k W k k = + = + − (6.10)

其中是控制权值修正速度的变量,J(W)的梯度为 a(w) aw -(m,)形 lw=W(k) aw (6.11) lw=W(k) 在上述问题中,把网络的输出看成是网络权值向量W的函数, 因此网络的学习就是根据希望的输出和实际之间的误差平方最 小原则来修正网络的权向量。根据不同形式的(W,k)可推导 出相应的算法:δ规则和BP算法。 (3)Deta(d)规则 在B.WidroW的自适应线性元件中,自适应线性元件的输出表示为 Y(w,k)=w'x(k) (6.12) 其中,W=(o,4,,w,)了为权值向量,X()=(0,x,…,x)Y)为k时 刻的输入模式。 因此准则函数J(W)的梯度为: 17

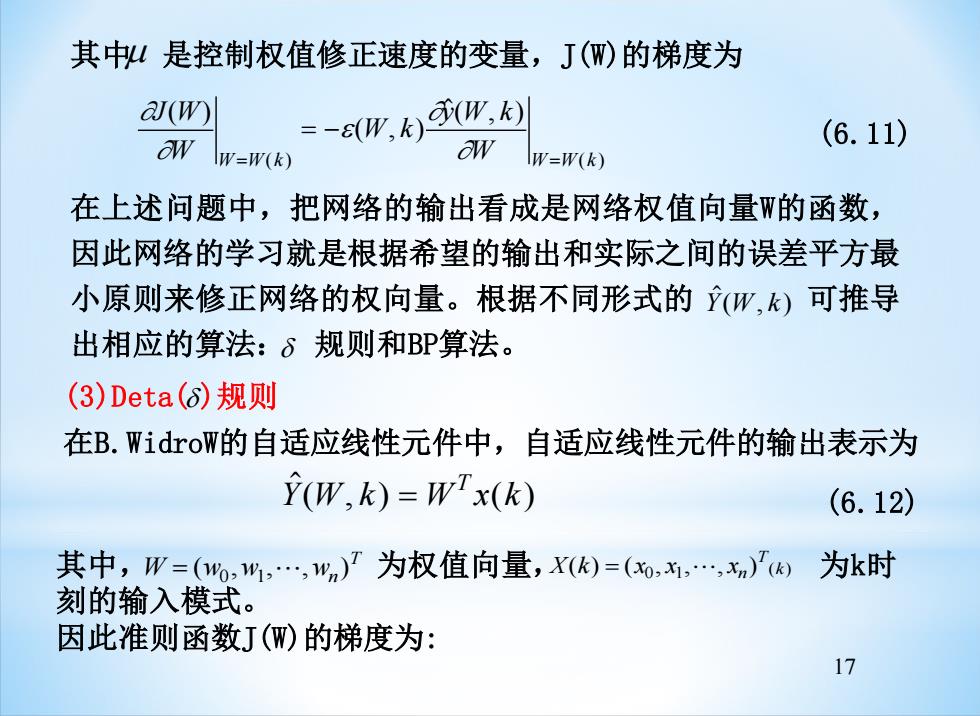

17 其中 是控制权值修正速度的变量,J(W)的梯度为 J W W W k y W k W W k W W W k ( ) ( , ) ( , ) = ( ) = ( ) = − (6.11) 在上述问题中,把网络的输出看成是网络权值向量W的函数, 因此网络的学习就是根据希望的输出和实际之间的误差平方最 小原则来修正网络的权向量。根据不同形式的 可推导 出相应的算法: 规则和BP算法。 Y(W, k) (3)Deta( )规则 在B.WidroW的自适应线性元件中,自适应线性元件的输出表示为 Y(W, k) W x(k) T = (6.12) 其中, 为权值向量, 为k时 刻的输入模式。 因此准则函数J(W)的梯度为: W w w wn T = ( , , , ) 0 1 X k x x xn T ( ) = ( 0 , 1 , , ) (k)

(W) =-c(W,k)k) =-E(W,)x(k)m=] (6.13) w-W(k) w=W(k) 当(k)=a/X时,有Widrowl的规则为 W(k+1)=Wk)+, s(W(k),k)x(k) (6.14) 是控制算法和收缩性的常数,实际中往往取0.1<o<1.0 为了便于计算,6规则可以表达下面形式: W(k+1)=W(k)+78(W(k),k)x(k) 或 W(k+1)=W(K)+1-a)s(W(k),k)X(k)+a(W(k)-W(k-1) (6.15) 其中,1常取0.01≤7≤10.0,a取0.9。 18

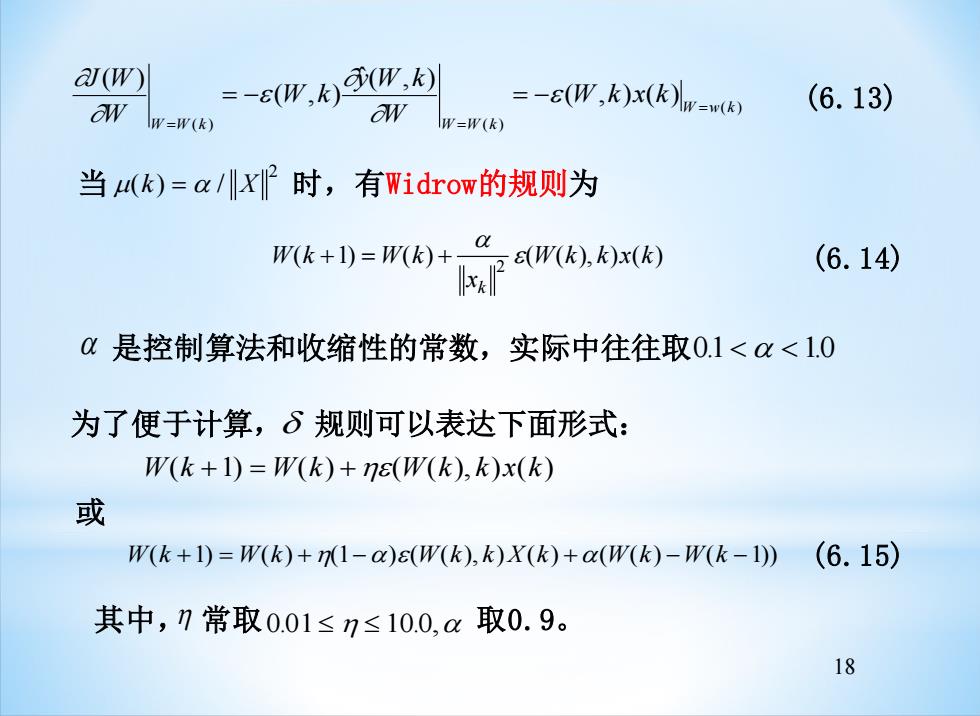

18 ( ) ( ) ( ) ( , ) ( ) ˆ( , ) ( , ) ( ) W w k W W k W W k W k x k W y W k W k W J W = = = = − = − (6.13) 当 (k) = / X 时,有Widrow的规则为 2 W k W k x W k k x k k ( +1) = ( ) + ( ( ), ) ( ) 2 (6.14) 是控制算法和收缩性的常数,实际中往往取 0.1 1.0 为了便于计算, 规则可以表达下面形式: W(k +1) = W(k) +(W(k), k)x(k) (6.15) 或 W(k +1) = W(k) +(1−)(W(k), k)X(k) +(W(k) −W(k −1)) 其中, 常取 0.01 10.0, 取0.9

(4)BP算法 误差反向传播的BP算法(Back-propagation A1 gorithm,简称为BP算法)的早在1974年Webos在他的 论文中提出一种BP学习理论,到1985年发展了BP网络训 练算法。BP网络不仅有输入层结点、输出层节点,而且 有隐层节点(可以是一层或多层)。其作用函数通常选用 连续可导的Sigmoid函数: f(x)=1/(1+exp(-x) (6.16) 19

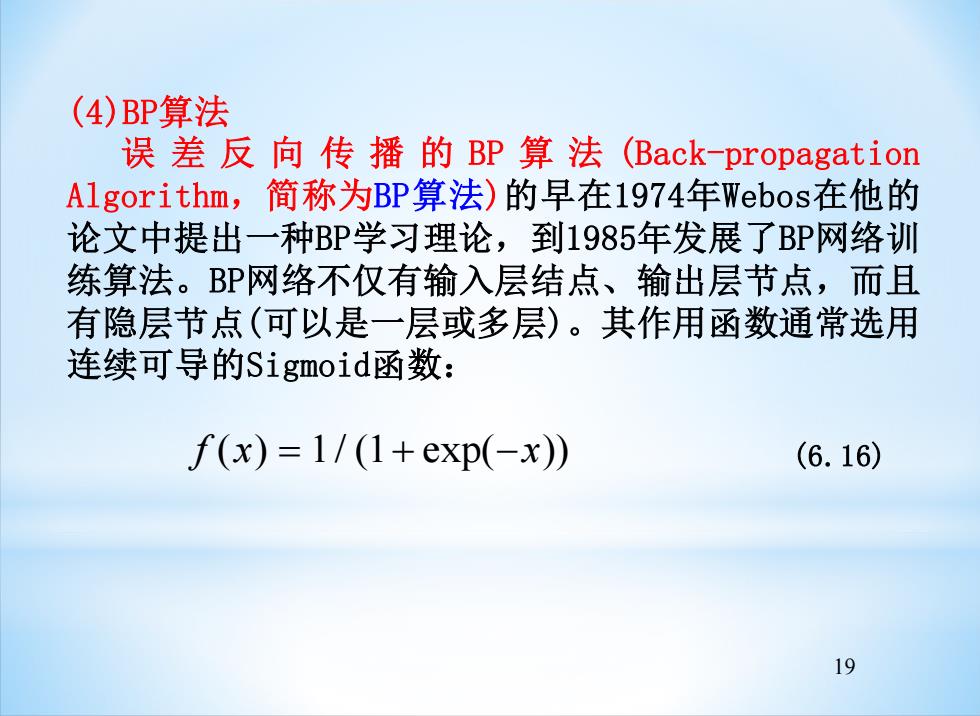

19 (4)BP算法 误 差 反 向 传 播 的 BP 算 法 (Back-propagation Algorithm,简称为BP算法)的早在1974年Webos在他的 论文中提出一种BP学习理论,到1985年发展了BP网络训 练算法。BP网络不仅有输入层结点、输出层节点,而且 有隐层节点(可以是一层或多层)。其作用函数通常选用 连续可导的Sigmoid函数: f (x) = 1/ (1+ exp(−x)) (6.16)

在系统辨识中常用的是一种典型的多层并行网,即多层 BP网。这是一种正向的、各层相互全连结的网络。对于 输入信号要经过输入层,向前传递给隐层节点。经过激 发(作用)函数后,把隐层节点的输出传递到输出节点, 再经过激发函数后才给出输出结果。如果输出层得不到 期望的输出,则转入反向传播,将误差信号沿原来的连 接通路反回。通过修改各层神经网络的权值,使过程的 输出和神经网络模型的输出之间的误差信号最小为止。 BP算法是梯度下降法的改进算法,在6.3.2中讨论BP网 络时展开讨论。 20

20 在系统辨识中常用的是一种典型的多层并行网,即多层 BP网。这是一种正向的、各层相互全连结的网络。对于 输入信号要经过输入层,向前传递给隐层节点。经过激 发(作用)函数后,把隐层节点的输出传递到输出节点, 再经过激发函数后才给出输出结果。如果输出层得不到 期望的输出,则转入反向传播,将误差信号沿原来的连 接通路反回。通过修改各层神经网络的权值,使过程的 输出和神经网络模型的输出之间的误差信号最小为止。 BP算法是梯度下降法的改进算法,在6.3.2中讨论BP网 络时展开讨论