品小上2r%训对格车 (3.25b) 得正则方程 (HiHs=Hiz (3.26) 当HH,是正则矩阵时,有 0s=(HiHL)Hiz (3.27) 且 a2J0) =2HH>0 80 (3.28) 所有满足式(3.27)的0s使Jo。.=mn,并且是唯一的。 通过极小化式(3.23)计算0,的方法称作最小二乘法,对应的9 成为最小二乘法的估计值。 21 202414120

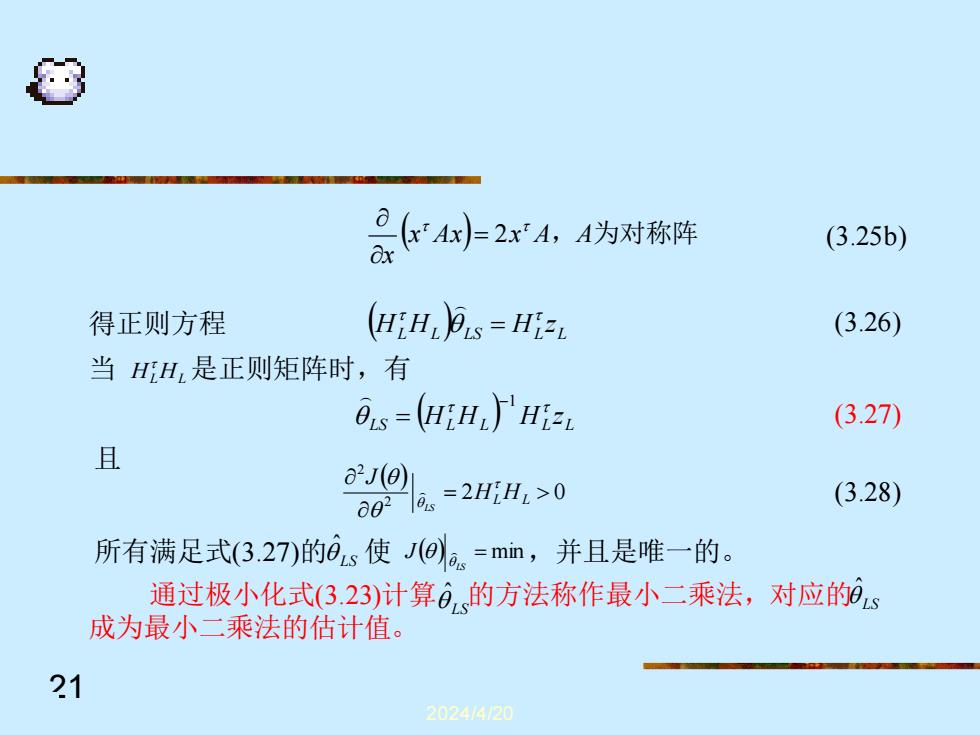

2024/4/20 21 (x Ax) x A,A为对称阵 x = 2 (3.27) (3.26) (3.28) (3.25b) 得正则方程 所有满足式(3.27)的 使 ,并且是唯一的。 且 当 是正则矩阵时,有 ( ) L L LS L L H H H z = HL HL ( ) LS L L L L H H H z −1 = ( ) 2 0 2 2 = HL HL J LS LS ˆ ( ) = min LS J LS 通过极小化式(3.23)计算 ˆ 的方法称作最小二乘法,对应的 成为最小二乘法的估计值。 LS ˆ

研究加权最小二乘WLS(Weighted Least Squares)问题时,考虑 模型 =(k)=h"(k)0+e(k) (3.29) 取准则函数 J0)=会k[E了=会4k)[zk)-N(k)0] =6z-H,0j4,6-H,0) (3.30) (与23)式比较只多了加权因子) 式中,(称为加权因子,对于有的k,A(都必须是正数。引入 加权因子的目的是为了便于考虑观测数据的可信度。如果有理由 认为现在时刻的数据比过去时刻的数据可靠,那么现在时刻的加 权值就要大于过去时刻的加权值。 22 202414120

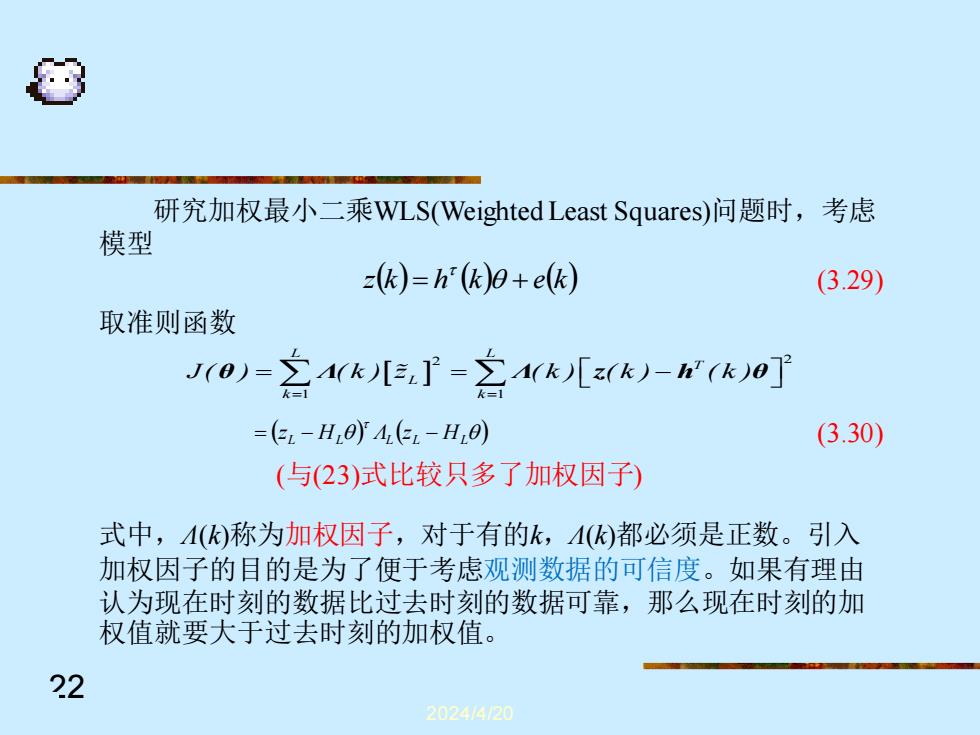

2024/4/20 22 研究加权最小二乘WLS(Weighted Least Squares)问题时,考虑 模型 z(k) = h (k) + e(k) (3.29) 取准则函数 2 2 1 1 L L T L k k J( ) ( k ) z ( k ) ( k ) ( k ) = = = = − θ Λ Λ z h θ ( ) ( ) L L L L HL = z − H Λ z − (3.30) (与(23)式比较只多了加权因子) 式中,Λ(k)称为加权因子,对于有的k,Λ(k)都必须是正数。引入 加权因子的目的是为了便于考虑观测数据的可信度。如果有理由 认为现在时刻的数据比过去时刻的数据可靠,那么现在时刻的加 权值就要大于过去时刻的加权值

比如可选(k)=-k,0<<1当k=1时,A(k)=-1<<1当=L时, A(k)=1,这就体现了对不同时刻的数据给予了不同程度的信任。( 的选择(在数据融合时非常重要),取决于人的主观因素,并无一般 规律可循。加权阵为对角阵 在一般实际应用中,如果对象是线性时不变系统,或者数据 的可信度还难以确定,则可以简单地选择()=1,Vk。若在一定条 件下,根据噪声的方差对(化)进行最佳选择,得到的估值称为 Markov估计。 根据式(3.17的定义,准则方程(0的三次型的形式为 J(0)=(z-H0j46-H0) (3.31) 23 202414120

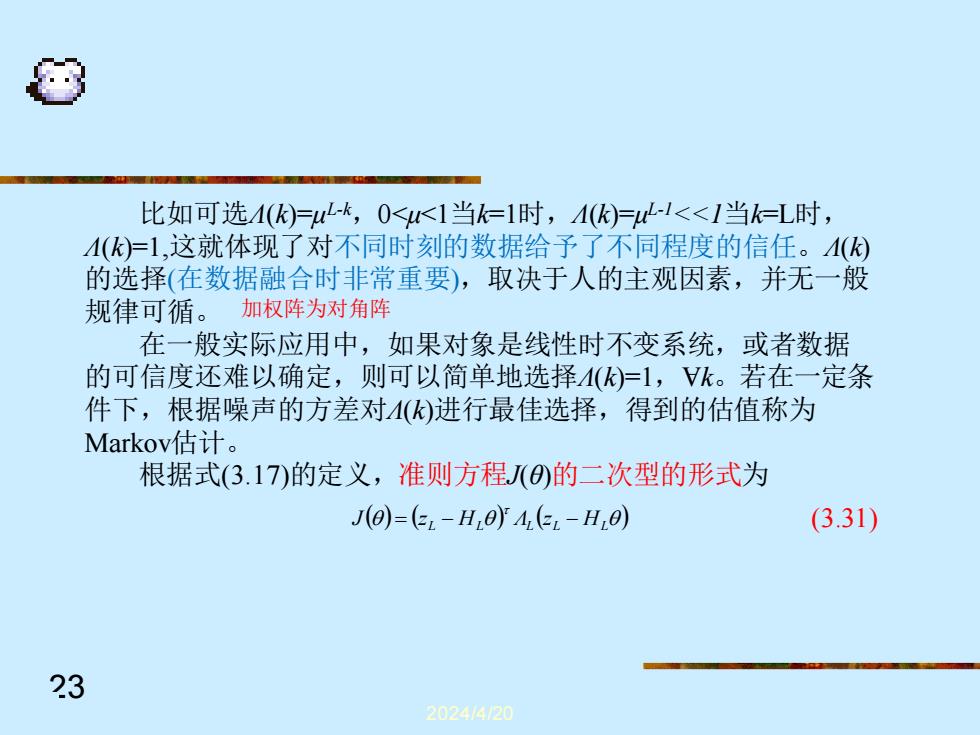

2024/4/20 23 比如可选Λ(k)=μ L-k ,0<μ<1当k=1时,Λ(k)=μ L-1<<1当k=L时, Λ(k)=1,这就体现了对不同时刻的数据给予了不同程度的信任。Λ(k) 的选择(在数据融合时非常重要),取决于人的主观因素,并无一般 规律可循。 在一般实际应用中,如果对象是线性时不变系统,或者数据 的可信度还难以确定,则可以简单地选择Λ(k)=1,Ɐk。若在一定条 件下,根据噪声的方差对Λ(k)进行最佳选择,得到的估值称为 Markov估计。 根据式(3.17)的定义,准则方程J(θ)的二次型的形式为 加权阵为对角阵 ( ) ( ) ( ) (3.31) L L L L HL J = z − H Λ z −

其中,4加权阵一般是正定矩阵,它与加权因子的关系是 4=diag[4@,A2),…,A(L】 (3.32) 显然,式(3.31)中H的代表模型的输出(估计值),或者说是系 统的输出的预报值。J()可以被看作来衡量模型输出与实际系 统输出的接近情况。 极小化J(),求得参数的估计值,将使模型的输出最好地预报 系统的输出。(与最小二乘思路相同) 设0rs使得J0a=mn,则有 a0 a,-H,0y4,6-H,0=0 (3.33) a 展开上式得正则方程 Hi4,H2)月ns=Hi4,z 3.34) 24 202414120

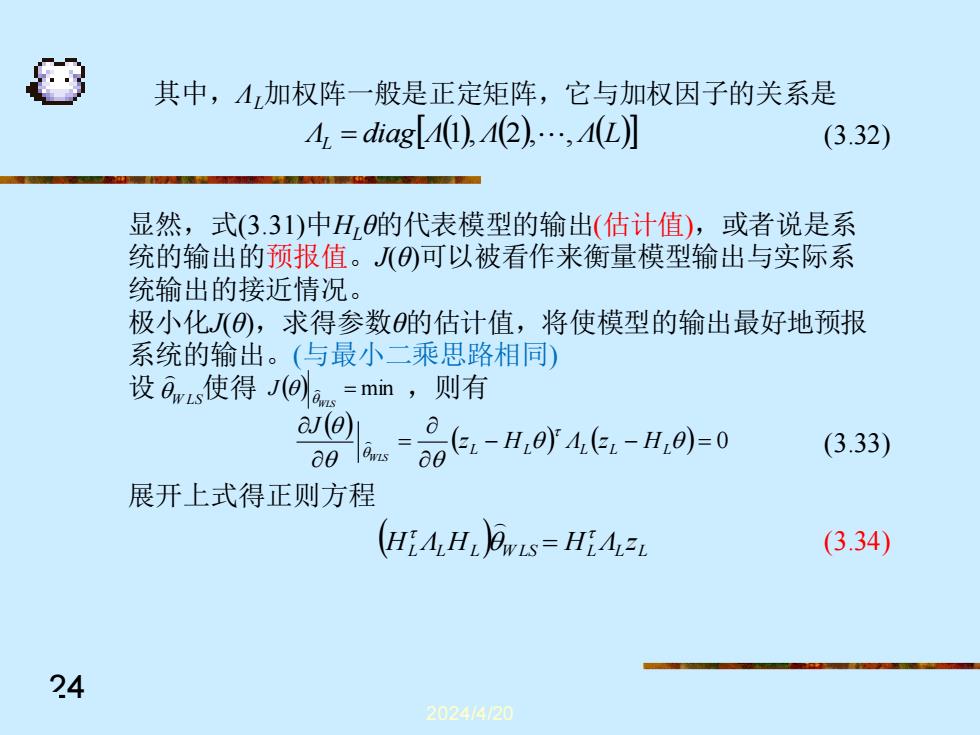

2024/4/20 24 其中,ΛL加权阵一般是正定矩阵,它与加权因子的关系是 Λ diagΛ( ) Λ( ) Λ(L) L = 1 , 2 , , (3.32) 显然,式(3.31)中HLθ的代表模型的输出(估计值),或者说是系 统的输出的预报值。J(θ)可以被看作来衡量模型输出与实际系 统输出的接近情况。 极小化J(θ),求得参数θ的估计值,将使模型的输出最好地预报 系统的输出。(与最小二乘思路相同) 设 W LS 使得 ,则有 ( ) = min WLS J ( ) ( − ) ( − ) = 0 = L L L L HL z H Λ z J WLS (3.33) 展开上式得正则方程 ( ) L L L W LS L L L H Λ H H Λ z = (3.34)

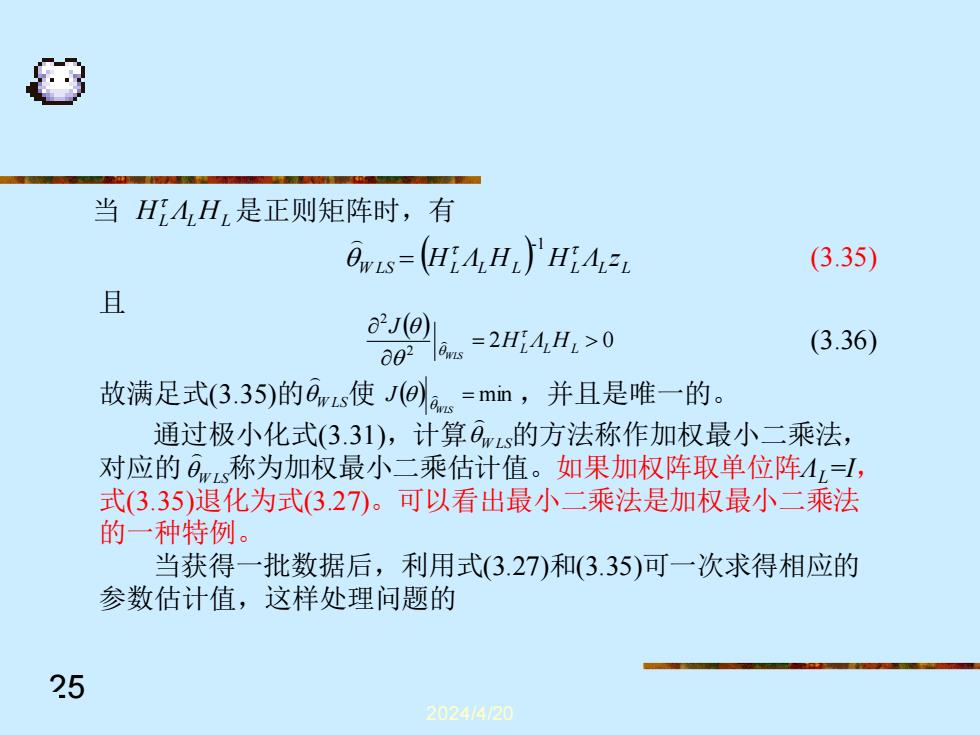

当HA,H,是正则矩阵时,有 Ovis=(HiAHL)HiA= (3.35) 且 a2J(0) 602 a=2H4,H2>0 (3.36) 故满足式(3.35)的ars使J@s=mn,并且是唯一的。 通过极小化式(3.31),计算0ms的方法称作加权最小二乘法, 对应的0称为加权最小二乘估计值。如果加权阵取单位阵4,=, 式(3.35)退化为式327。可以看出最小二乘法是加权最小二乘法 的一种特例。 当获得一批数据后,利用式(3.27)和(3.35)可一次求得相应的 参数估计值,这样处理问题的 25 202414120

2024/4/20 25 HL ΛL HL 当 是正则矩阵时,有 ( ) W LS L L L L L L H Λ H H Λ z -1 = (3.35) 且 (3.36) ( ) 2 0 2 2 = HL ΛL HL J WLS 故满足式(3.35)的 W LS 使 ,并且是唯一的。 ( ) = min WLS J 通过极小化式(3.31),计算 的方法称作加权最小二乘法, 对应的 称为加权最小二乘估计值。如果加权阵取单位阵ΛL=I, 式(3.35)退化为式(3.27)。可以看出最小二乘法是加权最小二乘法 的一种特例。 当获得一批数据后,利用式(3.27)和(3.35)可一次求得相应的 参数估计值,这样处理问题的 W LS W LS