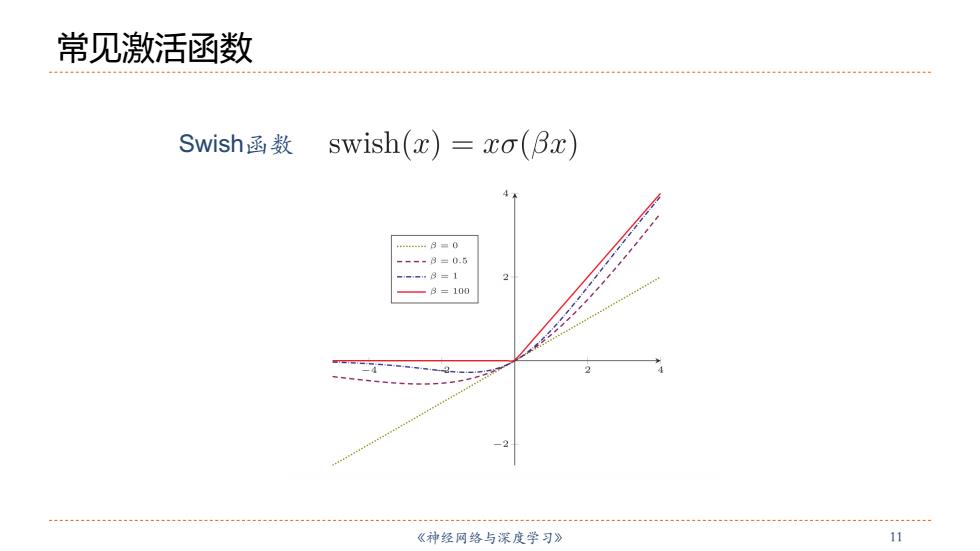

常见激活函数 Swish函数 swish(x)=xo(Bx)) ..48=0 ---8=0.5 -8=1 B=100 《神经网络与深度学习》 11

《神经⽹络与深度学习》 11 常见激活函数 Swish函数

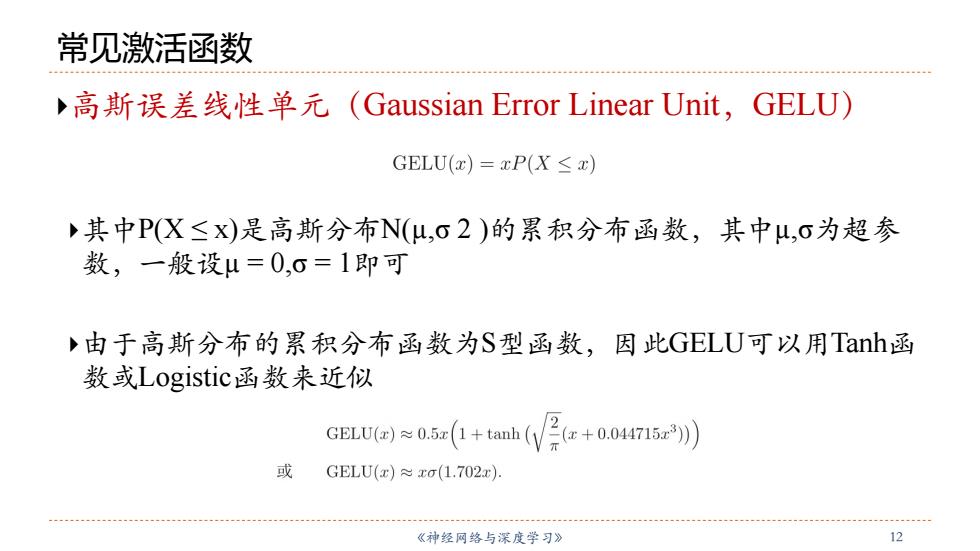

常见激活函数 ,高斯误差线性单元(Gaussian Error Linear Unit,GELU) GELU(x)=xP(X≤x) 其中P(X≤x)是高斯分布N(μ,O2)的累积分布函数,其中u,σ为超参 数,一般设μ=0,0=1即可 由于高斯分布的累积分布函数为S型函数,因此GELU可以用Tanh函 数或Logistic函数来近似 GELU≈0.i(+tah(We+o04r2)) 或 GELU(x)xo(1.702x). 《神经网络与深度学习》 12

《神经⽹络与深度学习》 12 常见激活函数 }⾼斯误差线性单元(Gaussian Error Linear Unit,GELU) }其中P(X ≤ x)是⾼斯分布N(µ,σ 2 )的累积分布函数,其中µ,σ为超参 数,⼀般设µ = 0,σ = 1即可 }由于⾼斯分布的累积分布函数为S型函数,因此GELU可以用Tanh函 数或Logistic函数来近似

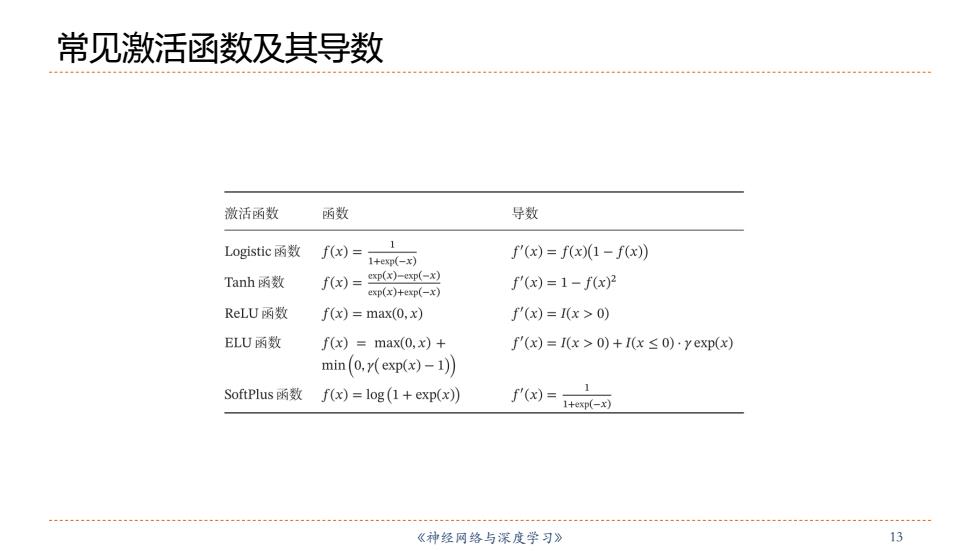

常见激活函数及其导数 激活函数 函数 导数 Logistic函数 f(x)= 1 1+exp(-x) f(x)=f(x)(1-f(x)) Tanh函数 f(x)=xp(x)-exp(-x) f'(x)=1-fx)2 exp(x)+exp(-x) ReLU函数 f(x)=max(0,x) f'(x)=I(x>0) ELU函数 f(x)=max(0,x)+ f'(x)=I(x>0)+I(x≤o)·yexp(x) min(o,y(exp(ax)-1刃 SoftPlus函数 f(x)=log(1+exp(x)) f'(x)=1+e- 1 《神经网络与深度学习》 13

《神经⽹络与深度学习》 13 常见激活函数及其导数

人工神经网络 人工神经网络主要由大量的神经元以及它们之间的有向连接 构成。因此考虑三方面: 神经元的激活规则 主要是指神经元输入到输出之间的映射关系,一般为非线性函数。 ↓网络的拓扑结构 不同神经元之间的连接关系。 学习算法 通过训练数据来学习神经网络的参数。 《神经网络与深度学习》 14

《神经⽹络与深度学习》 14 人工神经网络 }⼈⼯神经⽹络主要由⼤量的神经元以及它们之间的有向连接 构成。因此考虑三⽅面: }神经元的激活规则 }主要是指神经元输⼊到输出之间的映射关系,⼀般为非线性函数。 }⽹络的拓扑结构 }不同神经元之间的连接关系。 }学习算法 }通过训练数据来学习神经⽹络的参数

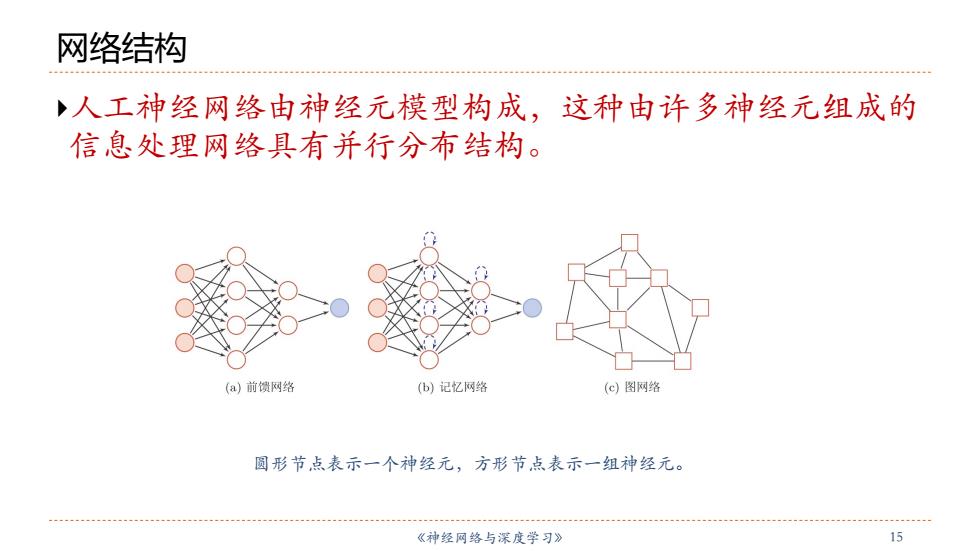

网络结构 人工神经网络由神经元模型构成,这种由许多神经元组成的 信息处理网络具有并行分布结构。 (a)前馈网络 (b)记忆网络 (c)图网络 圆形节点表示一个神经元,方形节点表示一组神经元。 《神经网络与深度学习》 15

《神经⽹络与深度学习》 15 网络结构 }⼈⼯神经⽹络由神经元模型构成,这种由许多神经元组成的 信息处理⽹络具有并⾏分布结构。 圆形节点表示⼀个神经元,⽅形节点表示⼀组神经元