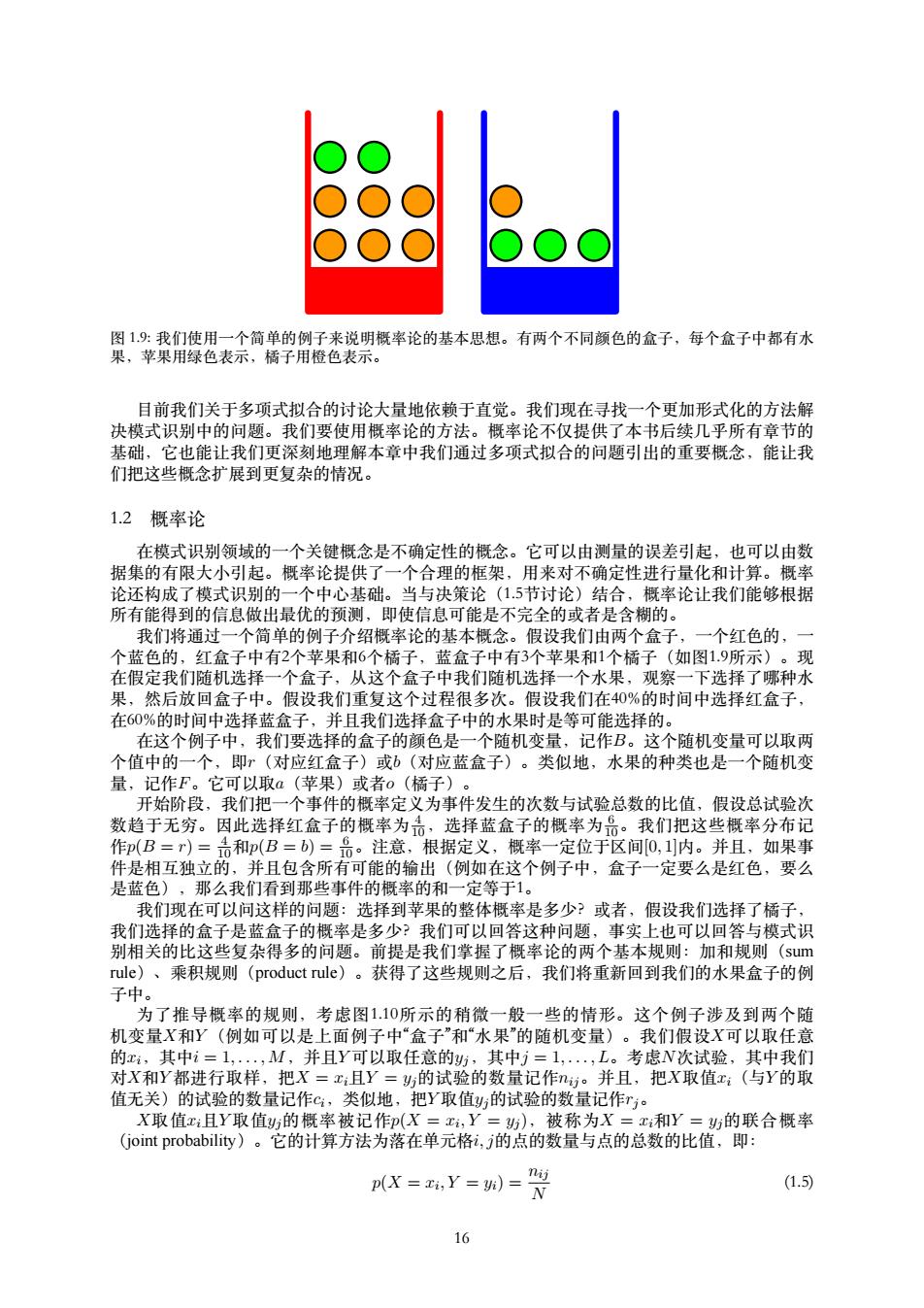

图19:我们使用一个简单的例子来说明概率论的基本思想。有两个不同颜色的盒子,每个盒子中都有水 果,苹果用绿色表示,橘子用橙色表示。 目前我们关于多项式拟合的讨论大量地依赖于直觉。我们现在寻找一个更加形式化的方法解 决模式识别中的问题。我们要使用概率论的方法。概率论不仅提供了本书后续几乎所有章节的 基础,它也能让我们更深刻地理解本章中我们通过多项式拟合的问题引出的重要概念,能让我 们把这些概念扩展到更复杂的情况。 1.2概率论 在模式识别领域的一个关键概念是不确定性的概念。它可以由测量的误差引起,也可以由数 据集的有限大小引起。概率论提供了一个合理的框架,用来对不确定性进行量化和计算。概率 论还构成了模式识别的一个中心基础。当与决策论(1.5节讨论)结合,概率论让我们能够根据 所有能得到的信息做出最优的预测,即使信息可能是不完全的或者是含糊的。 我们将通过一个简单的例子介绍概率论的基本概念。假设我们由两个盒子,一个红色的, 个蓝色的,红盒子中有2个苹果和6个橘子,蓝盒子中有3个苹果和1个橘子(如图1.9所示)。现 在假定我们随机选择一个盒子,从这个盒子中我们随机选择一个水果,观察一下选择了哪种水 果,然后放回盒子中。假设我们重复这个过程很多次。假设我们在40%的时间中选择红盒子, 在60%的时间中选择蓝盒子,并且我们选择盒子中的水果时是等可能选择的。 在这个例子中,我们要选择的盒子的颜色是一个随机变量,记作B。这个随机变量可以取两 个值中的一个,即?(对应红盒子)或b(对应蓝盒子)。类似地,水果的种类也是一个随机变 量,记作F。它可以取α(苹果)或者o(橘子)。 开始阶段,我们把一个事件的概率定义为事件发生的次数与试验总数的比值,假设总试验次 数趋于无穷。因此选择红盒子的概率为,选择蓝盒子的概率为品。我们把这些概率分布记 作p(B=r)=和p(B=b)=哥。注意,根据定义,概率一定位于区间0,1内。并且,如果事 件是相互独立的,并且包含所有可能的输出(例如在这个例子中,盒子一定要么是红色,要么 是蓝色),那么我们看到那些事件的概率的和一定等于1。 我们现在可以问这样的问题:选择到苹果的整体概率是多少?或者,假设我们选择了橘子, 我们选择的盒子是蓝盒子的概率是多少?我们可以回答这种问题,事实上也可以回答与模式识 别相关的比这些复杂得多的问题。前提是我们掌握了概率论的两个基本规则:加和规则(sum rule)、乘积规则(product rule)。获得了这些规则之后,我们将重新回到我们的水果盒子的例 子中。 为了推导概率的规则,考虑图1.10所示的稍微一般一些的情形。这个例子涉及到两个随 机变量X和Y(例如可以是上面例子中“盒子”和“水果”的随机变量)。我们假设X可以取任意 的x,其中i=1,·,M,并且Y可以取任意的y,其中j=1,·,L。考虑N次试验,其中我们 对X和Y都进行取样,把X=x:且Y=的试验的数量记作。并且,把X取值x(与Y的取 值无关)的试验的数量记作c:,类似地,把Y取值y,的试验的数量记作r。 X取值x且Y取值则的概率被记作p(X=x,Y=),被称为X=x和Y=y的联合概率 (joint probability)。它的计算方法为落在单元格i,j的点的数量与点的总数的比值,即: p(X =zi,Y=)=N nij (1.5) 16

图 1.9: 我们使⽤⼀个简单的例⼦来说明概率论的基本思想。有两个不同颜⾊的盒⼦,每个盒⼦中都有⽔ 果,苹果⽤绿⾊表⽰,橘⼦⽤橙⾊表⽰。 ⽬前我们关于多项式拟合的讨论⼤量地依赖于直觉。我们现在寻找⼀个更加形式化的⽅法解 决模式识别中的问题。我们要使⽤概率论的⽅法。概率论不仅提供了本书后续⼏乎所有章节的 基础,它也能让我们更深刻地理解本章中我们通过多项式拟合的问题引出的重要概念,能让我 们把这些概念扩展到更复杂的情况。 1.2 概率论 在模式识别领域的⼀个关键概念是不确定性的概念。它可以由测量的误差引起,也可以由数 据集的有限⼤⼩引起。概率论提供了⼀个合理的框架,⽤来对不确定性进⾏量化和计算。概率 论还构成了模式识别的⼀个中⼼基础。当与决策论(1.5节讨论)结合,概率论让我们能够根据 所有能得到的信息做出最优的预测,即使信息可能是不完全的或者是含糊的。 我们将通过⼀个简单的例⼦介绍概率论的基本概念。假设我们由两个盒⼦,⼀个红⾊的,⼀ 个蓝⾊的,红盒⼦中有2个苹果和6个橘⼦,蓝盒⼦中有3个苹果和1个橘⼦(如图1.9所⽰)。现 在假定我们随机选择⼀个盒⼦,从这个盒⼦中我们随机选择⼀个⽔果,观察⼀下选择了哪种⽔ 果,然后放回盒⼦中。假设我们重复这个过程很多次。假设我们在40%的时间中选择红盒⼦, 在60%的时间中选择蓝盒⼦,并且我们选择盒⼦中的⽔果时是等可能选择的。 在这个例⼦中,我们要选择的盒⼦的颜⾊是⼀个随机变量,记作B。这个随机变量可以取两 个值中的⼀个,即r(对应红盒⼦)或b(对应蓝盒⼦)。类似地,⽔果的种类也是⼀个随机变 量,记作F。它可以取a(苹果)或者o(橘⼦)。 开始阶段,我们把⼀个事件的概率定义为事件发⽣的次数与试验总数的⽐值,假设总试验次 数趋于⽆穷。因此选择红盒⼦的概率为 4 10,选择蓝盒⼦的概率为 6 10。我们把这些概率分布记 作p(B = r) = 4 10和p(B = b) = 6 10。注意,根据定义,概率⼀定位于区间[0, 1]内。并且,如果事 件是相互独⽴的,并且包含所有可能的输出(例如在这个例⼦中,盒⼦⼀定要么是红⾊,要么 是蓝⾊),那么我们看到那些事件的概率的和⼀定等于1。 我们现在可以问这样的问题:选择到苹果的整体概率是多少?或者,假设我们选择了橘⼦, 我们选择的盒⼦是蓝盒⼦的概率是多少?我们可以回答这种问题,事实上也可以回答与模式识 别相关的⽐这些复杂得多的问题。前提是我们掌握了概率论的两个基本规则:加和规则(sum rule)、乘积规则(product rule)。获得了这些规则之后,我们将重新回到我们的⽔果盒⼦的例 ⼦中。 为了推导概率的规则,考虑图1.10所⽰的稍微⼀般⼀些的情形。这个例⼦涉及到两个随 机变量X和Y (例如可以是上⾯例⼦中“盒⼦”和“⽔果”的随机变量)。我们假设X可以取任意 的xi,其中i = 1, . . . , M,并且Y 可以取任意的yj,其中j = 1, . . . , L。考虑N次试验,其中我们 对X和Y 都进⾏取样,把X = xi且Y = yj的试验的数量记作nij。并且,把X取值xi(与Y 的取 值⽆关)的试验的数量记作ci,类似地,把Y 取值yj的试验的数量记作rj。 X取值xi且Y 取值yj的概率被记作p(X = xi , Y = yj ),被称为X = xi和Y = yj的联合概率 (joint probability)。它的计算⽅法为落在单元格i, j的点的数量与点的总数的⽐值,即: p(X = xi , Y = yi) = nij N (1.5) 16

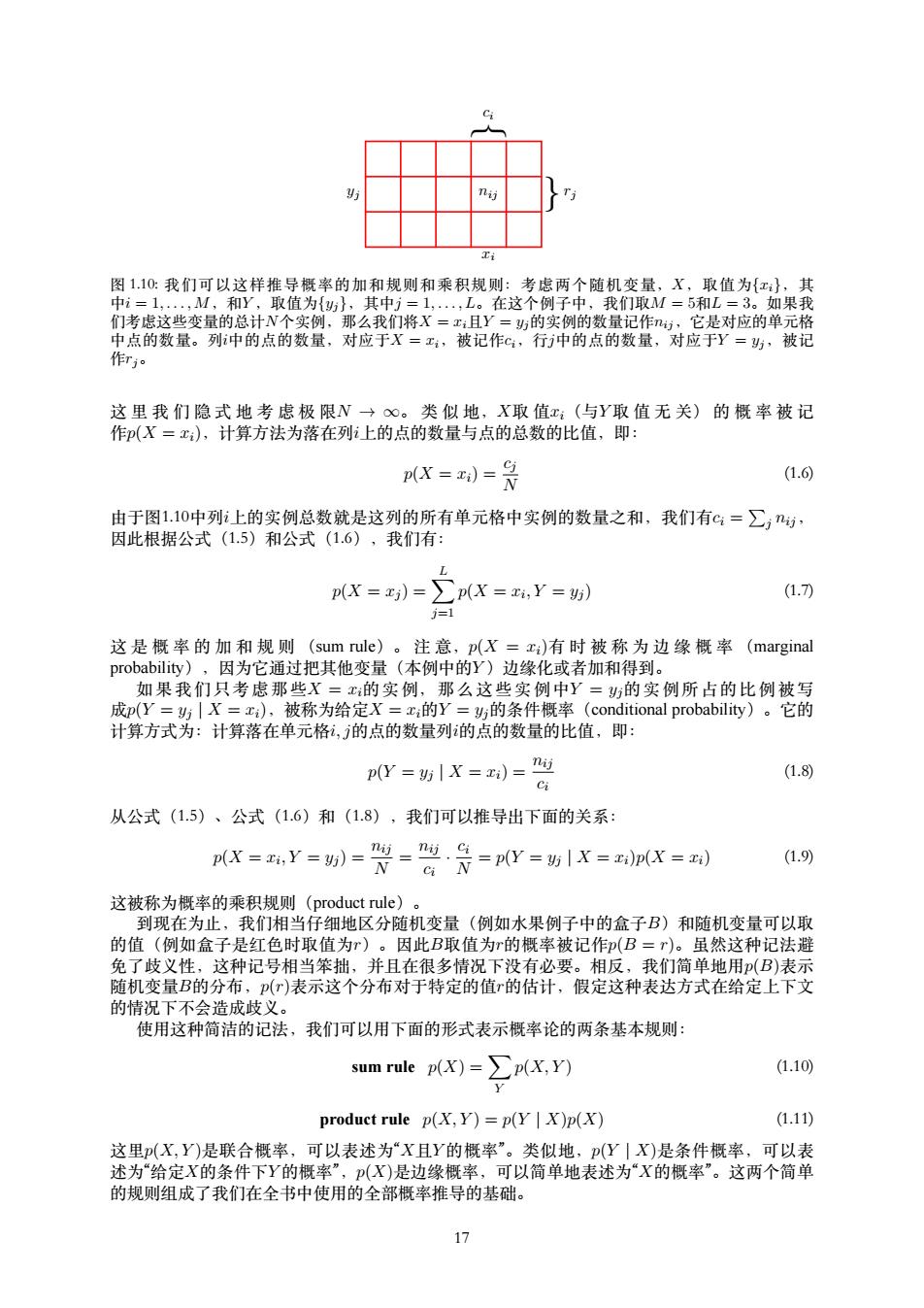

防 Ti 图1.10:我们可以这样推导概率的加和规则和乘积规则:考虑两个随机变量,X,取值为{x},其 中i=1,·,M,和Y,取值为{},其中j=1,,L。在这个例子中,我们取M=5和L=3。如果我 们考虑这些变量的总计N个实例,那么我们将X=x且Y=防的实例的数量记作,它是对应的单元格 中点的数量。列中的点的数量,对应于X=x,被记作c,行中的点的数量,对应于Y=斯,被记 作rj 这里我们隐式地考虑极限N→∞。类似地,X取值x:(与Y取值无关)的概率被记 作(X=x),计算方法为落在列i上的点的数量与点的总数的比值,即: X=)=月 (1.6 由于图1.10中列i上的实例总数就是这列的所有单元格中实例的数量之和,我们有c=∑,, 因此根据公式(1.5)和公式(1.6),我们有: L p(X=)=∑p(X=,Y=5) (1.7) 1=1 这是概率的加和规则(sum rule)。注意,p(X=x)有时被称为边缘概率(marginal probability),因为它通过把其他变量(本例中的Y)边缘化或者加和得到。 如果我们只考虑那些X=的实例,那么这些实例中Y=的实例所占的比例被写 成p(Y=|X=x),被称为给定X=x的Y=的条件概率(conditional probability)。它的 计算方式为:计算落在单元格,的点的数量列的点的数量的比值,即: pW=%1X=)=g (1.8) 从公式(1.5)、公式(1.6)和(1.8),我们可以推导出下面的关系: 0X=y=别=贤-学是=pW=X=K=到 (1.9) 这被称为概率的乘积规则(product rule)。 到现在为止,我们相当仔细地区分随机变量(例如水果例子中的盒子B)和随机变量可以取 的值(例如盒子是红色时取值为r)。因此B取值为r的概率被记作(B=r)。虽然这种记法避 免了歧义性,这种记号相当笨拙,并且在很多情况下没有必要。相反,我们简单地用(B)表示 随机变量B的分布,(r)表示这个分布对于特定的值r的估计,假定这种表达方式在给定上下文 的情况下不会造成歧义。 使用这种简洁的记法,我们可以用下面的形式表示概率论的两条基本规则: sum rule p(X)=∑p(X,Y) (1.10) product rule p(X,Y)=p(Y X)p(X) (1.11) 这里(X,Y)是联合概率,可以表述为“X且Y的概率”。类似地,p(Y|X)是条件概率,可以表 述为“给定X的条件下Y的概率”,p(X)是边缘概率,可以简单地表述为“X的概率”。这两个简单 的规则组成了我们在全书中使用的全部概率推导的基础。 17

} } ci yj rj xi nij 图 1.10: 我们可以这样推导概率的加和规则和乘积规则:考虑两个随机变量,X,取值为{xi},其 中i = 1, . . . , M,和Y ,取值为{yj},其中j = 1, . . . , L。在这个例⼦中,我们取M = 5和L = 3。如果我 们考虑这些变量的总计N个实例,那么我们将X = xi且Y = yj的实例的数量记作nij,它是对应的单元格 中点的数量。列i中的点的数量,对应于X = xi,被记作ci,⾏j中的点的数量,对应于Y = yj,被记 作rj。 这 ⾥ 我 们 隐 式 地 考 虑 极 限N → ∞。 类 似 地,X取 值xi(与Y 取 值 ⽆ 关) 的 概 率 被 记 作p(X = xi),计算⽅法为落在列i上的点的数量与点的总数的⽐值,即: p(X = xi) = cj N (1.6) 由于图1.10中列i上的实例总数就是这列的所有单元格中实例的数量之和,我们有ci = ∑ j nij, 因此根据公式(1.5)和公式(1.6),我们有: p(X = xj ) = ∑ L j=1 p(X = xi , Y = yj ) (1.7) 这 是 概 率 的 加 和 规 则 (sum rule)。 注 意,p(X = xi)有 时 被 称 为 边 缘 概 率 (marginal probability),因为它通过把其他变量(本例中的Y )边缘化或者加和得到。 如 果 我 们 只 考 虑 那 些X = xi的 实 例, 那 么 这 些 实 例 中Y = yj的 实 例 所 占 的 ⽐ 例 被 写 成p(Y = yj | X = xi),被称为给定X = xi的Y = yj的条件概率(conditional probability)。它的 计算⽅式为:计算落在单元格i, j的点的数量列i的点的数量的⽐值,即: p(Y = yj | X = xi) = nij ci (1.8) 从公式(1.5)、公式(1.6)和(1.8),我们可以推导出下⾯的关系: p(X = xi , Y = yj ) = nij N = nij ci · ci N = p(Y = yj | X = xi)p(X = xi) (1.9) 这被称为概率的乘积规则(product rule)。 到现在为⽌,我们相当仔细地区分随机变量(例如⽔果例⼦中的盒⼦B)和随机变量可以取 的值(例如盒⼦是红⾊时取值为r)。因此B取值为r的概率被记作p(B = r)。虽然这种记法避 免了歧义性,这种记号相当笨拙,并且在很多情况下没有必要。相反,我们简单地⽤p(B)表⽰ 随机变量B的分布,p(r)表⽰这个分布对于特定的值r的估计,假定这种表达⽅式在给定上下⽂ 的情况下不会造成歧义。 使⽤这种简洁的记法,我们可以⽤下⾯的形式表⽰概率论的两条基本规则: sum rule p(X) = ∑ Y p(X, Y ) (1.10) product rule p(X, Y ) = p(Y | X)p(X) (1.11) 这⾥p(X, Y )是联合概率,可以表述为“X且Y 的概率”。类似地,p(Y | X)是条件概率,可以表 述为“给定X的条件下Y 的概率”,p(X)是边缘概率,可以简单地表述为“X的概率”。这两个简单 的规则组成了我们在全书中使⽤的全部概率推导的基础。 17

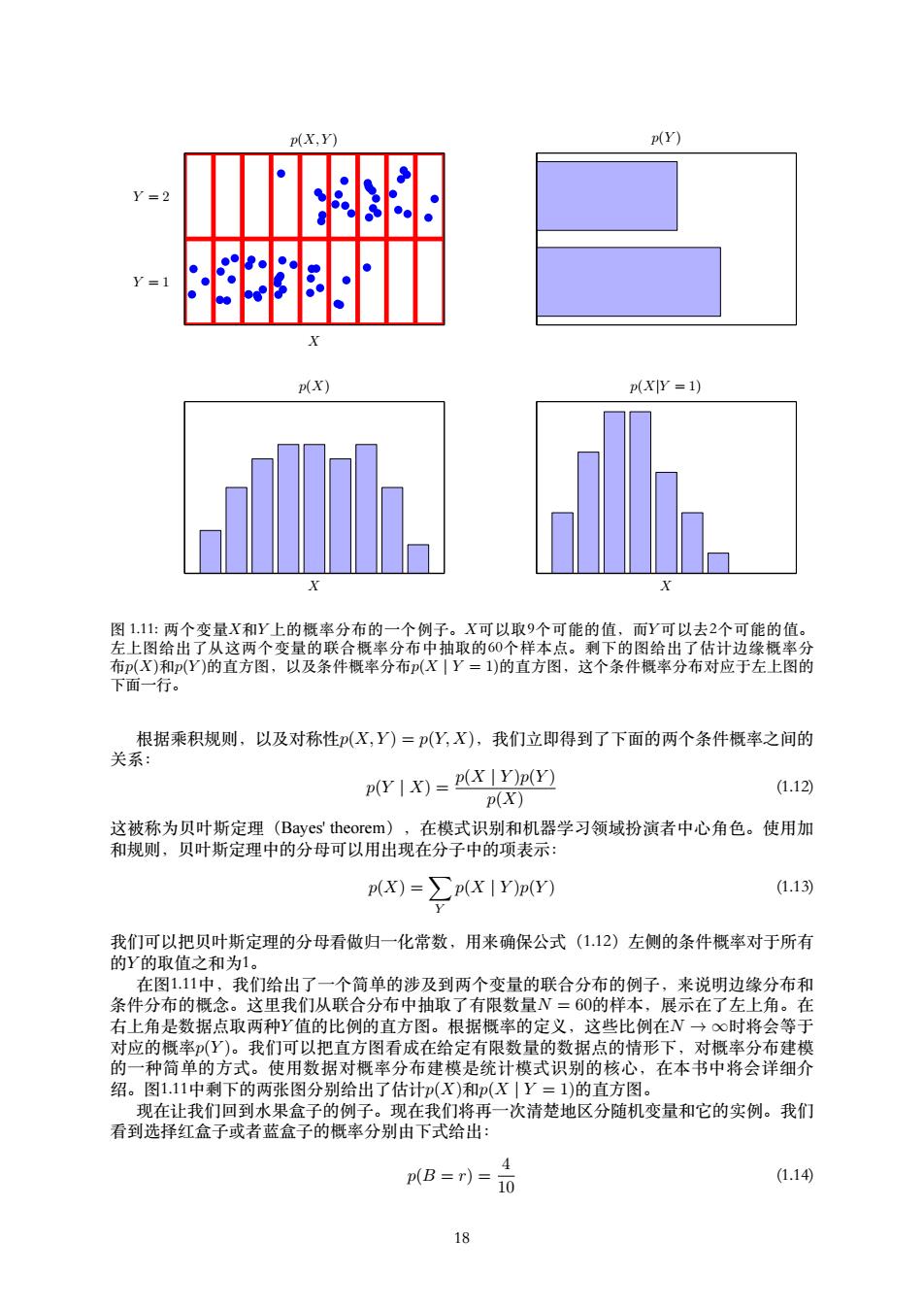

p(X,Y) p(Y) Y=2 =1 X p(x) p(XY=1) X X 图1.11:两个变量X和Y上的概率分布的一个例子。X可以取9个可能的值,而Y可以去2个可能的值。 左上图给出了从这两个变量的联合概率分布中抽取的60个样本点。剩下的图给出了估计边缘概率分 布(X)和(Y)的直方图,以及条件概率分布(X|Y=1)的直方图,这个条件概率分布对应于左上图的 下面一行。 根据乘积规则,以及对称性(X,Y)=p(Y,X),我们立即得到了下面的两个条件概率之间的 关系: (Y =(X I)p(Y) (1.12) p(X) 这被称为贝叶斯定理(Bayes'theorem),在模式识别和机器学习领域扮演者中心角色。使用加 和规则,贝叶斯定理中的分母可以用出现在分子中的项表示: pX)=∑p(XIY)pY) (1.13) 我们可以把贝叶斯定理的分母看做归一化常数,用来确保公式(112)左侧的条件概率对于所有 的Y的取值之和为1。 在图111中,我们给出了一个简单的涉及到两个变量的联合分布的例子,来说明边缘分布和 条件分布的概念。这里我们从联合分布中抽取了有限数量N=60的样本,展示在了左上角。在 右上角是数据点取两种Y值的比例的直方图。根据概率的定义,这些比例在N→○时将会等于 对应的概率(Y)。我们可以把直方图看成在给定有限数量的数据点的情形下,对概率分布建模 的一种简单的方式。使用数据对概率分布建模是统计模式识别的核心,在本书中将会详细介 绍。图1.11中剩下的两张图分别给出了估计P(X)和p(X|Y=1)的直方图。 现在让我们回到水果盒子的例子。现在我们将再一次清楚地区分随机变量和它的实例。我们 看到选择红盒子或者蓝盒子的概率分别由下式给出: 4 p(B=r)= (1.14) 18

p(X,Y ) X Y = 2 Y = 1 p(Y ) p(X) X X p(X|Y = 1) 图 1.11: 两个变量X和Y 上的概率分布的⼀个例⼦。X可以取9个可能的值,⽽Y 可以去2个可能的值。 左上图给出了从这两个变量的联合概率分布中抽取的60个样本点。剩下的图给出了估计边缘概率分 布p(X)和p(Y )的直⽅图,以及条件概率分布p(X | Y = 1)的直⽅图,这个条件概率分布对应于左上图的 下⾯⼀⾏。 根据乘积规则,以及对称性p(X, Y ) = p(Y, X),我们⽴即得到了下⾯的两个条件概率之间的 关系: p(Y | X) = p(X | Y )p(Y ) p(X) (1.12) 这被称为贝叶斯定理(Bayes' theorem),在模式识别和机器学习领域扮演者中⼼⾓⾊。使⽤加 和规则,贝叶斯定理中的分母可以⽤出现在分⼦中的项表⽰: p(X) = ∑ Y p(X | Y )p(Y ) (1.13) 我们可以把贝叶斯定理的分母看做归⼀化常数,⽤来确保公式(1.12)左侧的条件概率对于所有 的Y 的取值之和为1。 在图1.11中,我们给出了⼀个简单的涉及到两个变量的联合分布的例⼦,来说明边缘分布和 条件分布的概念。这⾥我们从联合分布中抽取了有限数量N = 60的样本,展⽰在了左上⾓。在 右上⾓是数据点取两种Y 值的⽐例的直⽅图。根据概率的定义,这些⽐例在N → ∞时将会等于 对应的概率p(Y )。我们可以把直⽅图看成在给定有限数量的数据点的情形下,对概率分布建模 的⼀种简单的⽅式。使⽤数据对概率分布建模是统计模式识别的核⼼,在本书中将会详细介 绍。图1.11中剩下的两张图分别给出了估计p(X)和p(X | Y = 1)的直⽅图。 现在让我们回到⽔果盒⼦的例⼦。现在我们将再⼀次清楚地区分随机变量和它的实例。我们 看到选择红盒⼦或者蓝盒⼦的概率分别由下式给出: p(B = r) = 4 10 (1.14) 18

AB=)=品 (1.15) 注意,这两个式子满足p(B=)+p(B=b)=1。 现在假设我们随机选择一个盒子,结果发现是蓝盒子。然后我们选择苹果的概率就是蓝盒子 中苹果的比例(等于是),因此(F=a|B=b)=。实际上,我们可以写出给定盒子种类的 条件下水果种类的全部四个概率: 1 p(F=a|B=r)=4 (1.16 MF=o|B=)= 4 (1.17) 3 p(F=alB=b)= (1.18) 1 p(F=0B=6)= (1.19) 还要注意,这些概率是归一化的,所以 p(F=aB=r)+p(F=0|B=r)=1 (1.20 类似地 p(F=aB=b)+p(F=0B=6)=1 (1.21) 我们现在使用加和规则和乘积规则来计算选择一个苹果的整体概率: p(F=a)=p(F=a B=r)p(B=r)+p(F=alB=b)p(B=6) 143611 (1.22) 4×10+4×10=20 使用加和规则,可以计算出(F=o)=1-品=易。 反过来,假设我们知道被选择的水果是橘子,我们想知道它来自于哪个盒子。这需要我们在 给定水果种类的条件下估计盒子的概率分布,然而公式(1.16)至公式(1.19)给出的是在已知 盒子颜色的情形下水果的概率分布。我们可以使用贝叶斯定理来解决这种逆转的条件概率问 题: (B=rIF=0)=F=0IB=r)p(B=r)34 20 2 (1.23) p(F=o) 4×10×g=3 根据加和规则,我们可以计算出(B=b|F=o)=1-号=。 我们可以按照下面的方式表述贝叶斯定理。如果在我们知道水果的种类之前,有人问我们哪 个盒子被选中,那么我们能够得到的最多的信息就是概率(B)。我们把这个叫做先验概率 (prior probability),因为它是在我们观察到水果种类之前就能够得到的概率。一旦我们知道水 果是橘子,我们就能够使用贝叶斯定理来计算概率p(B|F)。这个被称为后验概率(posterion probability),因为它是我们观察到F之后的概率。注意,在这个例子中,选择红盒子的先验概 率是盖,所以与红盒子相比,我们更有可能选择蓝盒子。然而,一旦我们观察到选择的水果是 橘子,我们发现红盒子的后验概率现在是,因此现在实际上更可能选择的是红盒子。这个结果 与我们的直觉相符,因为红盒子中橘子的比例比蓝盒子高得多,因此观察到水果是橘子这件事 提供给我们更强的证据来选择红盒子。事实上,这个证据相当强,已经超过了先验的假设,使 得红盒子被选择的可能性大于蓝盒子。 最后,如果两个变量的联合分布可以分解成两个边缘分布的乘积,即(X,Y)=p(X)(Y), 那么我们说X和Y相互独立(independent)。根据乘积规则,我们可以得到p(Y|X)=p(Y), 因此对于给定X的条件下的Y的条件分布实际上独立于X的值。例如,在我们的水果盒子的例子 中,如果每个盒子包含同样比例的苹果和橘子,那么(F|B)=P(F),从而选择苹果的概率就 与选择了哪个盒子无关。 19

p(B = b) = 6 10 (1.15) 注意,这两个式⼦满⾜p(B = r) + p(B = b) = 1。 现在假设我们随机选择⼀个盒⼦,结果发现是蓝盒⼦。然后我们选择苹果的概率就是蓝盒⼦ 中苹果的⽐例(等于3 4),因此p(F = a | B = b) = 3 4。实际上,我们可以写出给定盒⼦种类的 条件下⽔果种类的全部四个概率: p(F = a | B = r) = 1 4 (1.16) p(F = o | B = r) = 3 4 (1.17) p(F = a | B = b) = 3 4 (1.18) p(F = o | B = b) = 1 4 (1.19) 还要注意,这些概率是归⼀化的,所以 p(F = a | B = r) + p(F = o | B = r) = 1 (1.20) 类似地 p(F = a | B = b) + p(F = o | B = b) = 1 (1.21) 我们现在使⽤加和规则和乘积规则来计算选择⼀个苹果的整体概率: p(F = a) = p(F = a | B = r)p(B = r) + p(F = a | B = b)p(B = b) = 1 4 × 4 10 + 3 4 × 6 10 = 11 20 (1.22) 使⽤加和规则,可以计算出p(F = o) = 1 − 11 20 = 9 20。 反过来,假设我们知道被选择的⽔果是橘⼦,我们想知道它来⾃于哪个盒⼦。这需要我们在 给定⽔果种类的条件下估计盒⼦的概率分布,然⽽公式(1.16)⾄公式(1.19)给出的是在已知 盒⼦颜⾊的情形下⽔果的概率分布。我们可以使⽤贝叶斯定理来解决这种逆转的条件概率问 题: p(B = r | F = o) = p(F = o | B = r)p(B = r) p(F = o) = 3 4 × 4 10 × 20 9 = 2 3 (1.23) 根据加和规则,我们可以计算出p(B = b | F = o) = 1 − 2 3 = 1 3。 我们可以按照下⾯的⽅式表述贝叶斯定理。如果在我们知道⽔果的种类之前,有⼈问我们哪 个盒⼦被选中,那么我们能够得到的最多的信息就是概率p(B)。我们把这个叫做先验概率 (prior probability),因为它是在我们观察到⽔果种类之前就能够得到的概率。⼀旦我们知道⽔ 果是橘⼦,我们就能够使⽤贝叶斯定理来计算概率p(B | F)。这个被称为后验概率(posterior probability),因为它是我们观察到F之后的概率。注意,在这个例⼦中,选择红盒⼦的先验概 率是 4 10,所以与红盒⼦相⽐,我们更有可能选择蓝盒⼦。然⽽,⼀旦我们观察到选择的⽔果是 橘⼦,我们发现红盒⼦的后验概率现在是2 3,因此现在实际上更可能选择的是红盒⼦。这个结果 与我们的直觉相符,因为红盒⼦中橘⼦的⽐例⽐蓝盒⼦⾼得多,因此观察到⽔果是橘⼦这件事 提供给我们更强的证据来选择红盒⼦。事实上,这个证据相当强,已经超过了先验的假设,使 得红盒⼦被选择的可能性⼤于蓝盒⼦。 最后,如果两个变量的联合分布可以分解成两个边缘分布的乘积,即p(X, Y ) = p(X)p(Y ), 那么我们说X和Y 相互独⽴(independent)。根据乘积规则,我们可以得到p(Y | X) = p(Y ), 因此对于给定X的条件下的Y 的条件分布实际上独⽴于X的值。例如,在我们的⽔果盒⼦的例⼦ 中,如果每个盒⼦包含同样⽐例的苹果和橘⼦,那么p(F | B) = P(F),从⽽选择苹果的概率就 与选择了哪个盒⼦⽆关。 19

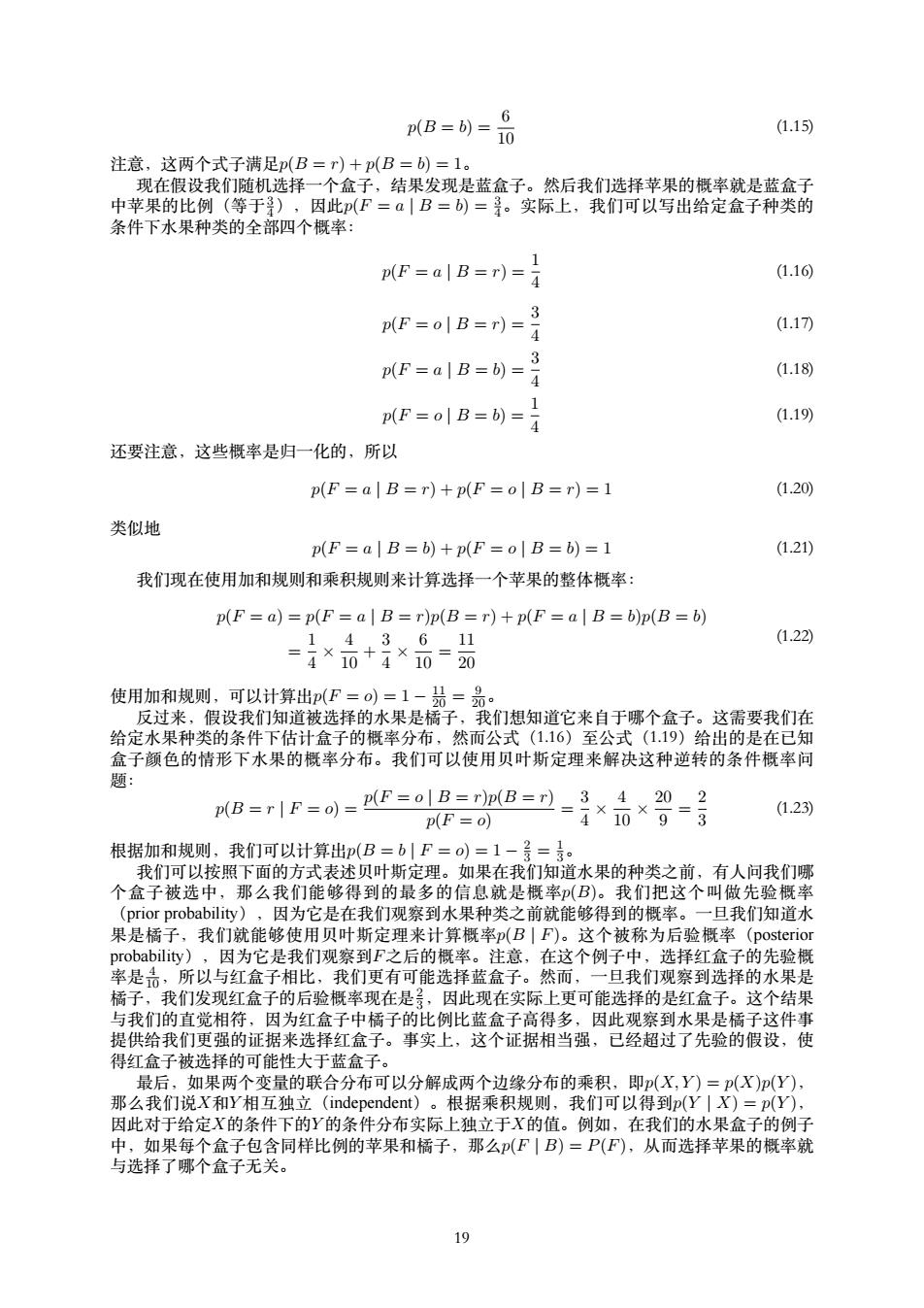

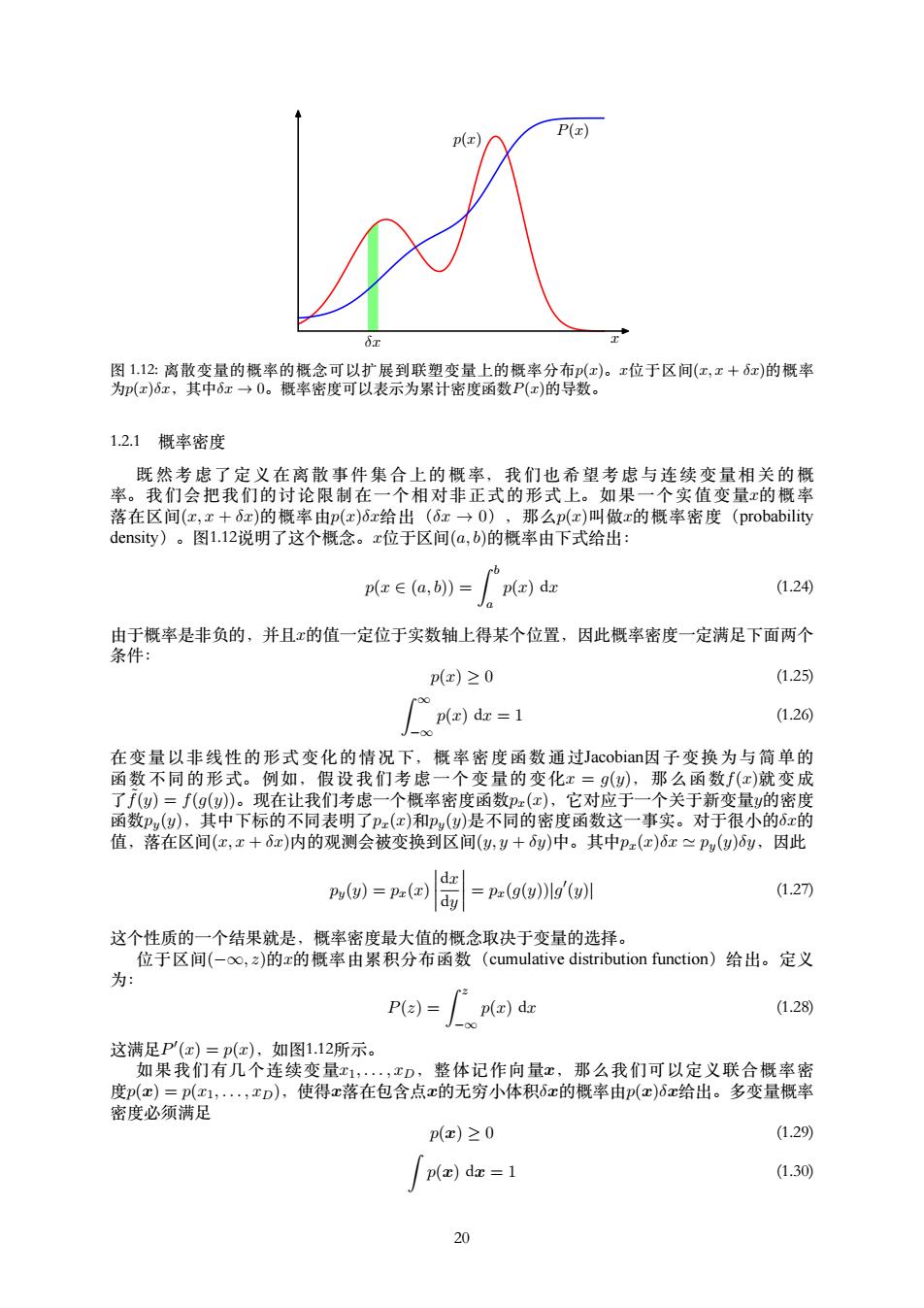

P(x) P(x) 2 图1.12:离散变量的概率的概念可以扩展到联塑变量上的概率分布(x)。x位于区间(x,x+6x)的概率 为p(x)6z,其中6x→0。概率密度可以表示为累计密度函数P(z)的导数。 1.2.1概率密度 既然考虑了定义在离散事件集合上的概率,我们也希望考虑与连续变量相关的概 率。我们会把我们的讨论限制在一个相对非正式的形式上。如果一个实值变量x的概率 落在区间(x,x+6x)的概率由p(x)6x给出(6x→O),那么p(x)叫做x的概率密度(probability density)。图1.12说明了这个概念。x位于区间(a,b)的概率由下式给出: p(x∈(a,b)= p(x)dx (1.24 由于概率是非负的,并且x的值一定位于实数轴上得某个位置,因此概率密度一定满足下面两个 条件: p(x)≥0 (1.25) fpla)dr=1 (1.26) 在变量以非线性的形式变化的情况下,概率密度函数通过Jacobian因子变换为与简单的 函数不同的形式。例如,假设我们考虑一个变量的变化x=g(y),那么函数f(x)就变成 了f()=f(9()。现在让我们考虑一个概率密度函数Px(x),它对应于一个关于新变量y的密度 函数P(y),其中下标的不同表明了px(x)和P(y)是不同的密度函数这一事实。对于很小的6x的 值,落在区间(x,x+6x)内的观测会被变换到区间(y,y+y)中。其中Px(x)6x≈Py(y)y,因此 Py(y)=Pz(x) d如 (1.27) dy =pz(g(y)lg'(y)川 这个性质的一个结果就是,概率密度最大值的概念取决于变量的选择。 位于区间(-oo,之)的x的概率由累积分布函数(cumulative distribution function)给出。定义 为: P(2)=p(z)dx (1.28) -00 这满足P(x)=p(x),如图1.12所示。 如果我们有几个连续变量x1,,xD,整体记作向量x,那么我们可以定义联合概率密 度p(c)=p(x1,.·,xD),使得c落在包含点c的无穷小体积6c的概率由p(c)6x给出。多变量概率 密度必须满足 p(c)≥0 (1.29) p(x)dx =1 (1.30) 20

δx x p(x) P(x) 图 1.12: 离散变量的概率的概念可以扩展到联塑变量上的概率分布p(x)。x位于区间(x, x + δx)的概率 为p(x)δx,其中δx → 0。概率密度可以表⽰为累计密度函数P(x)的导数。 1.2.1 概率密度 既 然 考 虑 了 定 义 在 离 散 事 件 集 合 上 的 概 率, 我 们 也 希 望 考 虑 与 连 续 变 量 相 关 的 概 率。 我 们 会 把 我 们 的 讨 论 限 制 在 ⼀ 个 相 对 ⾮ 正 式 的 形 式 上。 如 果 ⼀ 个 实 值 变 量x的 概 率 落在区间(x, x + δx)的概率由p(x)δx给出(δx → 0),那么p(x)叫做x的概率密度(probability density)。图1.12说明了这个概念。x位于区间(a, b)的概率由下式给出: p(x ∈ (a, b)) = ∫ b a p(x) dx (1.24) 由于概率是⾮负的,并且x的值⼀定位于实数轴上得某个位置,因此概率密度⼀定满⾜下⾯两个 条件: p(x) ≥ 0 (1.25) ∫ ∞ −∞ p(x) dx = 1 (1.26) 在 变 量 以 ⾮ 线 性 的 形 式 变 化 的 情 况 下, 概 率 密 度 函 数 通 过Jacobian因 ⼦ 变 换 为 与 简 单 的 函 数 不 同 的 形 式。 例 如, 假 设 我 们 考 虑 ⼀ 个 变 量 的 变 化x = g(y), 那 么 函 数f(x)就 变 成 了 ˜f(y) = f(g(y))。现在让我们考虑⼀个概率密度函数px(x),它对应于⼀个关于新变量y的密度 函数py(y),其中下标的不同表明了px(x)和py(y)是不同的密度函数这⼀事实。对于很⼩的δx的 值,落在区间(x, x + δx)内的观测会被变换到区间(y, y + δy)中。其中px(x)δx ≃ py(y)δy,因此 py(y) = px(x) dx dy = px(g(y))|g ′ (y)| (1.27) 这个性质的⼀个结果就是,概率密度最⼤值的概念取决于变量的选择。 位于区间(−∞, z)的x的概率由累积分布函数(cumulative distribution function)给出。定义 为: P(z) = ∫ z −∞ p(x) dx (1.28) 这满⾜P ′ (x) = p(x),如图1.12所⽰。 如果我们有⼏个连续变量x1, . . . , xD,整体记作向量x,那么我们可以定义联合概率密 度p(x) = p(x1, . . . , xD),使得x落在包含点x的⽆穷⼩体积δx的概率由p(x)δx给出。多变量概率 密度必须满⾜ p(x) ≥ 0 (1.29) ∫ p(x) dx = 1 (1.30) 20