相对熵relative entropy) 也称为KL散度(Kullback-Leibler divergence,简称KLD)、信息散度 (information divergence)、信息增益(information gain)。 ●相对熵的定义:是交叉熵与信息熵的差值。表示用分布Q模拟真实分 布P,所需的额外信息。 ·计算公式为 Dku(PIQ)=∑P(iog( =.P()iog Q() P(x) 交叉熵 信息熵 哈尔滨工业大学计算机学院刘远超 6

相对熵(relative entropy) l 也称为KL散度(Kullback–Leibler divergence,简称KLD)、信息散度 (information divergence)、信息增益(information gain)。 l 相对熵的定义:是交叉熵与信息熵的差值。表示⽤分布Q模拟真实分 布P,所需的额外信息。 l 计算公式为 ���(�| � = 1 �∈� � � ��� � � � − 1 �∈� � � ��� � � � = 1 �∈� � � ��� �(�) �(�) 哈尔滨工业大学计算机学院 刘远超 6 交叉熵 信息熵

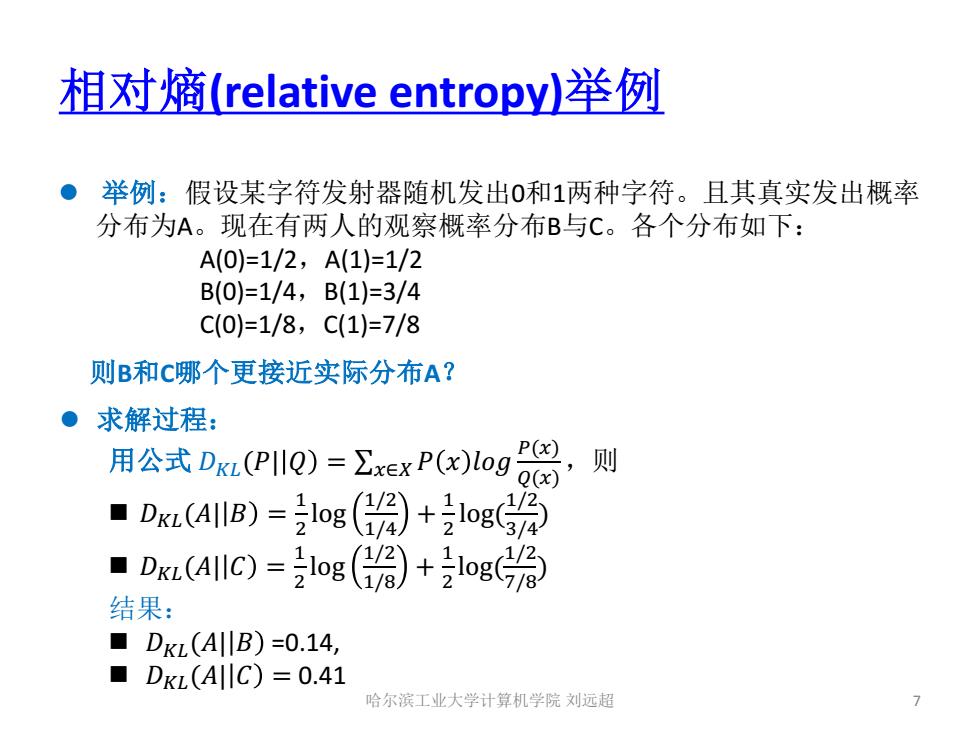

相对熵(relative entropy举例 ●举例:假设某字符发射器随机发出0和1两种字符。且其真实发出概率 分布为A。现在有两人的观察概率分布B与C。各个分布如下: A(0)=1/2,A(1)=1/2 B(0)=1/4,B(1)=3/4 C(0)=1/8,C(1)=7/8 则B和C哪个更接近实际分布A? ●求解过程: 用公式Du(PIQ)=∑exP(og ,则 ·Dx(4B)=log()+21g() ·D(4lC)=1og()+g(3) 结果: ■DK(AIB)=0.14, ■Dk(AIC)=0.41 哈尔滨工业大学计算机学院刘远超 7

相对熵(relative entropy)举例 l 举例:假设某字符发射器随机发出0和1两种字符。且其真实发出概率 分布为A。现在有两人的观察概率分布B与C。各个分布如下: A(0)=1/2,A(1)=1/2 B(0)=1/4,B(1)=3/4 C(0)=1/8,C(1)=7/8 则B和C哪个更接近实际分布A? 哈尔滨工业大学计算机学院 刘远超 7 l 求解过程: 用公式 �/0(�| � = ∑1∈2 � � ��� 3(1) 6(1) ,则 n �/0(�| � = ! " log !/" !/8 + ! " log( !/" 9/8 ) n �/0(�| � = ! " log !/" !/: + ! " log( !/" ;/: ) 结果: n �/0(�| � =0.14, n �/0(�| � = 0.41

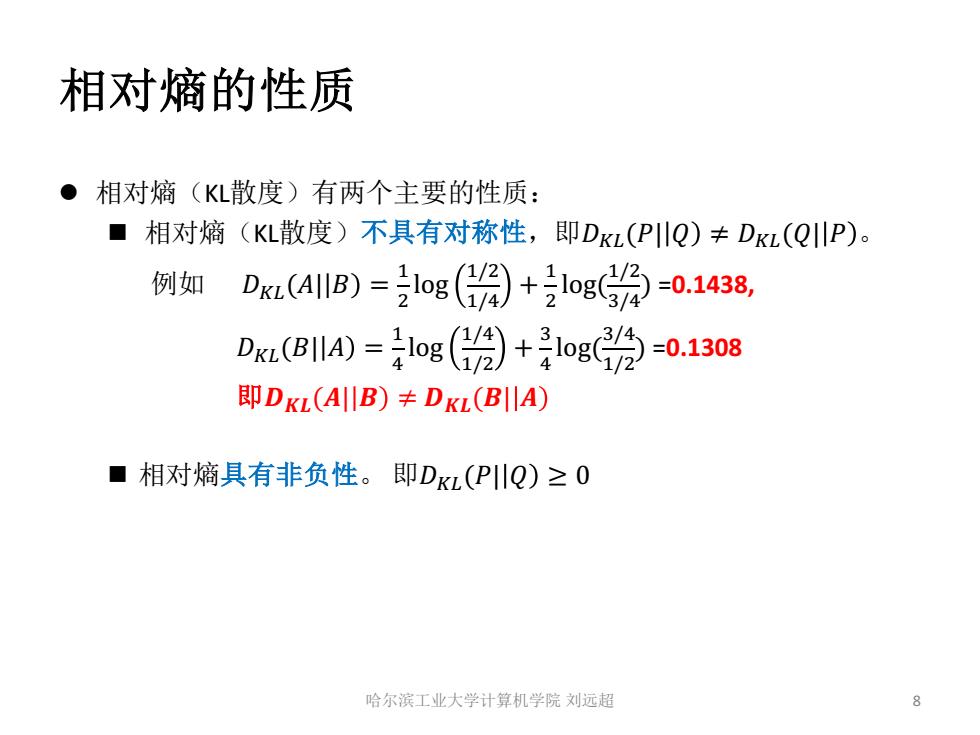

相对熵的性质 ●相对熵(KL散度)有两个主要的性质: ■相对熵(KL散度)不具有对称性,即DKL(PQ)≠Dk(QIIP)。 例如 Dku(4B)=1og(份)+1g(券=-0.1438, DxL.(BIIA)=log(+log(=0.1308 即DKL(AIB)≠DK(BIA) ■相对熵具有非负性。即DK(PIQ)≥0 哈尔滨工业大学计算机学院刘远超 8

相对熵的性质 l 相对熵(KL散度)有两个主要的性质: n 相对熵(KL散度)不具有对称性,即�/0(�| � ≠ �/0(�| � 。 例如 �/0(�| � = ! " log !/" !/8 + ! " log( !/" 9/8 ) =0.1438, �/0(�| � = ! 8 log !/8 !/" + 9 8 log( 9/8 !/" ) =0.1308 即���(�| � ≠ ���(�| � n 相对熵具有非负性。 即�/0(�| � ≥ 0 哈尔滨工业大学计算机学院 刘远超 8

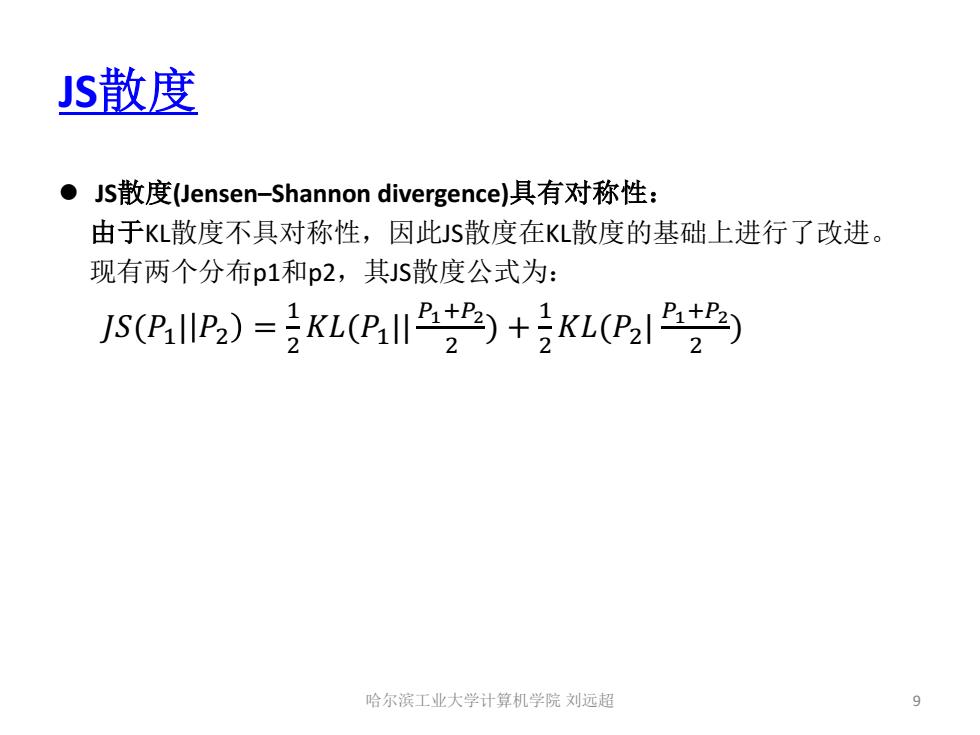

JS散度 ●JS散度Jensen--Shannon divergence)具有对称性: 由于KL散度不具对称性,因此S散度在KL散度的基础上进行了改进。 现有两个分布p1和p2,其S散度公式为: IS(PP2)=KL(P)+KL(P2) 哈尔滨工业大学计算机学院刘远超 9

JS散度 l JS散度(Jensen–Shannon divergence)具有对称性: 由于KL散度不具对称性,因此JS散度在KL散度的基础上进行了改进。 现有两个分布p1和p2,其JS散度公式为: ��(�!| �" = ! " ��(�!|| #!$#" " ) + ! " ��(�"| #!$#" " ) 哈尔滨工业大学计算机学院 刘远超 9