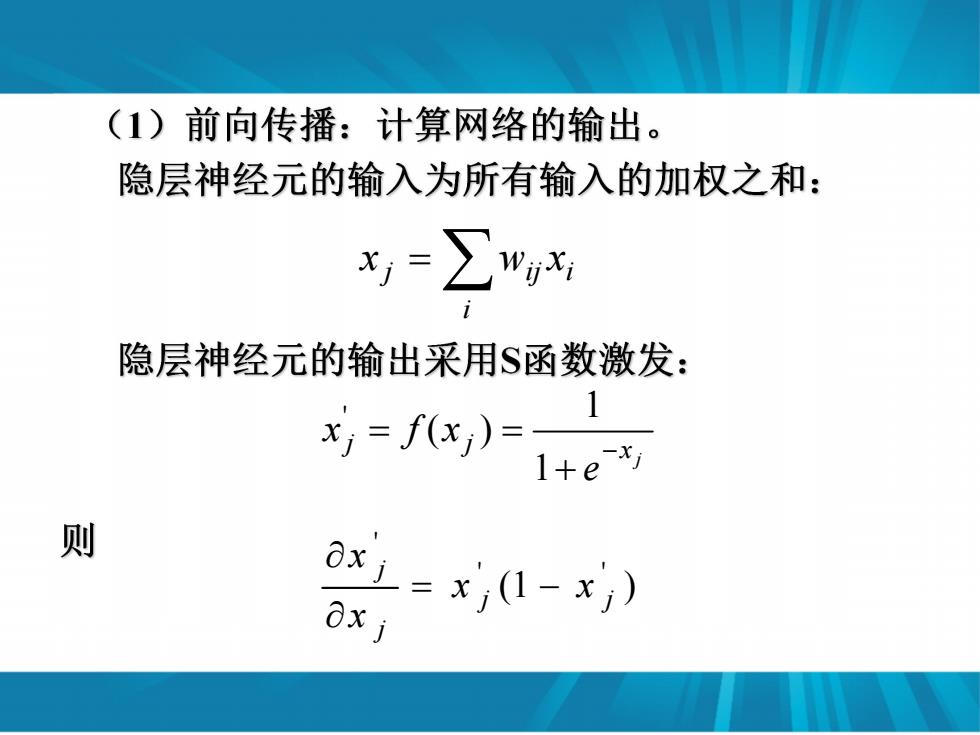

(1)前向传播:计算网络的输出。 隐层神经元的输入为所有输入的加权之和: =∑wx 隐层神经元的输出采用$函数激发: ,=fx,)= 则 x1=x1-x) O

i j ij i x w x j x j j e x f x 1 1 ( ) ' (1 ) ' ' ' j j j j x x x x

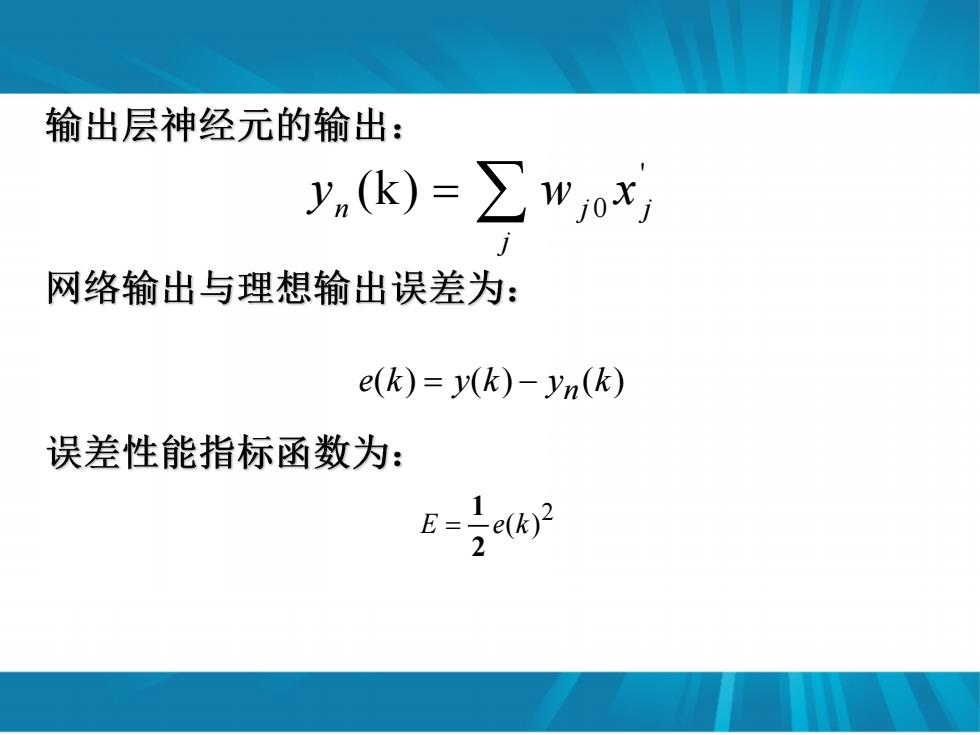

输出层神经元的输出: y,(k)=∑w0x 网络输出与理想输出误差为: e(k)=y(k)-yn(k) 误差性能指标函数为: E=I

' 0 (k) n j j j y w x e(k) y(k) y (k) n 2 E e(k) 2 1

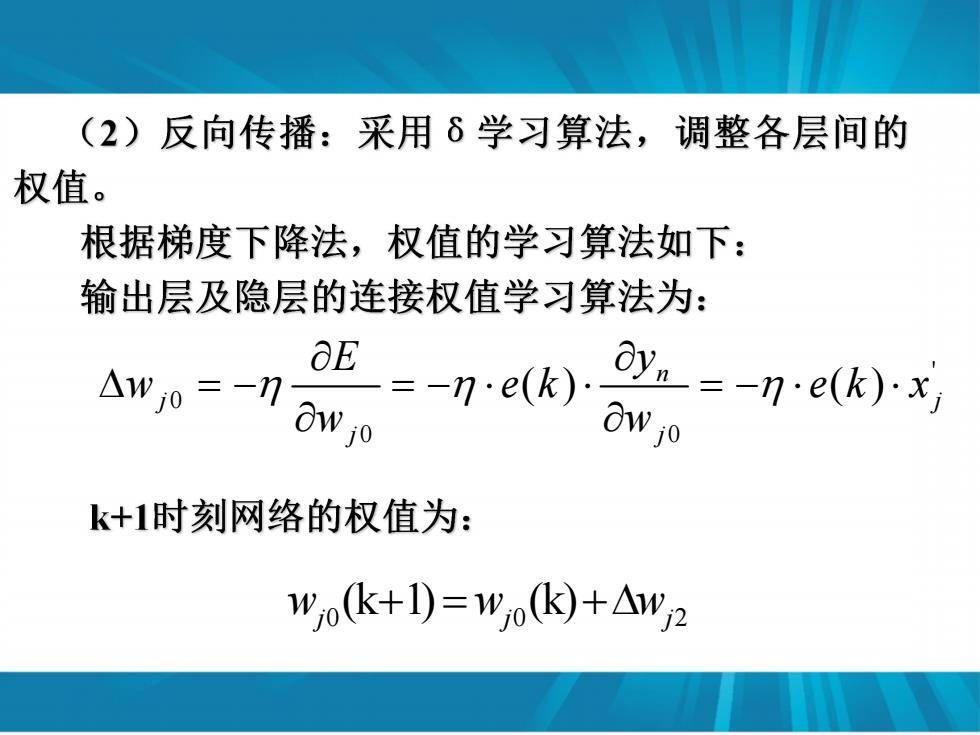

(2)反向传播:采用δ学习算法,调整各层间的 权值。 根据梯度下降法,权值的学习算法如下: 输出层及隐层的连接权值学习算法为: Aw0=-”aw, =-m-e(k)a,0 E Oy=-ne(k).x k+1时刻网络的权值为: wo(k+1)=W,o(k+△w2

' 0 0 0 ( ) ( ) n j j j j E y w e k e k x w w 0 0 2 (k 1) (k) wj wj wj

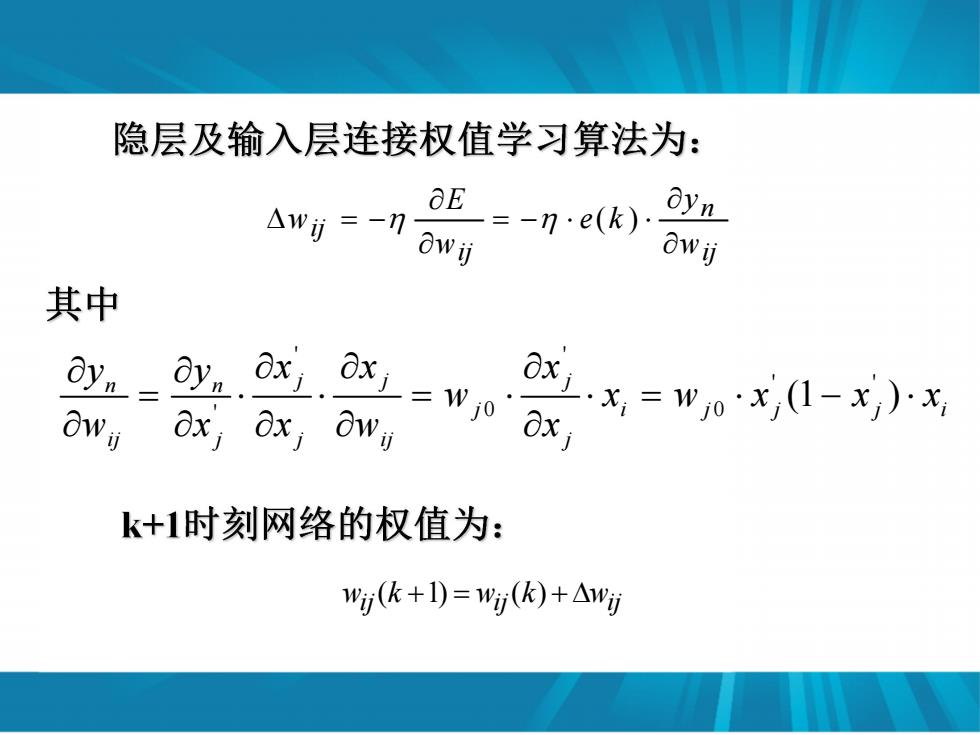

隐层及输入层连接权值学习算法为: Awj=-now可 =-ne(k) OE oyn 0w订 其中 Oy,= owij -wn ax 8x owy xx)x k+1时刻网络的权值为: w(k+1)=w()+△w防

ij n ij ij w y e k w E w ( ) ' ' ' ' ' 0 0 (1 ) n n j j j j i j j j i ij j j ij j y y x x x w x w x x x w x x w x ij ij wij w (k 1) w (k)

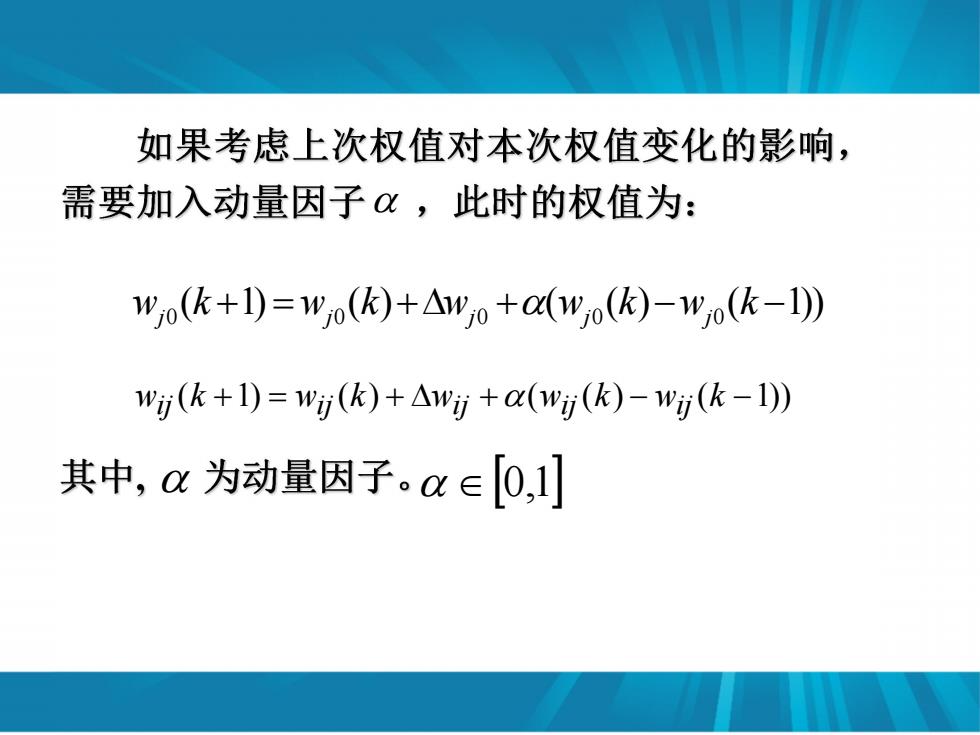

如果考虑上次权值对本次权值变化的影响, 需要加入动量因子,此时的权值为: w,ok+1)=wo(k)+△w0+(wo()-w(k-I)》 w(k+1)=w(k)+△w+a(w(k)-w(k-1)》 其中,a为动量因子。a∈[0,1]

0 0 0 0 0 ( 1) ( ) ( ( ) ( 1)) wj j j j j k w k w w k w k w (k 1) w (k) w (w (k) w (k 1)) ij ij ij ij ij 0,1