贝叶斯决策论 口具体来说,若目标是最小化分类错误率,则误判损失可写为 { if i=j otherwise, (7.4)

贝叶斯决策论 p 具体来说,若目标是最小化分类错误率,则误判损失 可写为

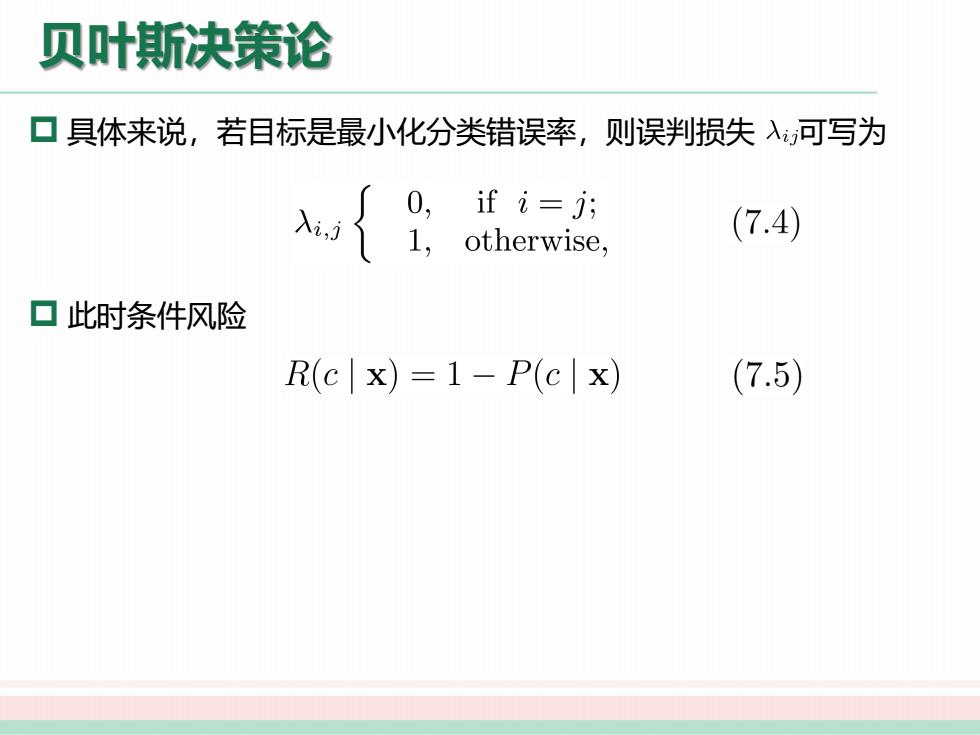

贝叶斯决策论 口具体来说,若目标是最小化分类错误率,则误判损失入可写为 0, if i=j; 1, otherwise, (7.4) ▣此时条件风险 R(c|x)=1-P(c|x) (7.5)

贝叶斯决策论 p 具体来说,若目标是最小化分类错误率,则误判损失 可写为 p 此时条件风险

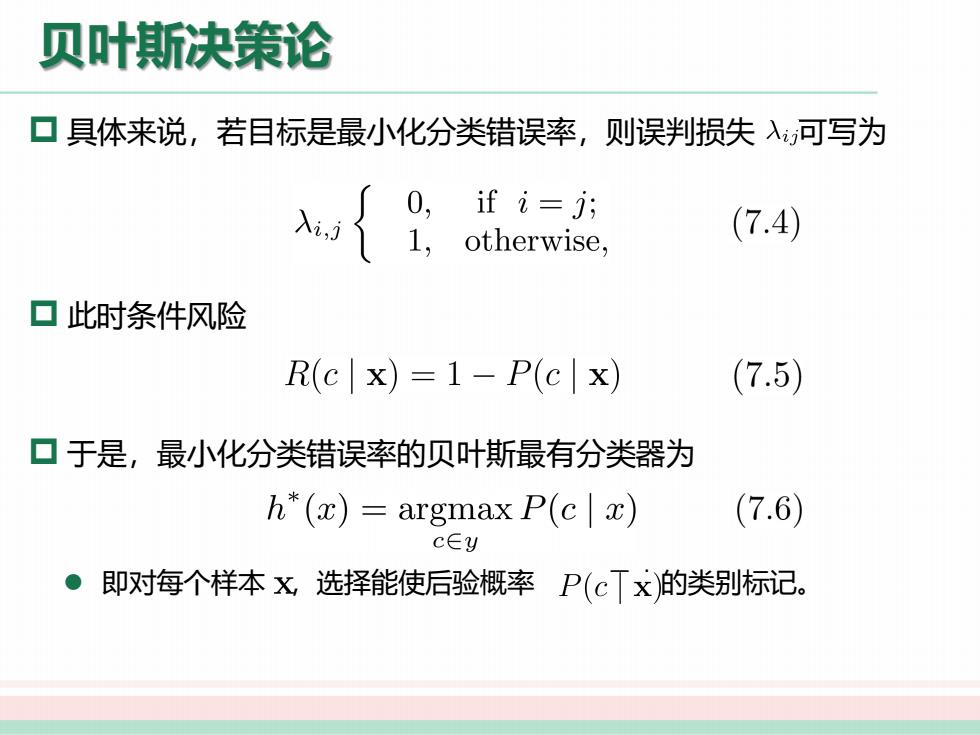

贝叶斯决策论 口具体来说,若目标是最小化分类错误率,则误判损失入可写为 { ifi=j对 otherwise, (7.4) ▣此时条件风险 R(c|x)=1-P(c|x) (7.5) 口于是,最小化分类错误率的贝叶斯最有分类器为 h*(x)=argmax P(c x) (7.6) c∈y ● 即对每个样本x选择能使后验概率P(cTx的类别标记

贝叶斯决策论 p 具体来说,若目标是最小化分类错误率,则误判损失 可写为 p 此时条件风险 p 于是,最小化分类错误率的贝叶斯最有分类器为 l 即对每个样本 ,选择能使后验概率 最大的类别标记

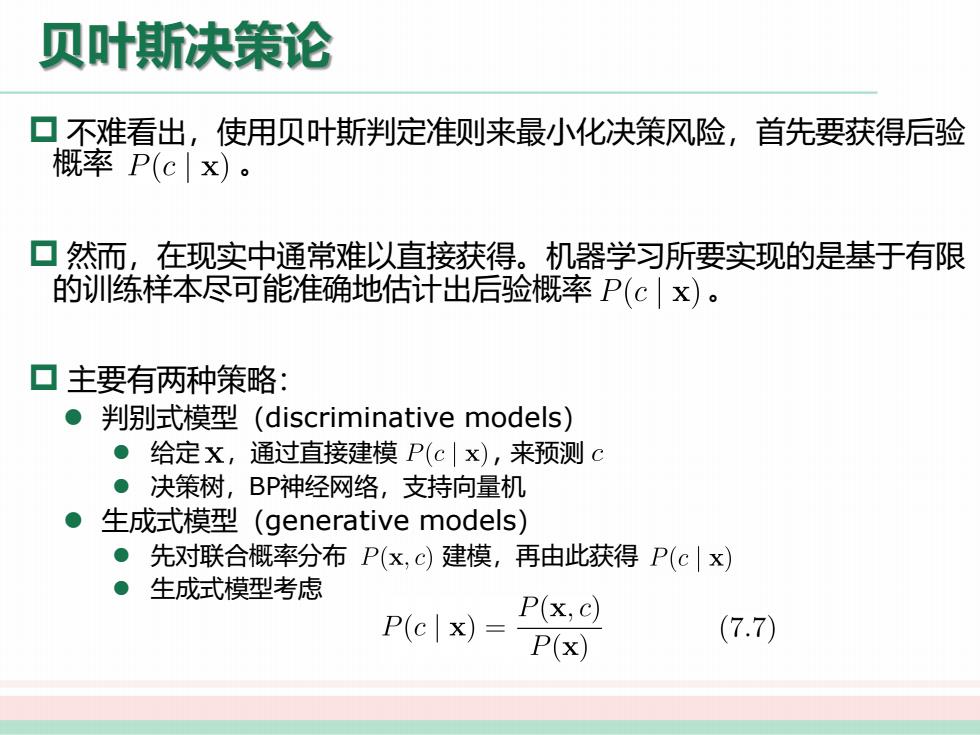

贝叶斯决策论 ▣不难看出,使用贝叶斯判定准则来最小化决策风险,首先要获得后验 概率P(cx)。 ▣然而,在现实中通常难以直接获得。机器学习所要实现的是基于有限 的训练样本尽可能准确地估计出后验概率P(c|x)。 口主要有两种策略: ●判别式模型(discriminative models) ●给定X,通过直接建模P(c|x),来预测c ●决策树,BP神经网络,支持向量机 生成式模型(generative models) ●先对联合概率分布P(x,c)建模,再由此获得P(cx) 生成式模型考虑 P(c x)= P(x,c) P(x) (7.7)

贝叶斯决策论 p 不难看出,使用贝叶斯判定准则来最小化决策风险,首先要获得后验 概率 。 p 然而,在现实中通常难以直接获得。机器学习所要实现的是基于有限 的训练样本尽可能准确地估计出后验概率 。 p 主要有两种策略: l 判别式模型(discriminative models) l 给定 ,通过直接建模 , 来预测 l 决策树,BP神经网络,支持向量机 l 生成式模型(generative models) l 先对联合概率分布 建模,再由此获得 l 生成式模型考虑

贝叶斯决策论 口生成式模型 P(c x)= P(x,c) (7.7) P(x)

贝叶斯决策论 p 生成式模型