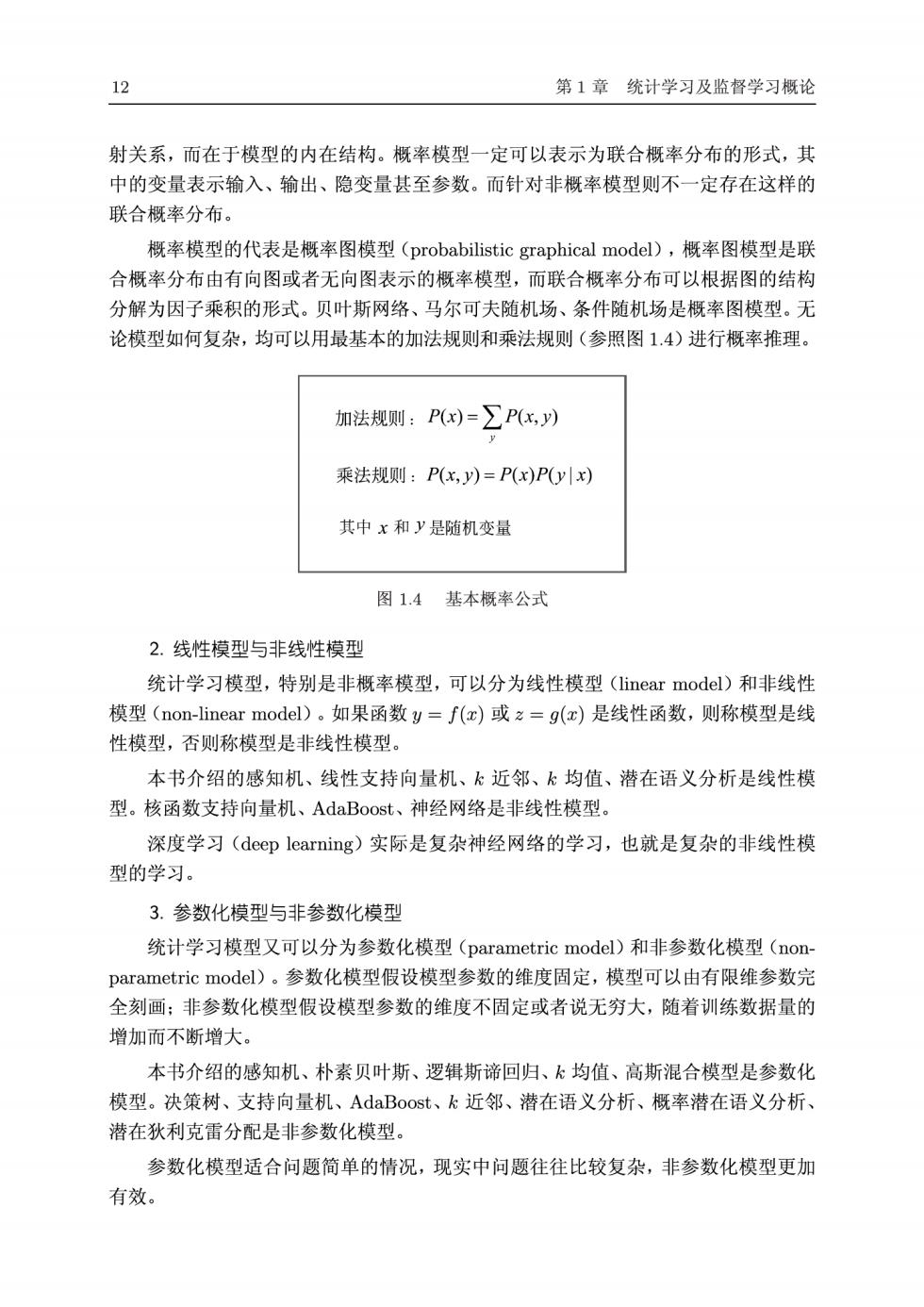

12 第1章统计学习及监督学习概论 射关系,而在于模型的内在结构。概率模型一定可以表示为联合概率分布的形式,其 中的变量表示输入、输出、隐变量甚至参数。而针对非概率模型则不一定存在这样的 联合概率分布。 概率模型的代表是概率图模型(probabilistic graphical model),概率图模型是联 合概率分布由有向图或者无向图表示的概率模型,而联合概率分布可以根据图的结构 分解为因子乘积的形式。贝叶斯网络、马尔可夫随机场、条件随机场是概率图模型。无 论模型如何复杂,均可以用最基本的加法规则和乘法规则(参照图1.4)进行概率推理。 加法规则:P)=∑Px,) 乘法规则:P(x,y)=P(x)Pyx) 其中x和y是随机变量 图1.4基本概率公式 2.线性模型与非线性模型 统计学习模型,特别是非概率模型,可以分为线性模型(linear model)和非线性 模型(non--linear model)。如果函数y=f(x)或z=g(x)是线性函数,则称模型是线 性模型,否则称模型是非线性模型。 本书介绍的感知机、线性支持向量机、k近邻、k均值、潜在语义分析是线性模 型。核函数支持向量机、AdaBoost、神经网络是非线性模型。 深度学习(deep learning)实际是复杂神经网络的学习,也就是复杂的非线性模 型的学习。 3.参数化模型与非参数化模型 统计学习模型又可以分为参数化模型(parametric model)和非参数化模型(non parametric model).。参数化模型假设模型参数的维度固定,模型可以由有限维参数完 全刻画:非参数化模型假设模型参数的维度不固定或者说无穷大,随着训练数据量的 增加而不断增大。 本书介绍的感知机、朴素贝叶斯、逻辑斯谛回归、k均值、高斯混合模型是参数化 模型。决策树、支持向量机、AdaBoost、k近邻、潜在语义分析、概率潜在语义分析、 潜在狄利克雷分配是非参数化模型。 参数化模型适合问题简单的情况,现实中问题往往比较复杂,非参数化模型更加 有效

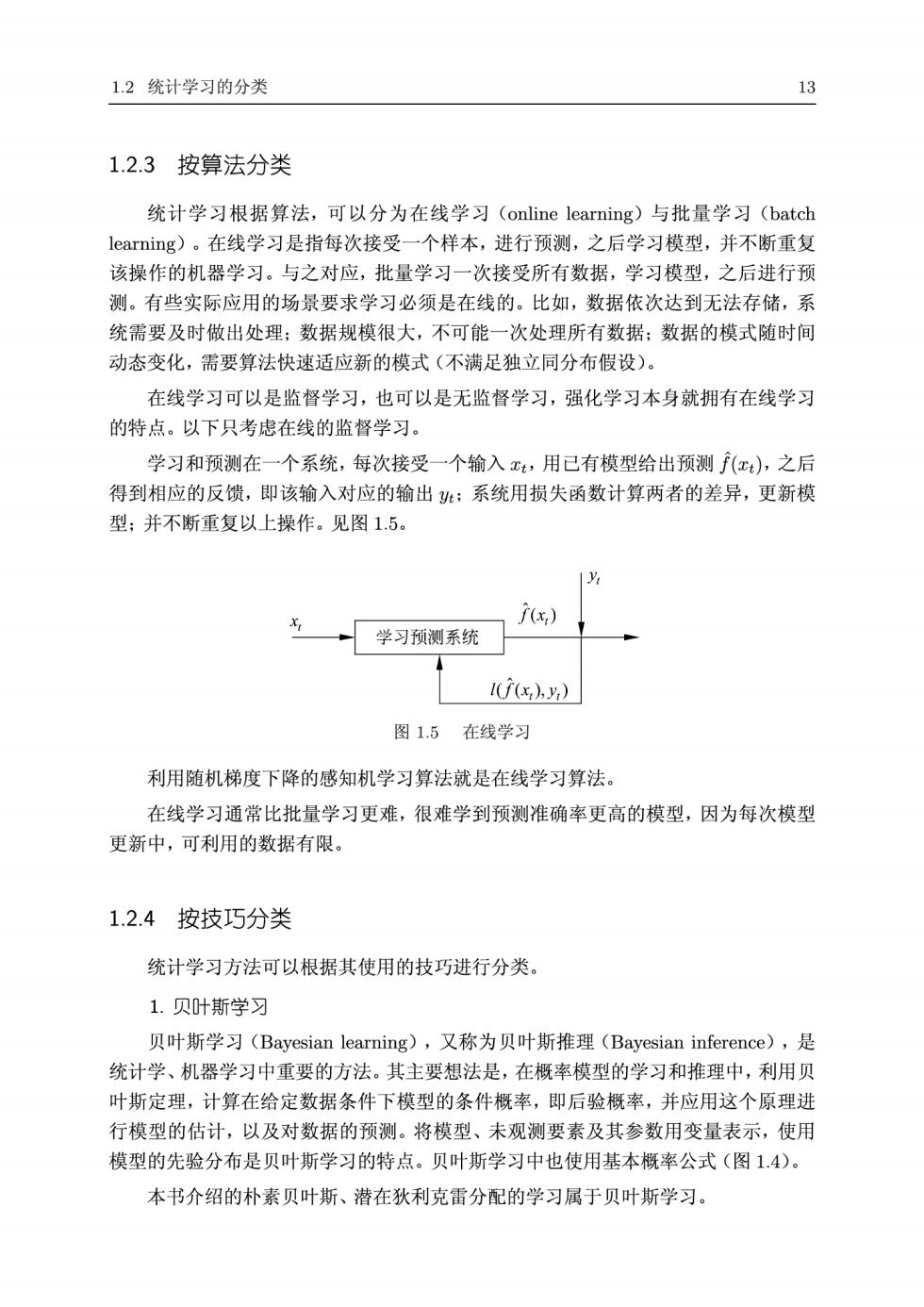

1.2统计学习的分类 13 1.2.3按算法分类 统计学习根据算法,可以分为在线学习(online learning)与批量学习(batch learning).。在线学习是指每次接受一个样本,进行预测,之后学习模型,并不断重复 该操作的机器学习。与之对应,批量学习一次接受所有数据,学习模型,之后进行预 测。有些实际应用的场景要求学习必须是在线的。比如,数据依次达到无法存储,系 统需要及时做出处理:数据规模很大,不可能一次处理所有数据:数据的模式随时间 动态变化,需要算法快速适应新的模式(不满足独立同分布假设) 在线学习可以是监督学习,也可以是无监督学习,强化学习本身就拥有在线学习 的特点。以下只考虑在线的监督学习。 学习和预测在一个系统,每次接受一个输入t,用已有模型给出预测(x),之后 得到相应的反馈,即该输入对应的输出:系统用损失函数计算两者的差异,更新模 型:并不断重复以上操作。见图1.5 f) 学习预测系统 1s) 图1.5在线学习 利用随机梯度下降的感知机学习算法就是在线学习算法。 在线学习通常比批量学习更难,很难学到预测准确率更高的模型,因为每次模型 更新中,可利用的数据有限。 1.2.4按技巧分类 统计学习方法可以根据其使用的技巧进行分类。 1.贝叶斯学习 贝叶斯学习(Bayesian learning),又称为贝叶斯推理(Bayesian inference),是 统计学、机器学习中重要的方法。其主要想法是,在概率模型的学习和推理中,利用贝 叶斯定理,计算在给定数据条件下模型的条件概率,即后验概率,并应用这个原理进 行模型的估计,以及对数据的预测。将模型、未观测要素及其参数用变量表示,使用 模型的先验分布是贝叶斯学习的特点。贝叶斯学习中也使用基本概率公式(图1.4)。 本书介绍的朴素贝叶斯、潜在狄利克雷分配的学习属于贝叶斯学习

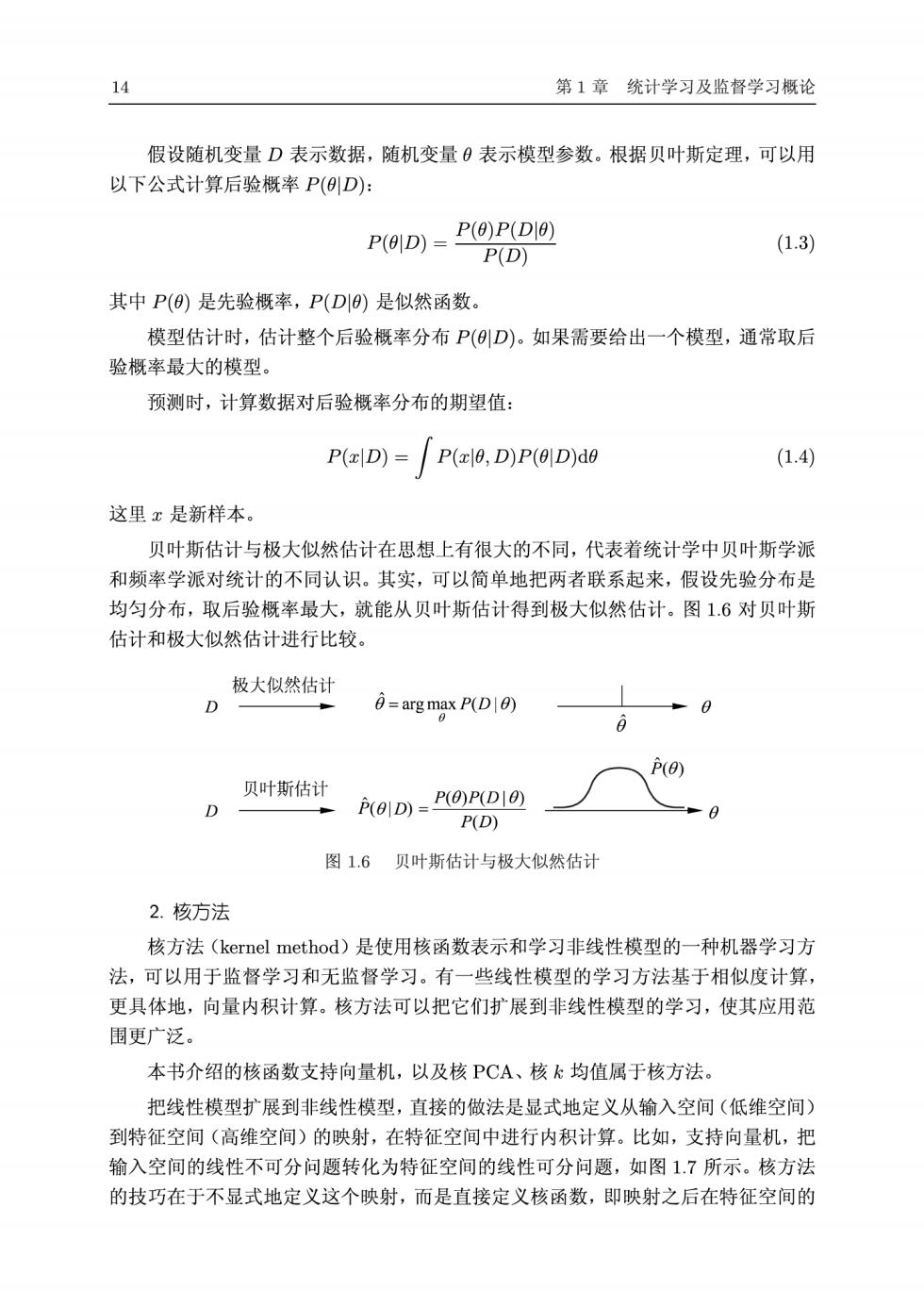

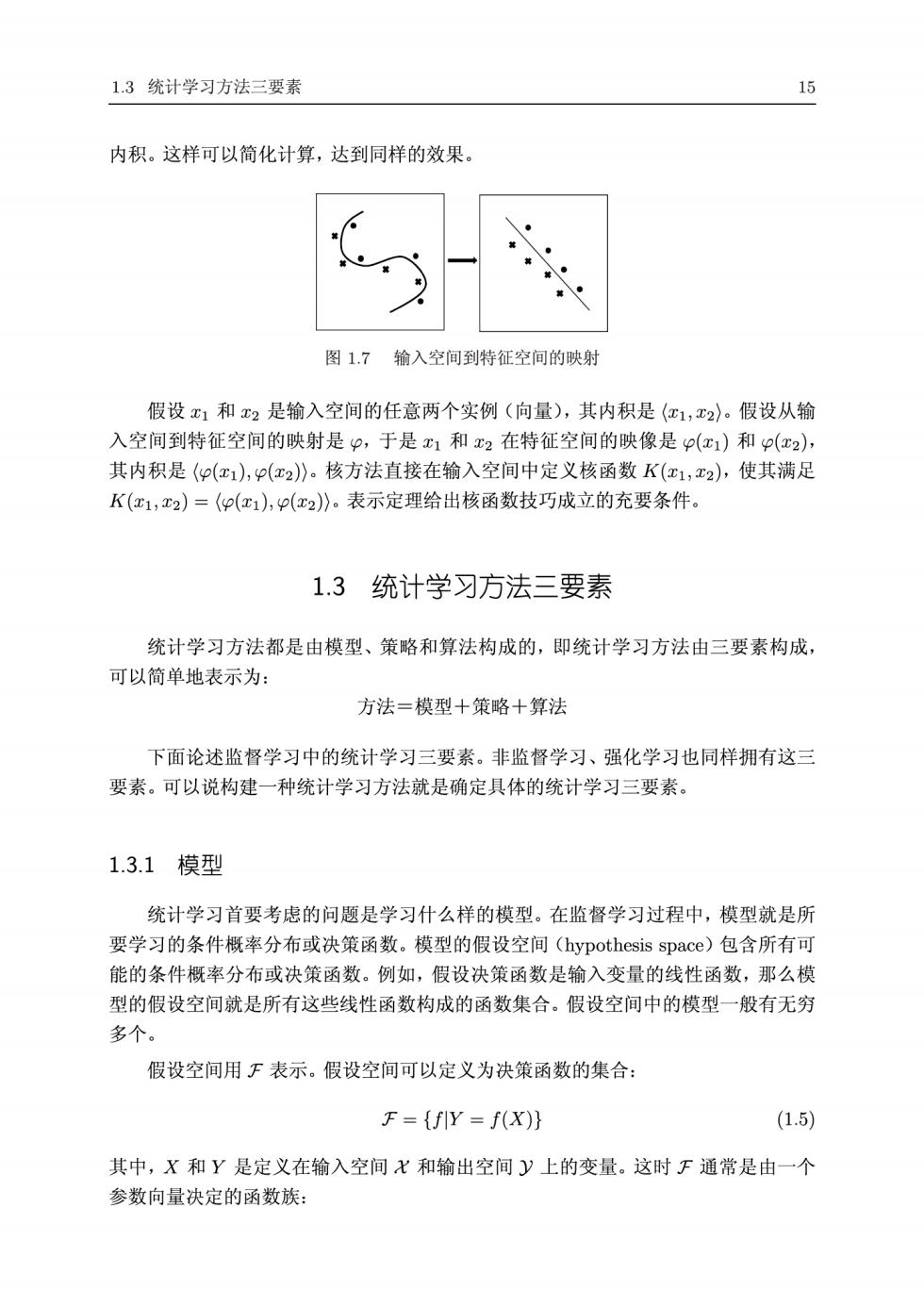

14 第1章统计学习及监督学习概论 假设随机变量D表示数据,随机变量0表示模型参数。根据贝叶斯定理,可以用 以下公式计算后验概率P(D): P(OD)P(0)P(DI0) (1.3) P(D) 其中P()是先验概率,P(D)是似然函数。 模型估计时,估计整个后验概率分布P(D)。如果需要给出一个模型,通常取后 验概率最大的模型。 预测时,计算数据对后验概率分布的期望值: P(D)=P(0,D)P(0D)d0 (1.4) 这里x是新样本。 贝叶斯估计与极大似然估计在思想上有很大的不同,代表着统计学中贝叶斯学派 和频率学派对统计的不同认识。其实,可以简单地把两者联系起来,假设先验分布是 均匀分布,取后验概率最大,就能从贝叶斯估计得到极大似然估计。图1.6对贝叶斯 估计和极大似然估计进行比较。 极大似然估计 D 6-arg max P(D0) 0 D贝叶斯估计 、P P(01D)=P(0)P(D10) P(D) 图1.6贝叶斯估计与极大似然估 2.核方法 核方法(kernel method).是使用核函数表示和学习非线性模型的一种机器学习方 法,可以用于监督学习和无监督学习。有一些线性模型的学习方法基于相似度计算, 更具体地,向量内积计算。核方法可以把它们扩展到非线性模型的学习,使其应用范 围更广泛。 本书介绍的核函数支持向量机,以及核PCA、核k均值属于核方法。 把线性模型扩展到非线性模型,直接的做法是显式地定义从输入空间(低维空间) 到特征空间(高维空间)的映射,在特征空间中进行内积计算。比如,支持向量机,把 输入空间的线性不可分问题转化为特征空间的线性可分问题,如图1.7所示。核方法 的技巧在于不显式地定义这个映射,而是直接定义核函数,即映射之后在特征空间的

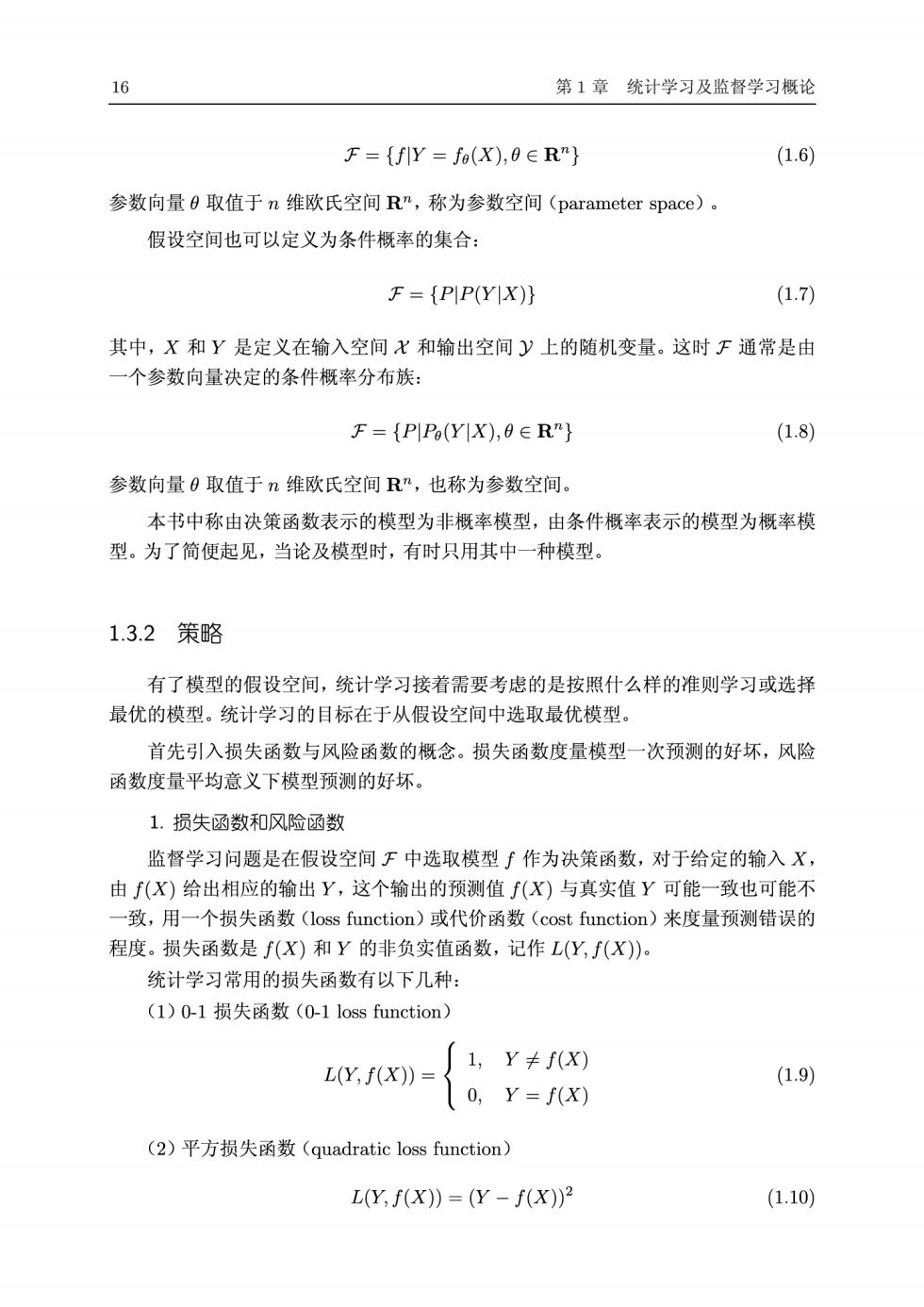

1.3统计学习方法三要素 15 内积。这样可以简化计算,达到同样的效果。 图1.7输入空间到特征空间的映射 假设x1和x2是输入空间的任意两个实例(向量),其内积是(c1,x2)。假设从输 入空间到特征空间的映射是P,于是1和x2在特征空间的映像是p(x1)和p(x2), 其内积是((),p(x2)》。核方法直接在输入空间中定义核函数K(c1,x2),使其满足 K(x1,x2)=〈p(红1),p(2)》。表示定理给出核函数技巧成立的充要条件。 1.3统计学习方法三要素 统计学习方法都是由模型、策略和算法构成的,即统计学习方法由三要素构成, 可以简单地表示为: 方法=模型十策略十算法 下面论述监督学习中的统计学习三要素。非监督学习、强化学习也同样拥有这三 要素。可以说构建一种统计学习方法就是确定具体的统计学习三要素。 1.3.1模型 统计学习首要考虑的问题是学习什么样的模型。在监督学习过程中,模型就是所 要学习的条件概率分布或决策函数。模型的假设空间(hypothesis space)包含所有可 能的条件概率分布或决策函数。例如,假设决策函数是输入变量的线性函数,那么模 型的假设空间就是所有这些线性函数构成的函数集合。假设空间中的模型一般有无穷 多个。 假设空间用F表示。假设空间可以定义为决策函数的集合: F={fY=f(x)) (1.5) 其中,X和Y是定义在输入空间X和输出空间y上的变量。这时下通常是由一个 参数向量决定的函数族:

16 第1章统计学习及监督学习概论 F={flY=fa(X),0∈R"} (1.6) 参数向量0取值于n维欧氏空间Rn,称为参数空间(parameter space)。 假设空间也可以定义为条件概率的集合: F=(PIP(Y X)} (1.7) 其中,X和Y是定义在输入空间X和输出空间y上的随机变量。这时F通常是由 一个参数向量决定的条件概率分布族: F={PIP(YIX),8∈Rn} (1.8) 参数向量0取值于n维欧氏空间R”,也称为参数空间。 本书中称由决策函数表示的模型为非概率模型,由条件概率表示的模型为概率模 型。为了简便起见,当论及模型时,有时只用其中一种模型。 1.3.2策略 有了模型的假设空间,统计学习接着需要考虑的是按照什么样的准则学习或选择 最优的模型。统计学习的目标在于从假设空间中选取最优模型。 首先引入损失函数与风险函数的概念。损失函数度量模型一次预测的好坏,风险 函数度量平均意义下模型预测的好坏。 1.损失函数和风险函数 监督学习问题是在假设空间下中选取模型∫作为决策函数,对于给定的输入X, 由(X)给出相应的输出Y,这个输出的预测值f(X)与真实值Y可能一致也可能不 一致,用一个损失函数(loss function)或代价函数(cost function)来度量预测错误的 程度。损失函数是f(X)和Y的非负实值函数,记作L(Y,f(X) 统计学习常用的损失函数有以下几种: (1)0-1损失函数(0-1 loss function) L(Y,f(X))= 了1,Y≠fX) (1.9) 0,Y=f(X) (2)平方损失函数(quadratic loss function) L(Y,f(x))=(Y-f(x))2 (1.10)