23滴现能力 开展的,例如预测下一个词元的平均交叉熵损失[15],这一度量本身是平滑的,是 对于模型整体能力的宏观度量。在实践中,我们则更关注大语言模型在真实任务 中的性能提升。为了建立扩展法则与模型任务性能的关联,一个基础问题就是语 言建模损失的减少是否真正意味着(或对应着)真实任务上模型性能的提高[21] 整体上来说,语言建模损失较小的模型往往在下游任务中表现更好,因为语言建 模的能力可以被认为是一种模型整体能力的综合度量。然而,语言建模损失的减 少并不总是意味着模型在下游任务上的性能改善。对于某些特殊任务,甚至会出 现“逆向扩展”(Inverse Scaling)现象,即随着语言建模损失的降低,任务性能却 出人意料地变差[3刀]。总体而言,探索和描述任务层面的扩展法则更加困难,因 为它可能还依赖于任务相关的信息(如任务指标、任务难度等)。根据GPT4的 报告35],通过扩展法则可以准确预测某些任务能力(例如编码能力),但是对 于有些任务的性能预测是非常困难的。此外,有些重要能力(例如上下文学习能 力23])根据扩展法则是不可预测的,只有当模型大小超过一定规模时才会出现, 如下文所讨论的涌现能力。 2.3涌现能力 在现有文献中[24],大语言模型的涌现能力被非形式化定义为“在小型模型 中不存在但在大模型中出现的能力”,具体是指当模型扩展到一定规模时,模型的 特定任务性能突然出现显著跃升的趋势,远超过随机水平。类比而言,这种性能浦 现模式与物理学中的相变现象有一定程度的相似,但是仍然缺乏相应的理论解释 以及理论证实,甚至有些研究工作对于诵现能力是否存在提出质疑[38]。整体来 说,涌现能力的提出有助于使得公众认识到大语言模型所具有的能力优势,能够 帮助区分大语言模型与传统预训练语言模型之间的差异。在本书中,涌现能力用 来指代大语言模型所具有的典型能力,并不关注该能力是否存在于小模型中。下 面,首先在第2.3.1节中介绍三种具有代表性的通现能力,随后在第2.3.2节中讨 论涌现能力的不同观点以及可能存在争议的原因。 2.3.1代表性的涌现能力 尽管涌现能力可以定义为解决某些复杂任务的能力水平,但我们更关注可以 用来解决各种任务的普适能力。下面简要介绍大语言模型的三种典型涌现能力。 22

2.3 涌现能力 开展的,例如预测下一个词元的平均交叉熵损失 [15],这一度量本身是平滑的,是 对于模型整体能力的宏观度量。在实践中,我们则更关注大语言模型在真实任务 中的性能提升。为了建立扩展法则与模型任务性能的关联,一个基础问题就是语 言建模损失的减少是否真正意味着(或对应着)真实任务上模型性能的提高 [21]。 整体上来说,语言建模损失较小的模型往往在下游任务中表现更好,因为语言建 模的能力可以被认为是一种模型整体能力的综合度量。然而,语言建模损失的减 少并不总是意味着模型在下游任务上的性能改善。对于某些特殊任务,甚至会出 现“逆向扩展”(Inverse Scaling)现象,即随着语言建模损失的降低,任务性能却 出人意料地变差 [37]。总体而言,探索和描述任务层面的扩展法则更加困难,因 为它可能还依赖于任务相关的信息(如任务指标、任务难度等)。根据 GPT-4 的 报告 [35],通过扩展法则可以准确预测某些任务能力(例如编码能力),但是对 于有些任务的性能预测是非常困难的。此外,有些重要能力(例如上下文学习能 力 [23])根据扩展法则是不可预测的,只有当模型大小超过一定规模时才会出现, 如下文所讨论的涌现能力。 2.3 涌现能力 在现有文献中 [24],大语言模型的涌现能力被非形式化定义为“在小型模型 中不存在但在大模型中出现的能力”,具体是指当模型扩展到一定规模时,模型的 特定任务性能突然出现显著跃升的趋势,远超过随机水平。类比而言,这种性能涌 现模式与物理学中的相变现象有一定程度的相似,但是仍然缺乏相应的理论解释 以及理论证实,甚至有些研究工作对于涌现能力是否存在提出质疑 [38]。整体来 说,涌现能力的提出有助于使得公众认识到大语言模型所具有的能力优势,能够 帮助区分大语言模型与传统预训练语言模型之间的差异。在本书中,涌现能力用 来指代大语言模型所具有的典型能力,并不关注该能力是否存在于小模型中。下 面,首先在第 2.3.1 节中介绍三种具有代表性的涌现能力,随后在第 2.3.2 节中讨 论涌现能力的不同观点以及可能存在争议的原因。 2.3.1 代表性的涌现能力 尽管涌现能力可以定义为解决某些复杂任务的能力水平,但我们更关注可以 用来解决各种任务的普适能力。下面简要介绍大语言模型的三种典型涌现能力。 22

2.3涌现能力 ·上下文学习(In-context Learning,ICL).上下文学习能力在GPT-3的论文 中[23)]被正式提出。具体方式为,在提示中为语言模型提供自然语言指令和多个 任务示例(Demonstration),无需显式的训练或梯度更新,仅输入文本的单词序列 就能为测试样本生成预期的输出。在GPT系列模型中,175B参数的GPT-3模型展 现出强大的上下文学习能力,而GPT-1和GPT-2模型则不具备这种能力。此外,上 下文学习能力还取决于具体的下游任务。例如,13B参数的GPT-3模型可以在算 术任务(例如3位数的加减法)上展现出上下文学习能力,但175B参数的GPT-3 模型在波斯语问答任务上甚至不能表现出良好的性能[24] ·指令遵循(Instruction Following).指令遵循能力是指大语言模型能够按照 自然语言指令来执行对应的任务[28,39,40]。为了获得这一能力,通常需要使用自 然语言描述的多任务示例数据集进行微调,称为指令微调(InstructionTuning)或 监督微调(Supervised Fine--tuning)。通过指令微调,大语言模型可以在没有使用 显式示例的情况下按照任务指令完成新任务,有效提升了模型的泛化能力。相比 于上下文学习能力,指令遵循能力整体上更容易获得,但是最终的任务执行效果 还取决于模型性能和任务难度决定。例如,FLAN-PaLM模型[41]测试了8B、62B 以及540B三个参数规模的模型在指令微调之后的效果,当参数规模达到62B及 以上的情况,才能够在包含23个复杂推理任务的BBH评估基准上,展现出较好 的零样本推理能力。对于规模相对较小的语言模型(如2B),也可以通过使用高 质量指令数据微调的方式习得一定的通用指令遵循能力(主要是简单任务,如文 本摘要等)[42]。 ·逐步推理(Stcp-by-step Reasoning).对于小型语言模型而言,通常很难解决 涉及多个推理步骤的复杂任务(如数学应用题),而大语言模型则可以利用思维链 (Chain-of-Thought,.CoT)提示策略[25来加强推理性能。具体来说,大语言模型 可以在提示中引入任务相关的中间推理步骤来加强复杂任务的求解,从而获得更 为可靠的答案。在思维链的原始论文中发现[25],对于62B和540B参数的PLM 模型,思维链提示可以提高其在算术推理基准上的效果,但是8B参数的模型则很 难获得提升。进一步,思维链所带来的提升在54OB参数的PaLM模型上会更加明 细。此外,思维链提示对不同任务的性能提升也不完全相同,例如PLM模型在 三个数据集合上产生了不同的提升幅度(GSM8K>MAWPS>SWAMP)[25]。思 维链提示特别适合帮助大语言模型解决复杂数学问题,而具有思维链能力也是大 语言模型能力的重要体现

2.3 涌现能力 • 上下文学习(In-context Learning, ICL). 上下文学习能力在 GPT-3 的论文 中 [23] 被正式提出。具体方式为,在提示中为语言模型提供自然语言指令和多个 任务示例(Demonstration),无需显式的训练或梯度更新,仅输入文本的单词序列 就能为测试样本生成预期的输出。在 GPT 系列模型中,175B 参数的 GPT-3 模型展 现出强大的上下文学习能力,而 GPT-1 和 GPT-2 模型则不具备这种能力。此外,上 下文学习能力还取决于具体的下游任务。例如,13B 参数的 GPT-3 模型可以在算 术任务(例如 3 位数的加减法)上展现出上下文学习能力,但 175B 参数的 GPT-3 模型在波斯语问答任务上甚至不能表现出良好的性能 [24]。 • 指令遵循(Instruction Following). 指令遵循能力是指大语言模型能够按照 自然语言指令来执行对应的任务 [28, 39, 40]。为了获得这一能力,通常需要使用自 然语言描述的多任务示例数据集进行微调,称为指令微调(Instruction Tuning)或 监督微调(Supervised Fine-tuning)。通过指令微调,大语言模型可以在没有使用 显式示例的情况下按照任务指令完成新任务,有效提升了模型的泛化能力。相比 于上下文学习能力,指令遵循能力整体上更容易获得,但是最终的任务执行效果 还取决于模型性能和任务难度决定。例如,FLAN-PaLM 模型 [41] 测试了 8B、62B 以及 540B 三个参数规模的模型在指令微调之后的效果,当参数规模达到 62B 及 以上的情况,才能够在包含 23 个复杂推理任务的 BBH 评估基准上,展现出较好 的零样本推理能力。对于规模相对较小的语言模型(如 2B),也可以通过使用高 质量指令数据微调的方式习得一定的通用指令遵循能力(主要是简单任务,如文 本摘要等)[42]。 • 逐步推理(Step-by-step Reasoning). 对于小型语言模型而言,通常很难解决 涉及多个推理步骤的复杂任务(如数学应用题),而大语言模型则可以利用思维链 (Chain-of-Thought, CoT)提示策略 [25] 来加强推理性能。具体来说,大语言模型 可以在提示中引入任务相关的中间推理步骤来加强复杂任务的求解,从而获得更 为可靠的答案。在思维链的原始论文中发现 [25],对于 62B 和 540B 参数的 PaLM 模型,思维链提示可以提高其在算术推理基准上的效果,但是 8B 参数的模型则很 难获得提升。进一步,思维链所带来的提升在 540B 参数的 PaLM 模型上会更加明 细。此外,思维链提示对不同任务的性能提升也不完全相同,例如 PaLM 模型在 三个数据集合上产生了不同的提升幅度(GSM8K > MAWPS > SWAMP)[25]。思 维链提示特别适合帮助大语言模型解决复杂数学问题,而具有思维链能力也是大 语言模型能力的重要体现。 23

23滴现能力 通常来说,很难统一界定大语言模型出现这些上述能力的临界规模(即具备 某种能力的最小规模),因为能力涌现会受到多种因素或者任务设置的影响。最 近的研究表明,经过了高质量的预训练与指令微调后,即使较小的语言模型(如 LLaMA-2(TB))也能够一定程度上展现出上述提到的三种能力,并且对于参数规 模的要求随着预训练数据规模的扩展以及数据质量的提升在不断下降。此外,现 有的研究对于能力涌现的实验往往局限于少数几个模型规模。例如,PLM模型的 相关公开研究只在8B、62B和540B三种模型规模上进行了测试,对于未测试过 的模型规模的性能尚不清楚。 2.3.2涌现能力与扩展法则的关系 扩展法则和涌现能力提供了两种不同观点来理解大模型相对于小模型的优势 但是刻画了较为不同的扩展效应趋势。扩展法则使用语言建模损失来衡量语言模 型的整体性能,整体上展现出了较为平滑的性能提升趋势,具有较好的可预测性 但是指数形式暗示着可能存在的边际效益递减现象;而涌现能力通常使用任务性 能来衡量模型性能,整体上展现出随规模扩展的骤然跃升趋势,不具有可预测性, 但是一旦出现涌现能力则意味着模型性能将会产生大幅跃升。由于这两种观点反 映了不同的模型性能提升趋势(持续改进3.性能跃升),可能在一些情况下会导 致不一致的发现与结论。 关于涌现能力的合理性也存在广泛的争议。一种推测是,涌现能力可能部分 归因于特殊任务的设置43,44:现有评测设置中通常采用不连续的评估指标(如 生成代码的准确性使用测试数据通过率评估)以及较为有限的模型参数规模(如 PaLM技术报告里只展示了8B、62B和540B三个版本的模型)。在上述这两种情 况下,很容易在下游任务的评测效果上产生不连续的变化趋势,导致了所谓的模 型能力的“涌现现象”。特别地,如果针对性地修改评估指标时,或者提供更为连 续的模型尺寸候选使之变得更为平滑后,涌现能力曲线的突然跃升趋势有可能会 消失。这种分析一定程度上解释了模型性能的陡然跃升现象,为涌现能力的存在 性打上了问号。然而,在实际使用中,用户就是以一种“不连续”的方式去感知大 语言模型的性能优劣。换句话说,模型输出的正确性更为重要,用户满意度的体 验过程本身就是离散的。例如,用户更倾向于使用能够正确通过所有测试用例的 代码,而不愿意在两个失败代码之间选择一个包含错误较少的代码。 目前还缺少对于大语言模型涌现机理的基础性解释研究工作。与这一问题较

2.3 涌现能力 通常来说,很难统一界定大语言模型出现这些上述能力的临界规模(即具备 某种能力的最小规模),因为能力涌现会受到多种因素或者任务设置的影响。最 近的研究表明,经过了高质量的预训练与指令微调后,即使较小的语言模型(如 LLaMA-2 (7B))也能够一定程度上展现出上述提到的三种能力,并且对于参数规 模的要求随着预训练数据规模的扩展以及数据质量的提升在不断下降。此外,现 有的研究对于能力涌现的实验往往局限于少数几个模型规模。例如,PaLM 模型的 相关公开研究只在 8B、62B 和 540B 三种模型规模上进行了测试,对于未测试过 的模型规模的性能尚不清楚。 2.3.2 涌现能力与扩展法则的关系 扩展法则和涌现能力提供了两种不同观点来理解大模型相对于小模型的优势, 但是刻画了较为不同的扩展效应趋势。扩展法则使用语言建模损失来衡量语言模 型的整体性能,整体上展现出了较为平滑的性能提升趋势,具有较好的可预测性, 但是指数形式暗示着可能存在的边际效益递减现象;而涌现能力通常使用任务性 能来衡量模型性能,整体上展现出随规模扩展的骤然跃升趋势,不具有可预测性, 但是一旦出现涌现能力则意味着模型性能将会产生大幅跃升。由于这两种观点反 映了不同的模型性能提升趋势(持续改进 v.s. 性能跃升),可能在一些情况下会导 致不一致的发现与结论。 关于涌现能力的合理性也存在广泛的争议。一种推测是,涌现能力可能部分 归因于特殊任务的设置 [43, 44]:现有评测设置中通常采用不连续的评估指标(如 生成代码的准确性使用测试数据通过率评估)以及较为有限的模型参数规模(如 PaLM 技术报告里只展示了 8B、62B 和 540B 三个版本的模型)。在上述这两种情 况下,很容易在下游任务的评测效果上产生不连续的变化趋势,导致了所谓的模 型能力的“涌现现象”。特别地,如果针对性地修改评估指标时,或者提供更为连 续的模型尺寸候选使之变得更为平滑后,涌现能力曲线的突然跃升趋势有可能会 消失。这种分析一定程度上解释了模型性能的陡然跃升现象,为涌现能力的存在 性打上了问号。然而,在实际使用中,用户就是以一种“不连续”的方式去感知大 语言模型的性能优劣。换句话说,模型输出的正确性更为重要,用户满意度的体 验过程本身就是离散的。例如,用户更倾向于使用能够正确通过所有测试用例的 代码,而不愿意在两个失败代码之间选择一个包含错误较少的代码。 目前还缺少对于大语言模型涌现机理的基础性解释研究工作。与这一问题较 24

2.4GPT系列模型的技术演变 可公开被取 201 AC G I HyperCLOVA NAVER PaL.M2 T-NLG Bard X NLLB ua 00 WH 023- 224一 图2.1大语言模型发展时间线(图片来源:[10) 为相关的研究叫做“顿悟”(Grokking),是指训练过程中的一种数据学习模式:模 型性能从随机水平提升为高度泛化[45]。在未来研究中,还需要更为深入的相关 讨论,才能够有效解释大模型的涌现机理。通俗来讲,扩展法则与涌现能力之间微 妙的关系可以类比人类的学习能力来解释。以语言能力为例,对于儿童来说,语 言发展(尤其是婴儿)可以被看作一个多阶段的发展过程,其中也会出现“涌现现 象”。在这一发展过程中,语言能力在一个阶段内部相对稳定,但是当进入另一个 能力阶段时可能会出现重要的提升(例如从说简单的单词到说简单的句子)。尽管 儿童实际上每天都在成长,但是语言的提升过程本质上是不平滑和不稳定的(即 语言能力在时间上不以恒定速率发展)。因此,经常可以看到年轻的父母会对宝宝 所展现出的语言能力进展感到惊讶。 ⑤OpenAI CP ○ gpl-3.S.tarbo 与人叶本 图2.2GPT系列模型技术发展的历程图(图片来源:[10)

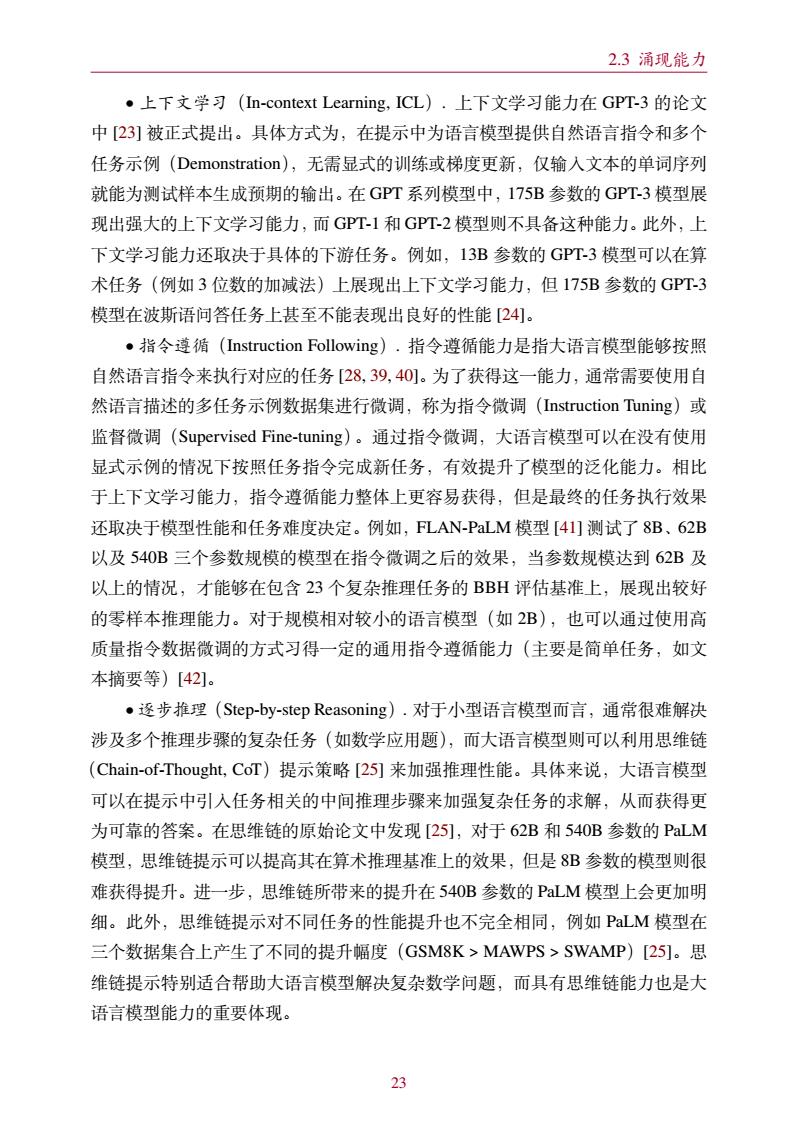

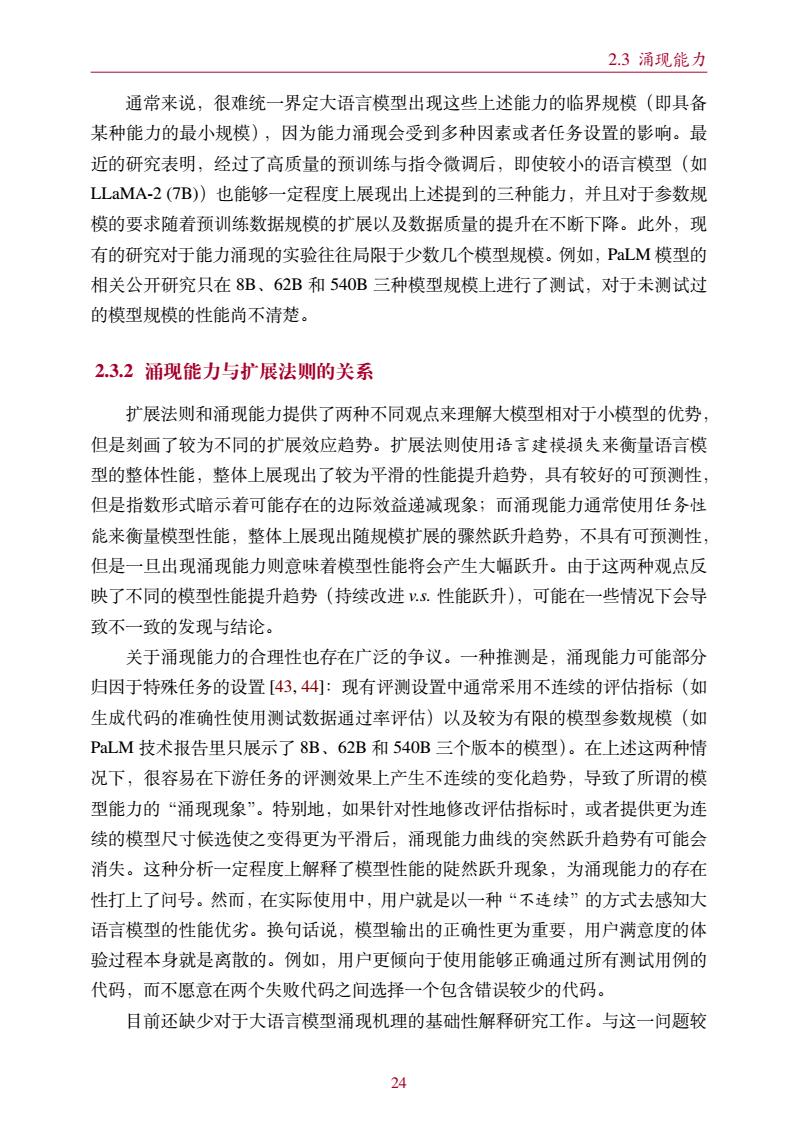

2.4 GPT 系列模型的技术演变 2020 2023 2021 1-4 5-8 9-10 1-3 4-6 7-10 11-12 T5 GPT-3 WebGPT BLOOMZ Galatica mT0 2019 FLAN InstructGPT GPT-NeoX-20B CodeGen OPT OPT-IML MT-NLG T0 Tk-Instruct 1-6 GPT-4 GShard UL2 PaLM Flan-T5 Flan-PaLM Sparrow ChatGPT Ernie 3.0 Titan Yuan 1.0 Gopher GLaM mT5 PanGu-𝛂 PLUG LaMDA CPM-2 HyperCLOVA 可公开获取 Codex Jurassic-1 Ernie 3.0 Anthropic NLLB Cohere Luminous YaLM 11-12 2022 GLM AlexaTM BLOOM WeLM AlphaCode Chinchilla CodeGeeX 7-12 LLaMA2 LLaMA PanGu-Σ Bard Pythia Vicuna InternLM 2024 2019 Qwen Mistral Deepseek Mixtral MiniCPM Gemma Falcon CodeGen2 StarCoder PaLM2 ChatGLM YuLan-Chat 1-3 图 2.1 大语言模型发展时间线(图片来源: [10]) 为相关的研究叫做“顿悟”(Grokking),是指训练过程中的一种数据学习模式:模 型性能从随机水平提升为高度泛化 [45]。在未来研究中,还需要更为深入的相关 讨论,才能够有效解释大模型的涌现机理。通俗来讲,扩展法则与涌现能力之间微 妙的关系可以类比人类的学习能力来解释。以语言能力为例,对于儿童来说,语 言发展(尤其是婴儿)可以被看作一个多阶段的发展过程,其中也会出现“涌现现 象”。在这一发展过程中,语言能力在一个阶段内部相对稳定,但是当进入另一个 能力阶段时可能会出现重要的提升(例如从说简单的单词到说简单的句子)。尽管 儿童实际上每天都在成长,但是语言的提升过程本质上是不平滑和不稳定的(即 语言能力在时间上不以恒定速率发展)。因此,经常可以看到年轻的父母会对宝宝 所展现出的语言能力进展感到惊讶。 GPT-1 2018.06 仅解码器架构 生成式预训练 GPT-2 2019.02 无监督多任务学习器 模型参数规模扩大 上下文学习 探索参数规模上限 在代码数据 上预训练 gpt-3.5-turbo 2023.03 出色的综合能力 text-davinci-002 2022.03 指令遵循 code-davinci-002 2022.03 强大的代码模型 +代码 +指令 +RLHF +对话 Codex 2021.07 GPT-3 2020.05 GPT-4 2023.03 GPT-3.5 2022.03 text-davinci-003 2022.09 与人类对齐 GPT-4 Turbo 2023.09 更长的上下文 GPT-4 Turbo with vision 2023.09 多模态能力 ChatGPT 强大的推理能力 图 2.2 GPT 系列模型技术发展的历程图(图片来源:[10]) 25

2.4GPT系列模型的技术演变 2.4GPT系列模型的技术演变 2022年1l月底,OpenAI推出了基于大语言模型的在线对话应用一ChatGPT。 由于具备出色的人机对话能力和任务解决能力,ChatGPT一经发布就引发了全社 会对于大语言模型的广泛关注,众多的大语言模型应运而生,并且数量还在不断 增加(图2.1)。由于GPT系列模型具有重要的代表性,本部分内容将针对GPT系 列模型的发展历程进行介绍,并且凝练出其中的重要技术创新。 GPT系列模型的基本原理是训练模型学习恢复预训练文本数据,将广泛的世 界知识压缩到仅包含解码器(Decoder--Only)的Transformer模型中,从而使模型 能够学习获得较为全面的能力。其中,两个关键要素是:()训练能够准确预测下 一个词的Transformer(只包含解码器)语言模型;(I)扩展语言模型的规模以及 扩展预训练数据的规模。图2.2展示了GT系列模型的技术演进示意图,这里主 要根据OpenAI的论文、博客文章和官方API说明的信息进行绘制。该图中实线 表示在两个模型之间的进化路径上存在明确的证据(例如,官方声明新模型是基 于基础模型开发的),而虚线表示相对较弱的进化关系。截止到目前,OpenAI对 大语言模型的研发历程大致可分为四个阶段:早期探索阶段、路线确立阶段、能 力增强阶段以及能力跃升阶段,下面进行具体介绍。 2.4.1早期探索 根据对于lya Sutskever(OpenAI联合创始人、前首席科学家)的采访,OpenAI 在成立初期就尝试使用语言模型研发人工智能系统,但当时使用的是循环神经网 络46],模型能力和并行训练能力还存在较大的局限性。Transformer刚刚问世,就 引起了OpenAI团队的高度关注,并且将语言模型的研发工作切换到Transformer 架构上,相继推出了两个初始的GPT模型,即GPT-1[14)和GPT-2[17],这两个 早期工作奠定了后续更强大的GPT模型(如GPT-3和GPT4)的研究基础。 ·GPTl.2O17年,Google推出Transformer模型后,OpenAI团队马上意识 到这种神经网络架构将显著优于传统序列神经网络的性能,有可能对于研发大型 神经网络产生重要的影响。他们很快着手使用Transformer架构研发语言模型,并 于2018年发布了第一个GPT模型,即GPT-l,模型名称GPT是生成式预训练 流容是作者基于O发布的论文。客文道A说明 3https://hackernoon.com/an-interview-with-ilya-sutskever-co-founder-of-openai 26

2.4 GPT 系列模型的技术演变 2.4 GPT 系列模型的技术演变 2022 年 11 月底,OpenAI 推出了基于大语言模型的在线对话应用 — ChatGPT。 由于具备出色的人机对话能力和任务解决能力,ChatGPT 一经发布就引发了全社 会对于大语言模型的广泛关注,众多的大语言模型应运而生,并且数量还在不断 增加(图 2.1)。由于 GPT 系列模型具有重要的代表性,本部分内容将针对 GPT 系 列模型的发展历程进行介绍,并且凝练出其中的重要技术创新。 GPT 系列模型的基本原理是训练模型学习恢复预训练文本数据,将广泛的世 界知识压缩到仅包含解码器(Decoder-Only)的 Transformer 模型中,从而使模型 能够学习获得较为全面的能力。其中,两个关键要素是:(I)训练能够准确预测下 一个词的 Transformer (只包含解码器)语言模型;(II)扩展语言模型的规模以及 扩展预训练数据的规模。图 2.2 展示了 GPT 系列模型的技术演进示意图,这里主 要根据 OpenAI 的论文、博客文章和官方 API 说明的信息进行绘制。该图中 实线 表示在两个模型之间的进化路径上存在明确的证据(例如,官方声明新模型是基 于基础模型开发的),而 虚线 表示相对较弱的进化关系。截止到目前,OpenAI 对 大语言模型的研发历程大致可分为四个阶段:早期探索阶段、路线确立阶段、能 力增强阶段以及能力跃升阶段,下面进行具体介绍2。 2.4.1 早期探索 根据对于 Ilya Sutskever(OpenAI 联合创始人、前首席科学家)的采访3,OpenAI 在成立初期就尝试使用语言模型研发人工智能系统,但当时使用的是循环神经网 络 [46],模型能力和并行训练能力还存在较大的局限性。Transformer 刚刚问世,就 引起了 OpenAI 团队的高度关注,并且将语言模型的研发工作切换到 Transformer 架构上,相继推出了两个初始的 GPT 模型,即 GPT-1 [14] 和 GPT-2 [17],这两个 早期工作奠定了后续更强大的 GPT 模型(如 GPT-3 和 GPT-4)的研究基础。 • GPT-1. 2017 年,Google 推出 Transformer 模型后,OpenAI 团队马上意识 到这种神经网络架构将显著优于传统序列神经网络的性能,有可能对于研发大型 神经网络产生重要的影响。他们很快着手使用 Transformer 架构研发语言模型,并 于 2018 年发布了第一个 GPT 模型,即 GPT-1,模型名称 GPT 是生成式预训练 2本部分讨论的内容是作者基于调研 OpenAI 发布的论文、博客文章、采访报道和 API 说明文档所形 成的个人理解。 3https://hackernoon.com/an-interview-with-ilya-sutskever-co-founder-of-openai 26