还存在什么问题呢? ·Web规模在不断增长,容量巨大 一必须具备高效率 ·1 billion pages/per month→385 pages/,sec -Crawler.系统的瓶颈在哪里? ·加更多收集机器是否能解决问题? ·在l/o部分,look-up(0,Store(0→特别是需要提高网络 带宽利用率 当数据量大到那些data structure?不能够在内存中放 下时→优化Is url or pages VISITED

还存在什么问题呢? • Web规模在不断增长,容量巨大 – 必须具备高效率 • 1 billion pages / per month→385pages/sec – Crawler系统的瓶颈在哪里? • 加更多收集机器是否能解决问题? • 在I/O部分,look-up(), Store() → 特别是需要提高网络 带宽利用率 • 当数据量大到那些data structure不能够在内存中放 下时 →优化 Is url or pages VISITED

还存在什么问题呢? The real world is not perfect -镜像与重复网页(mirrors and duplications) -url/html语法错误 -服务器陷阱(server traps) 么y -服务器抱怨 一法律问题 -系统崩溃, -停电.…

还存在什么问题呢? • The real world is not perfect – 镜像与重复网页 (mirrors and duplications) – url/html 语法错误 – 服务器陷阱(server traps) – 服务器抱怨 – 法律问题 – 系统崩溃, – 停电…

URL不唯一性 S门a新浪网,有多少个ip地址? sina.com.cn http://www.china-pub.com/browse/?typeid=02&ordertype=1 http://w.china-pub.com/browse/?typeid=02&ordertype=1&nonsense=1 ·不同u指向的同一个网页 一P地址和域名之间的多对多关系 ·大规模网站用于负载平衡的技术:内容镜像 ·“virtual hosting"和“Proxy pass”":不同的主机名映射到同一 个P地址,发布多个逻辑网站的需要(Apache支持) ·动态网页的参数 ·Session id ·上一页/下一页

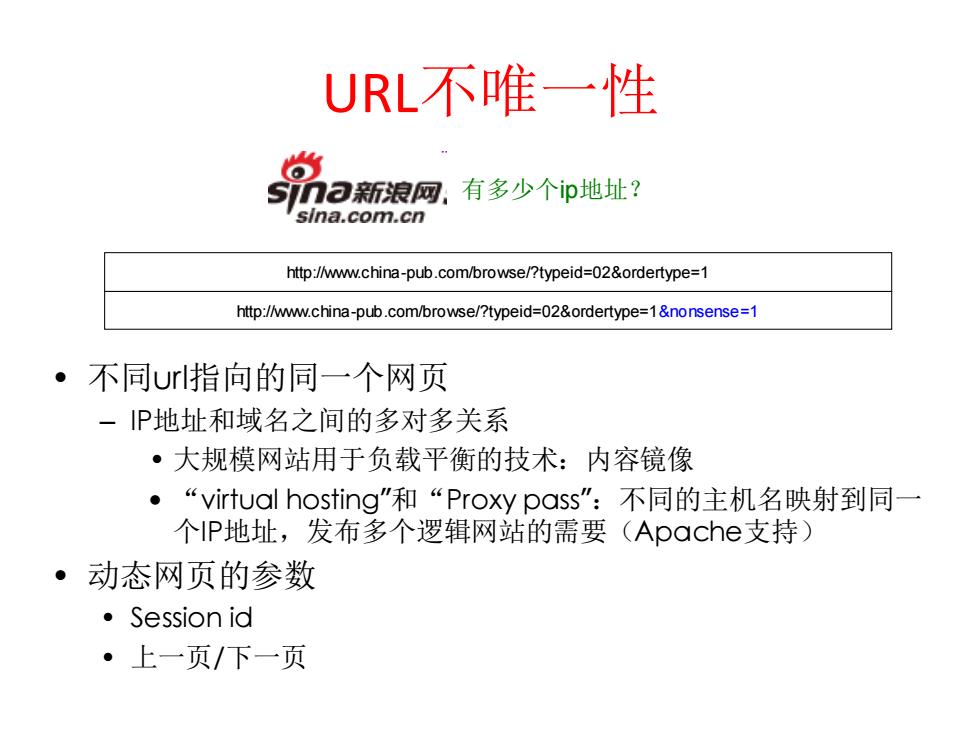

URL不唯一性 • 不同url指向的同一个网页 – IP地址和域名之间的多对多关系 • 大规模网站用于负载平衡的技术:内容镜像 • “virtual hosting”和“Proxy pass”:不同的主机名映射到同一 个IP地址,发布多个逻辑网站的需要(Apache支持) • 动态网页的参数 • Session id • 上一页/下一页 有多少个ip地址? http://www.china-pub.com/browse/?typeid=02&ordertype=1 http://www.china-pub.com/browse/?typeid=02&ordertype=1&nonsense=1

对URL进行规格化 ·用一个标准的字符串表示协议(http) 。 利用canonical主机名字 -查DNS会返回IP和一个canonical名字 ·显式加上一个端口号(80也加上) 。1 规格化并清理好文档路径 -不 例如将/books/,./papers/sigmod:1999.ps写成 /papers/sigmod1999.ps

对URL进行规格化 • 用一个标准的字符串表示协议(http) • 利用canonical主机名字 – 查DNS会返回IP和一个canonical名字 • 显式加上一个端口号(80也加上) • 规格化并清理好文档路径 – 例如将/books/../papers/sigmod1999.ps写成 /papers/sigmod1999.ps

Robot exclusion ·检查 -在服务器文档根目录中的文件,robots.txt,包含一个路 径前缀表,crawlers不应该跟进去抓文档,例如 #AltaVista Search User-agent:AltaVista Intranet V2.0 W3C Webreq Disallow:/Out-Of-Date #exclude some access-controlled areas User-agent: Disallow:/Team Disallow:/Proje ct Disallow:/Systems ·限制只是对crawlers,一般浏览无妨 -“君子协定”(你的crawler可以不遵守)

Robot exclusion • 检查 – 在服务器文档根目录中的文件,robots.txt, 包含一个路 径前缀表,crawlers不应该跟进去抓文档,例如 #AltaVista Search User-agent: AltaVista Intranet V2.0 W3C Webreq Disallow: /Out-Of-Date #exclude some access-controlled areas User-agent: * Disallow: /Team Disallow: /Project Disallow: /Systems • 限制只是对crawlers,一般浏览无妨 – “君子协定”(你的crawler可以不遵守)