马尔可夫决策过程 吉建民 USTC jianminOustc.edu.cn 2022年5月5日 4口卡404三·1怎生0C

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 马尔可夫决策过程 吉建民 USTC jianmin@ustc.edu.cn 2022 年 5 月 5 日

Used Materials Disclaimer:本课件大量采用了Rich Sutton's RL class,David Silver's Deep RL tutorial和其他网络课程课件,也采用了GitHub 中开源代码,以及部分网络博客内容 口·三4,进分双0

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Used Materials Disclaimer: 本课件大量采用了 Rich Sutton’s RL class, David Silver’s Deep RL tutorial 和其他网络课程课件,也采用了 GitHub 中开源代码,以及部分网络博客内容

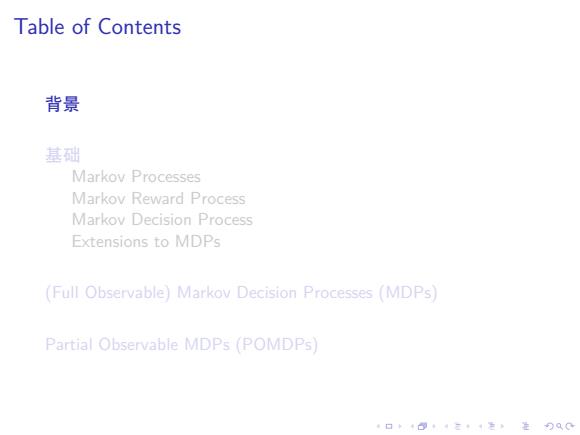

Table of Contents 背景 基础 Markov Processes Markov Reward Process Markov Decision Process Extensions to MDPs (Full Observable)Markov Decision Processes (MDPs) Partial Observable MDPs (POMDPs) 4口◆4⊙t1三1=,¥9QC

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Table of Contents 背景 基础 Markov Processes Markov Reward Process Markov Decision Process Extensions to MDPs (Full Observable) Markov Decision Processes (MDPs) Partial Observable MDPs (POMDPs)

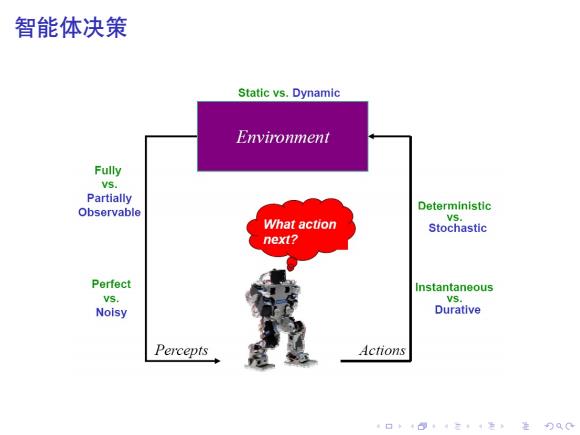

智能体决策 Static vs.Dynamic Environment Fully Vs. Partially Observable Deterministic VS. What action Stochastic next? Perfect Instantaneous VS. VS. Noisy Durative Percepts Actions 口卡·三4色,是分QC

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 智能体决策

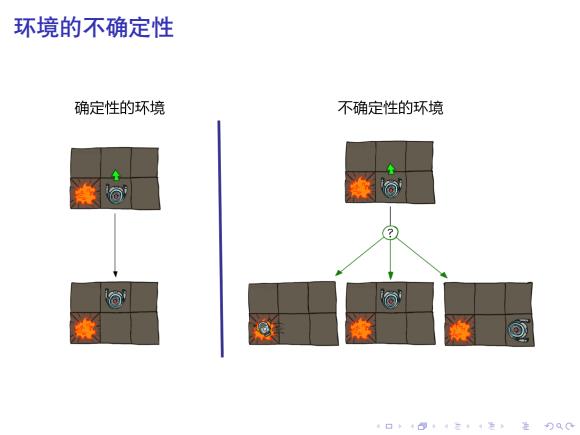

环境的不确定性 确定性的环境 不确定性的环境 a 4口◆4⊙t4三1=,¥9QC

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 环境的不确定性