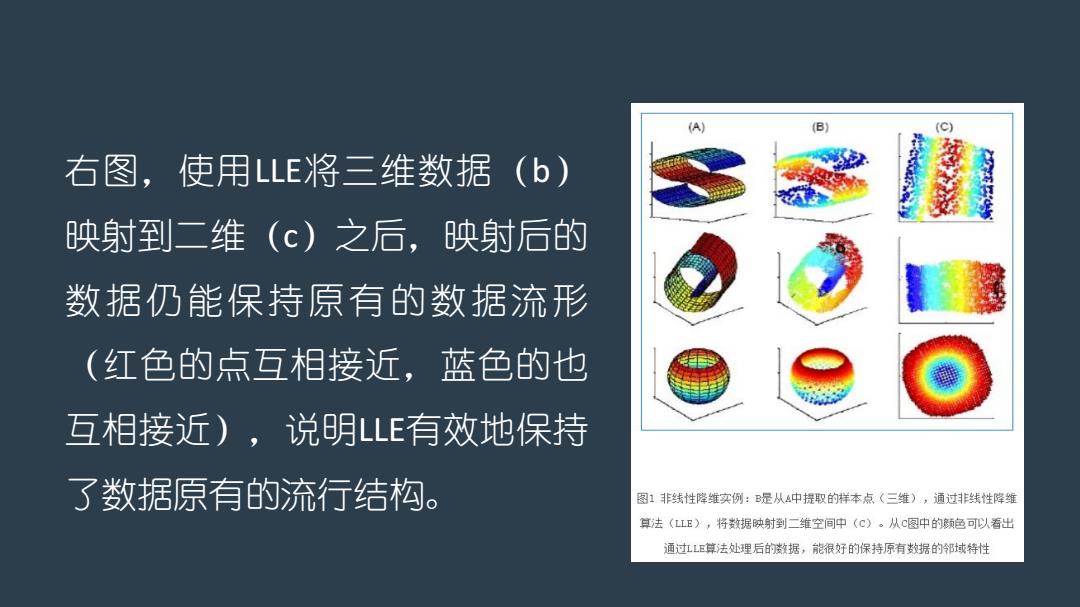

(A) (B) (c) 右图,使用LLE将三维数据(b) 映射到二维(c)之后,映射后的 数据仍能保持原有的数据流形 (红色的点互相接近,蓝色的也 互相接近),说明LE有效地保持 了数据原有的流行结构。 图1非线性降维实例:是从A中提取的样本点(三维),通过非线性降维 算法(LL正),将数据映射到二维空间中(C)。从c图中的颜色可以看出 通过LE算法处理后的数据,能很好的保持原有数据的邻域特性

右图,使用LLE将三维数据(b) 映射到二维(c)之后,映射后的 数据仍能保持原有的数据流形 (红色的点互相接近,蓝色的也 互相接近),说明LLE有效地保持 了数据原有的流行结构

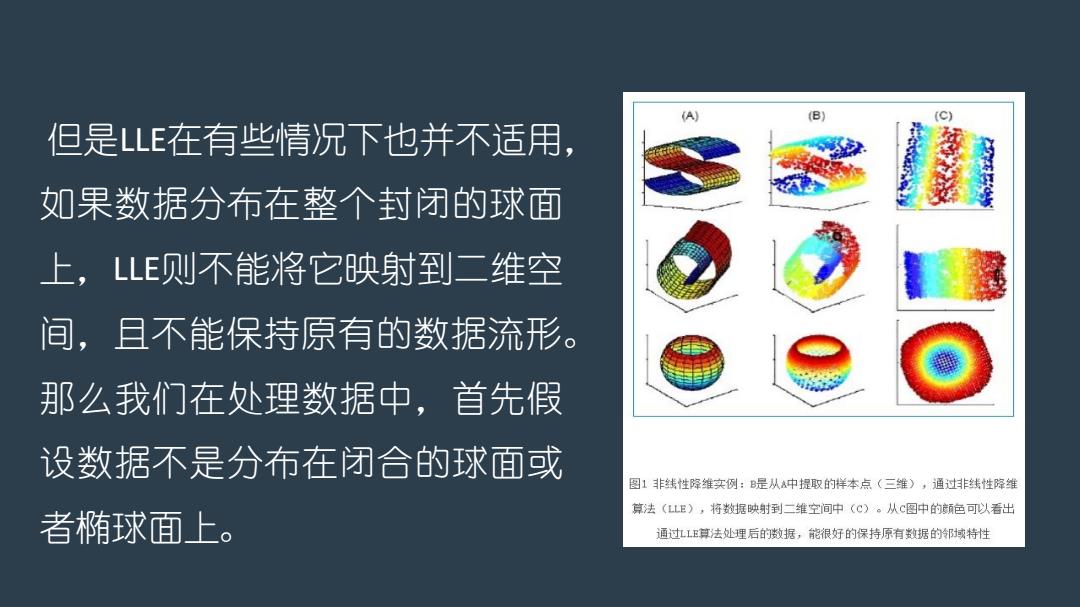

但是LLE在有些情况下也并不适用, 如果数据分布在整个封闭的球面 上,LLE则不能将它映射到二维空 间,且不能保持原有的数据流形。 那么我们在处理数据中,首先假 设数据不是分布在闭合的球面或 图1非线性降维实例:是从A中提取的样本点(三维),通过非线性降维 算法(LLE),将数据映射到二维空间中(C)。从C图中的色可以看出 者椭球面上。 通过1E算法处理后的数据,能很好的保持原有数据的邻域特性

但是LLE在有些情况下也并不适用, 如果数据分布在整个封闭的球面 上,LLE则不能将它映射到二维空 间,且不能保持原有的数据流形。 那么我们在处理数据中,首先假 设数据不是分布在闭合的球面或 者椭球面上

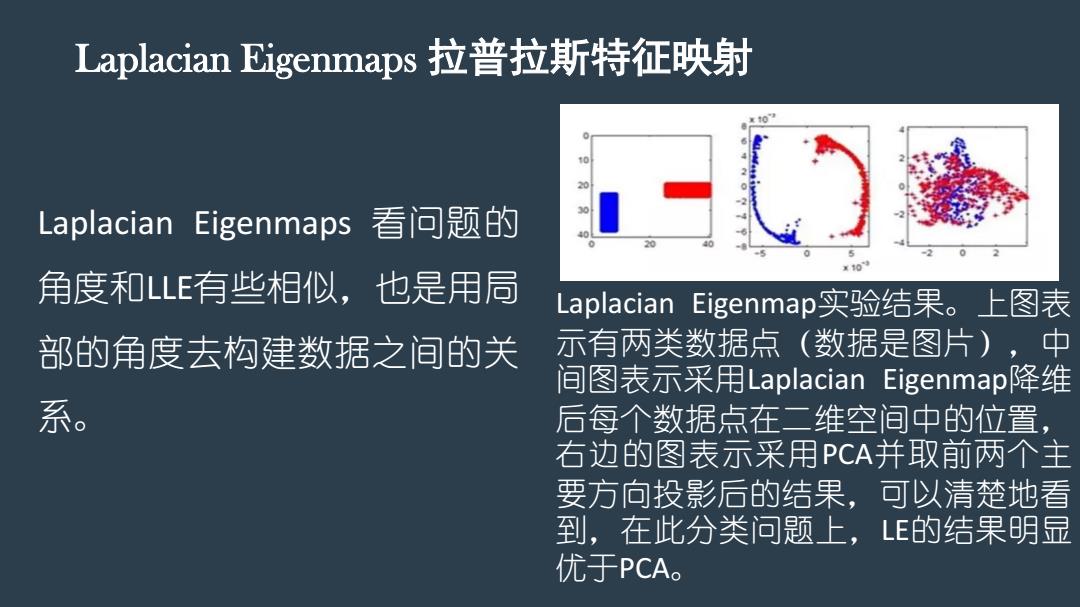

Lapla.cian Eigenmaps拉普拉斯特征映射 Laplacian Eigenmaps看问题的 x10 角度和LLE有些相似,也是用局 Laplacian Eigenmap实验结果。上图表 部的角度去构建数据之间的关 示有两类数据点(数据是图片),中 间图表示采用Laplacian Eigenmap降维 系。 后每个数据点在二维空间中的位置, 右边的图表示采用PCA并取前两个主 要方向投影后的结果,可以清楚地看 到,在比分类问题上,LE的结果明显 优于PCA

Laplacian Eigenmaps 拉普拉斯特征映射 Laplacian Eigenmap实验结果。上图表 示有两类数据点(数据是图片),中 间图表示采用Laplacian Eigenmap降维 后每个数据点在二维空间中的位置, 右边的图表示采用PCA并取前两个主 要方向投影后的结果,可以清楚地看 到,在此分类问题上,LE的结果明显 优于PCA。 Laplacian Eigenmaps 看问题的 角度和LLE有些相似,也是用局 部的角度去构建数据之间的关 系