主成分分析PCA Principal Component Analysis(PcA)是最常用的线 性降维方法,它的目标是通过某种线性投影, 将高维的数据映射到低维的空间中表示,并期 望在所投影的维度上数据的方差最大,以此使 用较少的数据维度,同时保留住较多的原数据 点的特性

主成分分析PCA Principal Component Analysis(PCA)是最常用的线 性降维方法,它的目标是通过某种线性投影, 将高维的数据映射到低维的空间中表示,并期 望在所投影的维度上数据的方差最大,以此使 用较少的数据维度,同时保留住较多的原数据 点的特性

通俗的理解,如果把所有的点都映射到 起,那么几乎所有的信息(如点和点之间的距 离关系)都丢失了,而如果映射后方差尽可能 的大,那么数据点则会分散开来,以此来保留 更多的信息。 可以证明,PCA是丢失原始数据信息最少 的一种线性降维方式

通俗的理解,如果把所有的点都映射到一 起,那么几乎所有的信息(如点和点之间的距 离关系)都丢失了,而如果映射后方差尽可能 的大,那么数据点则会分散开来,以此来保留 更多的信息。 可以证明,PCA是丢失原始数据信息最少 的一种线性降维方式

Linear Discriminant Analysis Linear Discriminant Analysis是一种有监督 的线性降维算法。与PCA保持数据信息不同, LDA是为了使得降维后的数据点尽可能地容易 被区分

Linear Discriminant Analysis Linear Discriminant Analysis 是一种有监督 的线性降维算法。与PCA保持数据信息不同, LDA是为了使得降维后的数据点尽可能地容易 被区分

假设原始数据表示为X, (m*n矩阵,m是维 度,n是sample的数量)。我们希望找到映射向 量a,使得a'X后的数据点能够保持以下两种性 质: 1、同类的数据点尽可能的接近(within class) 2、不同类的数据点尽可能的分开(between class)

假设原始数据表示为X,(m*n矩阵,m是维 度,n是sample的数量)。我们希望找到映射向 量a, 使得 a‘X后的数据点能够保持以下两种性 质: 1、同类的数据点尽可能的接近(within class) 2、不同类的数据点尽可能的分开(between class)

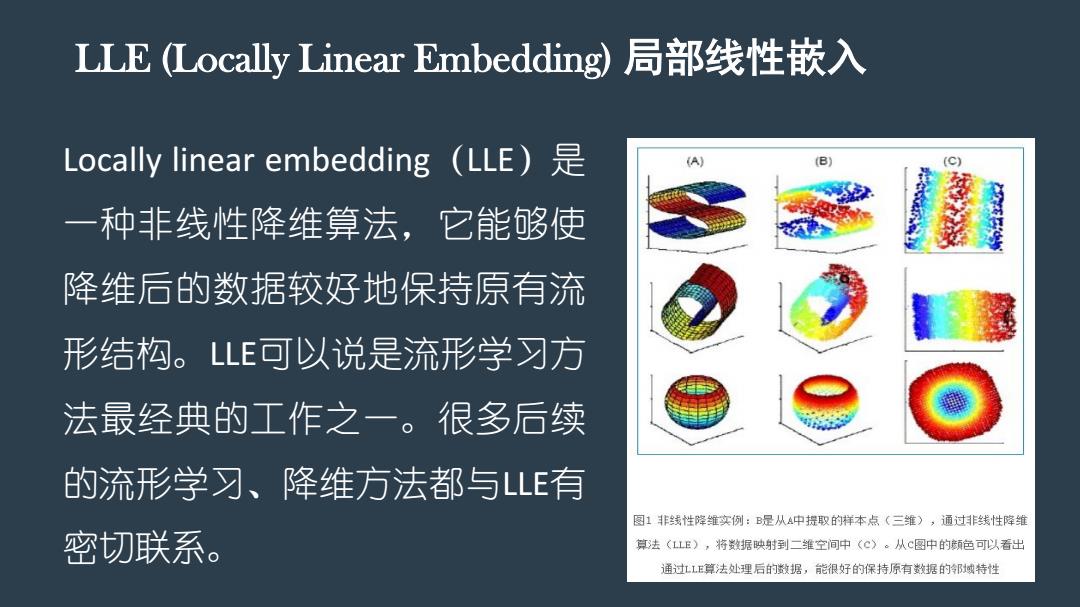

LLE (Locally Linear Embedding)局部线性嵌入 Locally linear embedding (LLE) (A) (B) (C) 一种非线性降维算法,它能够使 降维后的数据较好地保持原有流 形结构。LE可以说是流形学习方 法最经典的工作之一。很多后续 的流形学习、降维方法都与LLE有 图1非线性降维实例:B是从A中提取的样本点(三维),通过非线性降维 密切联系。 算法(LLE),将据映射到二维空间中(C)。从C图中的颜色可以看出 通过LE算法处理后的数据,能很好的保持原有数据的邹域特性

LLE (Locally Linear Embedding) 局部线性嵌入 Locally linear embedding(LLE)是 一种非线性降维算法,它能够使 降维后的数据较好地保持原有流 形结构。LLE可以说是流形学习方 法最经典的工作之一。很多后续 的流形学习、降维方法都与LLE有 密切联系