解析算法 ·假设我们把所有的训练数据装在一起形成一个大矩阵, (x')7 (d)" (x2)1 (d) 有X∈RNxM,X= 以及d= (x)7 (d)T DX∈RNXMi 称为design matrix or data matrix。 可以得到: 2w-w-d=2∑Irw-d=h(m 10/51

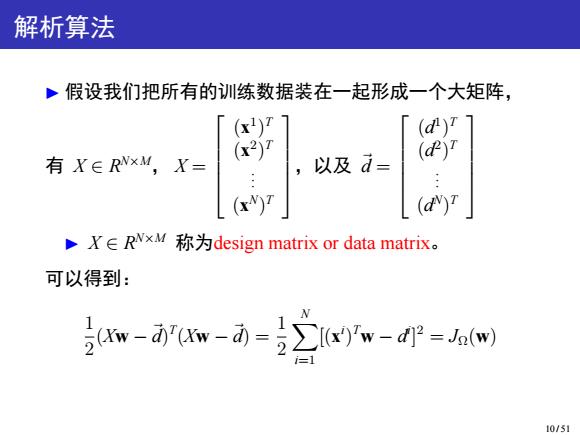

解析算法 ▶ 假设我们把所有的训练数据装在一起形成一个大矩阵, 有 X ∈ R N×M, X = (x 1 ) T (x 2 ) T . . . (x N ) T ,以及 ⃗d = (d 1 ) T (d 2 ) T . . . (d N ) T ▶ X ∈ R N×M 称为design matrix or data matrix。 可以得到: 1 2 (Xw −⃗d) T (Xw −⃗d) = 1 2 X N i=1 [(x i ) Tw − d i ] 2 = JΩ(w) 10 / 51

因此, 7Jn(w)=7ww-dw-i jVw(w'XXw-wxd-qxw+jd =j((Xx+XXw-xq-xa) -=xTxw-xTd 要最小化J2(w),令其导数为零,则有: XTXw=X'd,=x(x)T:sample correlation matrix i1 如逆存在(一般假定样本为ii.d,N>M时),可得显示 解: w=()-1Xa pseudo-inverse of Y:(XX)-1x 注意,此处X是由特征向量x的行向量形式构成,不是列向量形 式,因此XTX形式上看是Gram Matrix,实际不是样本的Gram 11/51

因此, ▽wJΩ(w) = ▽w 1 2 (Xw −⃗d) T (Xw −⃗d) = 1 2 ▽w (w TX TXw − w TX T⃗d −⃗d TXw +⃗d T⃗d) = 1 2 ((X TX + X TX)w − X T⃗d − X T⃗d) = X TXw − X T⃗d ▶ 要最小化 JΩ(w) ,令其导数为零,则有: X TXw = X T⃗d, X TX = X N i=1 x i (x i ) T : sample correlation matrix ▶ 如逆存在(一般假定样本为 i.i.d., N ≥ M 时),可得显示 解: w = (X TX) −1X T⃗d, pseudo-inverse of X : (X TX) −1X T 注意,此处 X 是由特征向量 x i 的行向量形式构成,不是列向量形 式,因此 X TX 形式上看是 Gram Matrix,实际不是样本的 Gram Matrix。 11 / 51

批量梯度下降的矩阵形式 对N个样本的批量梯度下降: w+1=w,+n∑d-wx)x i=1 N =w,+n∑x(d-(x)w, N =w,+n∑xd-∑x(xw,) i=1 i=1 =w+n(Xd-X Xwi) 同又wJ2(w)的矩阵形式一致: VwJ(W)=YYw-Xd 12/51

批量梯度下降的矩阵形式 ▶ 对N 个样本的批量梯度下降: wt+1 = wt + η X N i=1 (d i − w T t x i )x i = wt + η X N i=1 x i (d i − (x i ) Twt) = wt + η( X N i=1 x i d i − X N i=1 x i (x i ) Twt) = wt + η(X T d − X TXwt) ▶ 同 ▽wJΩ(w) 的矩阵形式一致: ▽wJΩ(w) = X TXw − X T⃗d 12 / 51

其他求导方式 Jacobian Formulation Oxx =2x, OAx Ox Ox =A,A∈Rx",X∈R™ Chain rule: 0g(u(x》_ 8g(u)ou(x) x∈R,u∈Rm,g∈R Ox Ou Ox OJg(w) (Xw-d)"(Xw-d)1OuTu Ou Ow Ow 20u0 1-(xw-d)"x Hessian Formulation OxTx 6Ax =2x, Ox =A,A∈RmX",x∈R Ox Chain rule: 8g(u(x)) _au(x)agu) x∈R,u∈Rm,g∈R 0尔 Ox Ou 7wJn(w)=7ww-dXw-d=7n(u7.uu=X(Kw-d西 13/51

其他求导方式 ▶ Jacobian Formulation ∂x Tx ∂x = 2x T , ∂Ax ∂x = A, A ∈ R m×n , x ∈ R n Chain rule: ∂g(u(x)) ∂x = ∂g(u) ∂u ∂u(x) ∂x , x ∈ R n , u ∈ R m , g ∈ R ∂JΩ(w) ∂w = ∂ 1 2 (Xw −⃗d) T (Xw −⃗d) ∂w = 1 2 ∂u Tu ∂u ∂u ∂w = (Xw−⃗d) TX ▶ Hessian Formulation ∂x Tx ∂x = 2x, ∂Ax ∂x = A T , A ∈ R m×n , x ∈ R n Chain rule: ∂g(u(x)) ∂x = ∂u(x) ∂x ∂g(u) ∂u , x ∈ R n , u ∈ R m , g ∈ R ▽wJΩ(w) = ▽w 1 2 (Xw−⃗d) T (Xw−⃗d) = 1 2 ▽w(u)▽uu Tu = X T (Xw−⃗d) 13 / 51

一个问题 线性回归方程,需要含有截距b,如二元线性方程为: y=wx+b,w=(w1,w2)T,X=(x1,x2)2 将截距b引入w有: y=wx,w=(b,w1,w2)T,x=(1,1,2) ·引入系统噪声e有: d=y+E=wx+e 14/51

一个问题 ▶ 线性回归方程,需要含有截距 b ,如二元线性方程为: y = w T x + b, w = (w1,w2) T , x = (x1, x2) T ▶ 将截距 b 引入 w 有: y = w T x, w = (b,w1,w2) T , x = (1, x1, x2) T ▶ 引入系统噪声 ε 有: d = y + ε = w T x + ε 14 / 51