网络爬虫 数据科学引论((Python.之道) Powered by陈吴鹏

Powered b y 陈 昊 鹏 网络爬虫 数据科学引论(Python之道)

爬虫是什么 爬虫crawler,即网络爬虫Spider。是去自动化获取网络上的内容,是一个能够自动化地 访问互联网并将网站内容下载下来的的程序或脚本。 Powered by陈吴鹏

Powered b y 陈 昊 鹏 爬虫是什么 爬虫crawler,即网络爬虫Spider。是去自动化获取网络上的内容,是一个能够自动化地 访问互联网并将网站内容下载下来的的程序或脚本

为什么需要爬虫? 高效自动化地从网络获取收集数据,后续可做数据处理。 详情 仙踪林 鱼蛋粉濑粉姜撞奶 详情 公 内蒙吉 杯面拉肠菜茶饭堂 艇行 详情 猪扒 咸茶 详情 菜 掩面斋年牛粉 详情 洋情 南海诸岛 Powered by陈吴腑

Powered b y 陈 昊 鹏 为什么需要爬虫? 高效自动化地从网络获取收集数据,后续可做数据处理

基本流程 B 心0变本 机构 投资总数最新投资事件 Secure https://www.itjuzi.com/investfirm Scrapy 1DG资本 725 品生医学 提中围 6.0 经纬中国 602 皇包车 URL HTML TOOL FORMAT 地址 网页原内容 工具 格式 统一资源定位 网页内容编码 爬虫工具 统一化格式 符(网址) 根据url指定 我们要从中 访问网页并 得到信息将 需要爬取的 提取我们需 从html解析 数据整理成 网页 要的关键信 信息的具体 统一格式导 息 工具,如 出 Scrapy Powered by陈吴鹏

Powered b y 陈 昊 鹏 基本流程 URL HTML TOOL 工具 FORMAT 格式 统一资源定位 符(网址) 根据url指定 需要爬取的 网页 网页原内容 网页内容编码 我们要从中 提取我们需 要的关键信 息 地址 爬虫工具 访问网页并 从html解析 信息的具体 工具,如 Scrapy 统一化格式 得到信息将 数据整理成 统一格式导 出

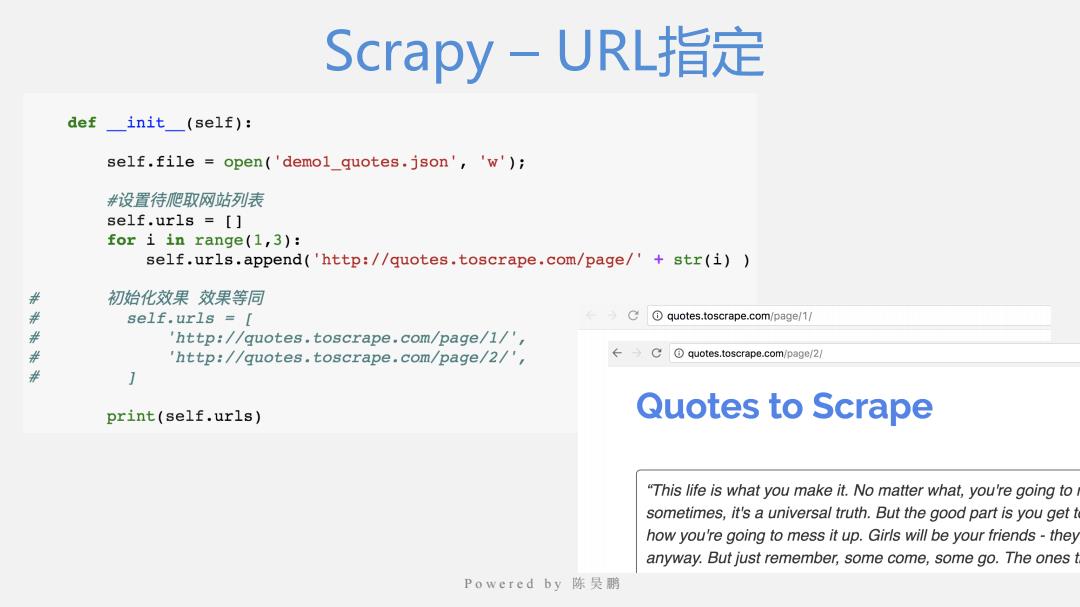

Scrapy-URL指定 definit_(self): self.file open('demol_quotes.json','w'); #设置待爬取网站列表 self.urls [ for i in range(1,3): self.urls.append('http://quotes.toscrape.com/page/'+str(i)) 年 初始化效果效果等同 并 self.urls = Cquotes.toscrape.com/page/1/ 米 'http://quotes.toscrape.com/page/1/', # 'http://quotes.toscrape.com/page/2/', ←→equotes.toscrape.com/page/2/ 并 print(self.urls) Quotes to Scrape "This life is what you make it.No matter what,you're going to sometimes,it's a universal truth.But the good part is you get t how you're going to mess it up.Girls will be your friends-they anyway.But just remember,some come,some go.The ones t Powered by陈吴腑

Powered b y 陈 昊 鹏 Scrapy – URL指定