第6卷第3期 智能系统学报 Vol.6 No.3 2011年6月 CAAI Transactions on Intelligent Systems Jun.2011 doi:10.3969/j.issn.16734785.2011.03.007 基于局部纹理ASM模型的人脸表情识别 彭程,刘帅师1,万川,田彦涛2 (1.吉林大学通信工程学院,吉林长春130025:2.吉林大学工程仿生教育部重点实验室,吉林长春130025) 摘要:针对主动形状模型(ASM)迭代过程容易陷入局部最优解的不足,提出了一种基于局部纹理模型的改进ASM 算法,即EWASM.在局部纹理模型构建中,以每个特征点的中垂线方向搜索其邻域信息以确定最佳匹配位置,对衡 量匹配程度的马氏距离加以推广,进而得到改进的扩展加权局部纹理模型,它由中心局部纹理模型、前局部纹理模 型和后局部纹理模型共3个子模型加权组成,并对加权参数进行实验优化,使各个特征点之间的联系更加紧密,模 型的鲁棒性更好.通过表情识别实验对提出的EWASM算法和传统ASM算法进行对比,选用RBF神经网络分类器进 行表情分类,实验结果表明EWASM算法收敛速度更快,识别率也得以提高,并解决了局部最小问题,能更有效地表 征表情. 关键词:人脸表情识别:主动形状模型:局部纹理模型;RBF神经网络分类器 中图分类号:TP391文献标识码:A文章编号:16734785(2011)03023108 An active shape model for facial expression recognition based on a local texture model PENG Cheng',LIU Shuaishi',WAN Chuan',TIAN Yantao1.2 (1.School of Communication Engineering,Jilin University,Changchun 130025,China;2.Key Laboratory of Bionic Engineering (Ji- lin University),Ministry of Education,Changchun 130025,China) Abstract:An improved active shape model(ASM)called EWASM (expanded weighted ASM)based on a local tex- ture model was proposed because EWASM overcomes the disadvantage that the active shape model is easy to involve in local optimal solution in the iterative process.In the local texture model,searching adjacent information of each landmark along its perpendicular bisector made the match position best.It improved and promoted Mahalanobis dis- tance which measured the matching degree.Then the local texture model was extended to include the center local texture model,forward local texture model,and backward local texture model.After that,the weighted parameters were optimized experimentally.Thus each landmark is more closely related and the local texture model is more ro- bust.Finally facial expression recognition experiments were conducted comparing EWASM with classical ASM,and a RBF neural network was used as a classification in the expression recognition.Experiments show that the EWASM algorithm solved the local minimum problem and achieved a better convergence rate and recognition effect. Keywords:facial expression recognition;active shape model;local texture model;RBF neural network classifier 人脸表情不仅在人与人的交流中发挥着重要的中是一个关键环节.目前最受关注的特征提取方法是 作用,而且是实现人机交互,使计算机能够更准确地 Cootes等人于1995年提出的主动形状模型(active 理解人的表情和意图的一个重要研究内容.一个完整 shape model,ASM)方法12i,其模型允许一定程度上 的人脸表情识别系统由人脸检测、特征提取和表情分 形状的变化,可以更好地定位物体的内外轮廓,又不 类3个部分组成.其中特征提取在整个表情识别过程 会脱离目标对象的本质特征;但该模型对初始形状的 定位非常敏感,本质上是一个求局部最优的过程,有 收稿日期:2010-1126. 基金项目:吉林省科技发展计划重点资助项目(20071152):吉林大学 时不能发现全局最优解,存在着一定的局限性,因此 “985工程”工程仿生科技创新平台项目资助;吉林大学研 究生创新基金资助项目(20101027). 吸引了国内外广大学者对其进行研究, 通信作者:田彦涛.Email:tianyt@jlu.edu.cm. 1998年,Cootes等人进一步提出了主动表观模

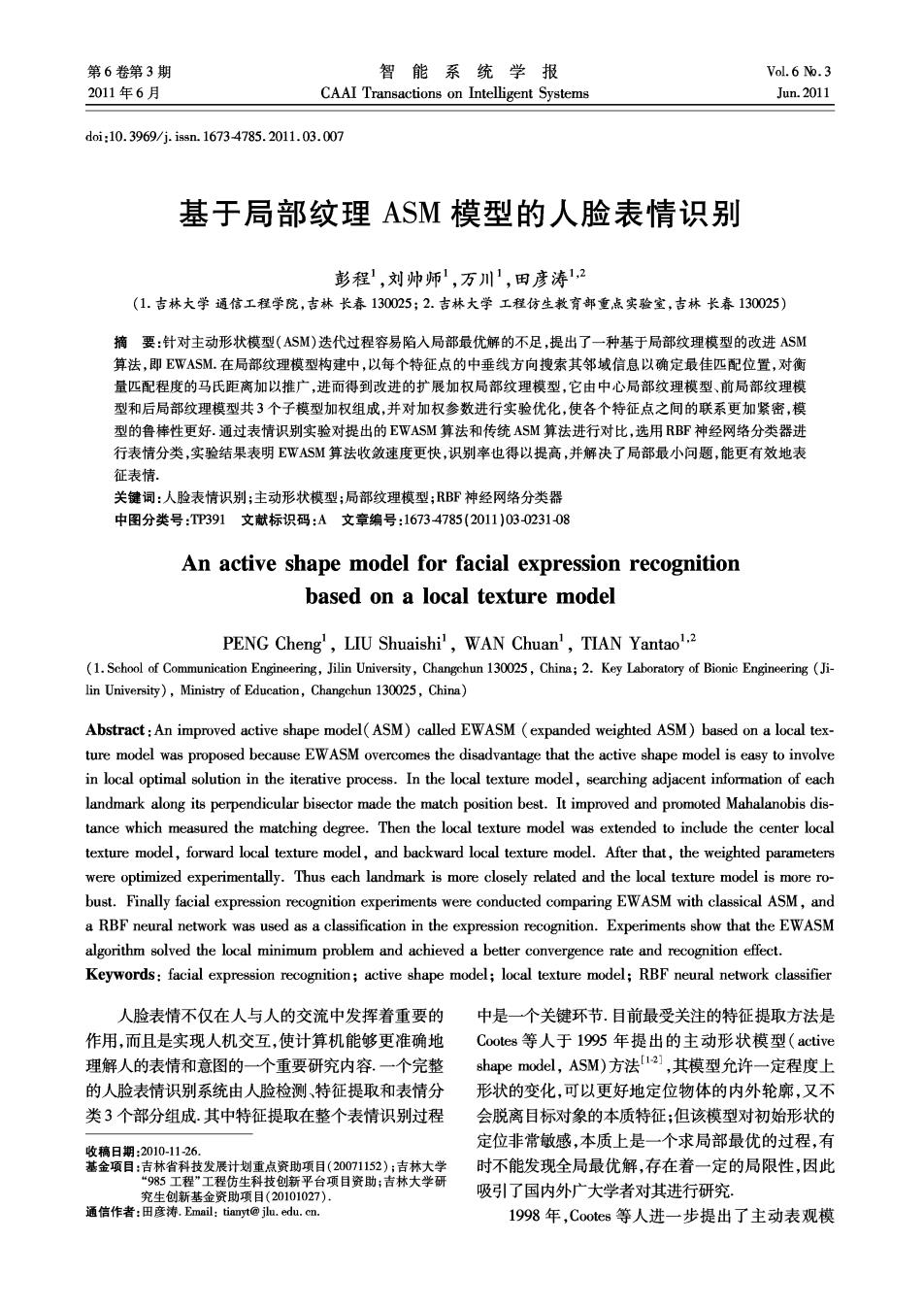

·232 智能系统学报 第6卷 型(active appearance model,AAM)[23].AAM建立 考虑全局形状模型: 了关于人脸的形状与纹理的组合模型,因此定位更 X=X+Pb 精确,但运算速度与ASM相比较慢.M.Rogers和J. 式中:X是一个形状;X表示平均形状;P是主成分 Graham4用一种具有鲁棒性的最小二乘技术来最 特征向量构成的变换矩阵;b为权值向量,使用主成 小化全局统计模型和未知形状之间的差值,这一改 分分析法控制前t个特征值的系数,不同的b对应 进使得全局统计模型表示的形状不容易受特征点中 不同的形状,并且对b加以限定:-3A:<b:< 的噪声和野值的影响,但计算工作量较大.Van Gin- 3/入:,i=1,2,…,t,其中入k(入≥入k+1,入k≠0,k=1, nenken等人[s提出一种改进局部纹理模型方法,用 2,…,2n)是协方差矩阵的特征值. “局部无序图像”[6]计算得到的局部纹理特征代替 给定局部纹理模型为: 传统ASM的法线模型,用K近邻分类器对特征点进 行匹配,但在特征属性较多时K近邻分类器的分类 G,=六6 精度大大降低.Faruquie等人[门运用ASM方法检测 5=8a,-a,G,6, N 嘴唇的轮廓,使用5条曲线代表嘴唇的轮廓,进而降 低了参数个数,将彩色信息加人ASM,获得了较好 式中:G:是对第i幅训练图像的第j个标定点的灰 的匹配效果.G.Hamarneh等人[8]将ASM的特征扩 度信息归一化后的纹理向量,即 展到时间空间的形状,并且设计出一种新的算法,使 1 得时间空间形状模型能更好地与图像序列中的目标 G=2k dsi' 轮廓匹配.李皓等人[91提出了多模板ASM定位算 ∑1dg 法,先利用全局模板定位总体,再利用局部模板定位 dg=[g到2-gg1,69.21-6,24], 局部,从而改善ASM纹理平滑区域特征点定位不精 其中第i个特征点的灰度信息是以该特征点为中心沿 确的问题.Chen等人[o1把局部变量引入到ASM 法线方向上下各取k个点的灰度来表示,即8y=[g1 中,进行图像变形检测和形状修正,从而有效避免了 8,2…8,24+1];C是平均纹理;Sc是协方差矩阵 图像的变形,提高了匹配准确性, 在目标图像搜索确定标定点的最佳匹配位置 以上这些改进方法只保留传统ASM的基本思 时,希望准确定位每个特征点,因此需搜索特征点附 想,具体操作过程与传统ASM方法差别较大,在改 近的邻域信息,最直接的方法就是分析邻域的灰度 进ASM的同时也增加了复杂性.而本文针对ASM 信息,以确定最佳匹配位置.匹配程度用式(1)的马 易陷入局部最优的缺点,提出了局部纹理模型的改 氏距离[1s来描述 进算法(expanded weighted ASM,EWASM),以每个 d(G)=(G-G)(Sc)(Gg-Gg).(1) 特征点的中垂线方向搜索其邻域信息以确定最佳匹 式中:G是由目标搜索图像在j点附近采样得到的 配位置,根据每个特征点的邻域信息,对衡量匹配程 归一化纹理向量;d(G)最小值对应的点即是最佳 度的马氏距离准则函数加权扩展,由3个子模型共 候选点。 同描述局部纹理模型的特性,更准确定位目标图像, 1.2 EWASM算法 通过特征点间的制约解决局部最小问题,并且通过 虽然ASM方法的有效性己被广泛证实,但是传 实验比较和分析,验证了改进算法的有效性, 统的ASM仍存在诸多不足.1)ASM的鲁棒性不够 理想,迭代过程的收敛性非常依赖于初始形状的定 1 EWASM算法 位,初始位置的改变往往影响迭代次数,甚至导致无 1.1主动形状模型 法达到收敛;2)ASM本质上是一个求局部最优的过 主动形状模型是基于统计学习模型的特征点提 程,有时不能发现全局最优解,容易陷入局部最小 取方法2],其首先提取面部形状的特征点集合, 针对这些问题,本文提出了EWASM算法.如图 形成训练集,通过统计分析构造样本的全局形状模 1(a),EWASM算法中,以点P。为中心到其相邻特 型.然后利用局部纹理模型在目标图像中搜索特征 征点(P,P)连线的垂线F方向上下各取相同像 点的最佳匹配位置,同时根据匹配结果调整全局模 素,得到特征点P。的灰度信息,点P与点P,的灰 型的相关参数,从而使模型与目标图像的实际轮廓 度信息求取同点P。,对以上3个特征点分别建立局 逐步逼近,最终准确定位目标 部纹理模型9],并命名为中心局部纹理模型、前局

第3期 彭程,等:基于局部纹理ASM模型的人脸表情识别 ·233· 部纹理模型和后局部纹理模型,这3个子模型的构 其相邻的特征点可以把它拉回至最佳位置,这样也 建过程一致,差别只在于采样点的位置不同.根据初 解决了模型容易陷入局部最优的问题、 始定点的位置,前局部纹理模型的特征点在中心局 3)充分利用给定点邻域内其他特征点的信息 部纹理模型的特征点的前面,同理,后局部纹理模型 以及各特征点之间的联系,保证定点的准确性,鲁棒 的特征点在中心局部纹理模型的后面.采用相同的 性更好 方法对训练集中每幅图像的特征点进行上述处理, 2 最终可以得到针对某个特征点P。相对应的3个平 实验结果与分析 均向量和3个协方差矩阵,分别记为、、:和分 实验使用国际标准的专门用于表情识别研究的 功、 数据库JAFFE(Japanese female facial expression), EWASM与传统ASM特征点定位实验中,训练样本 140幅,测试样本70幅.由于在表情识别中,鼻子和 面部轮廓对表情的影响不大,因此实验中只标定眉 (a)EWASM算法 (b)传统ASM算法 毛、眼晴和嘴巴共40个特征点,相对其他ASM研究 算法,EWASM方法定点较少、减少了计算量、提高 图1 EWASM算法与传统ASM算法中灰度信息求取 了收敛速度, 对比 表情分类实验中选出“生气”、“厌恶”、“恐 Fig.1 Gray information comparison between EWASM and classical ASM 惧”、“高兴”、“中性”、“悲伤”、“惊讶”7种手动定 把3个子模型的局部纹理模型根据式(1)的匹 点的140幅表情图像样本作为训练样本,其中各种 配准则进行加权求和,进而匹配准则函数可扩展为 表情的样本数目均为20幅.测试样本为自动定点的 d(g,,g)=a(g-)()-(-)+ 65幅表情图像,各种表情的样本数目依次为:10幅、 6(中-)()4(功-)+ 10幅、8幅、9幅、10幅、8幅、10幅. c(g-1)()(g-T) (2) 由于脸部特征向量与脸部表情之间的关系是一 式中:、、是目标搜索图像对应特征点P。的归 种非线性映射关系,而利用线性分类器不能准确地 一化后的中心局部纹理向量、前局部纹理向量和后 分类表情;因此选取了在理论上可以逼近任何非线 局部纹理向量,同样求取d(,,)的最小值就是 性函数的神经网络分类器,其具有收敛速度快、所需 点P。的最佳匹配位置;a、b、c是对应的加权参数, 参数少、局部最佳逼近等优点.其中选取RBF神经 分别为3个局部纹理子模型的权重,需满足a+b+ 网络分类器进行表情分类,高斯函数作为基函数,输 c=1和a,b,c≥0.文献[13]构建的加权模型,其参 入层的节点数为80,与输入特征向量的维数相等, 数人为设定,没有依据.而本文可以通过实验优化调 输出层的节点数选定为7,即类别数 整,从而确定加权参数的满意值,因此更为精确。 2.1加权参数选择实验 比较式(1)和式(2)可知,EWASM算法的匹配 EWASM算法的加权参数a、b、c作为3个子模 准则是传统ASM算法的匹配准则的扩展,即式(1) 型的权值决定每个子模型,所占的比重,即每个特征 是式(2)的一个特例,并且式(2)包含了3个子模型 点的分量.由于中心局部纹理模型作为特征点的主 的纹理信息,特征信息更广 要模型,在3个子模型中所占比重应最大,而前局部 由此可见,EWASM算法的优点如下. 纹理模型和后局部纹理模型比重几乎相等;因此α、 1)充分利用了面部特征区域的纹理信息来构 b、c可选为0.4、0.3、0.3,0.5、0.25、0.25,0.6、 造纹理向量,提供了更可靠的依据来确定目标图像. 0.2、0.2,0.7、0.15、0.15,0.8、0.1、0.1和0.9、 而传统ASM方法如图1(b),特征点P。的灰度信息 0.050.05.但当a、b、c为0.4、0.3、0.3时,前局部 是以点P。的法线F方向上下各取相同像素获得, 纹理模型和后局部纹理模型所占比重过大,中心局 与相邻特征点P、P.的相关信息无关,因此传统方 部纹理模型的核心作用无法体现出来,因此舍去这 法没有充分利用纹理信息. 组权值,当a、b、c为0.7、0.15、0.15,0.8,0.1,0.1 2)匹配准则得到了扩展,局部纹理模型通过3 和0.9,0.05,0.05时,前局部纹理模型和后局部纹 个子模型的加权求和,使各个特征点的联系更为紧 理模型所占比重过小,在模型构建中作用微弱,因此 密,互相控制和制约,若一个特征点发生严重偏离, 也舍去这3组权值,实验初步设定a、b、c为0.5

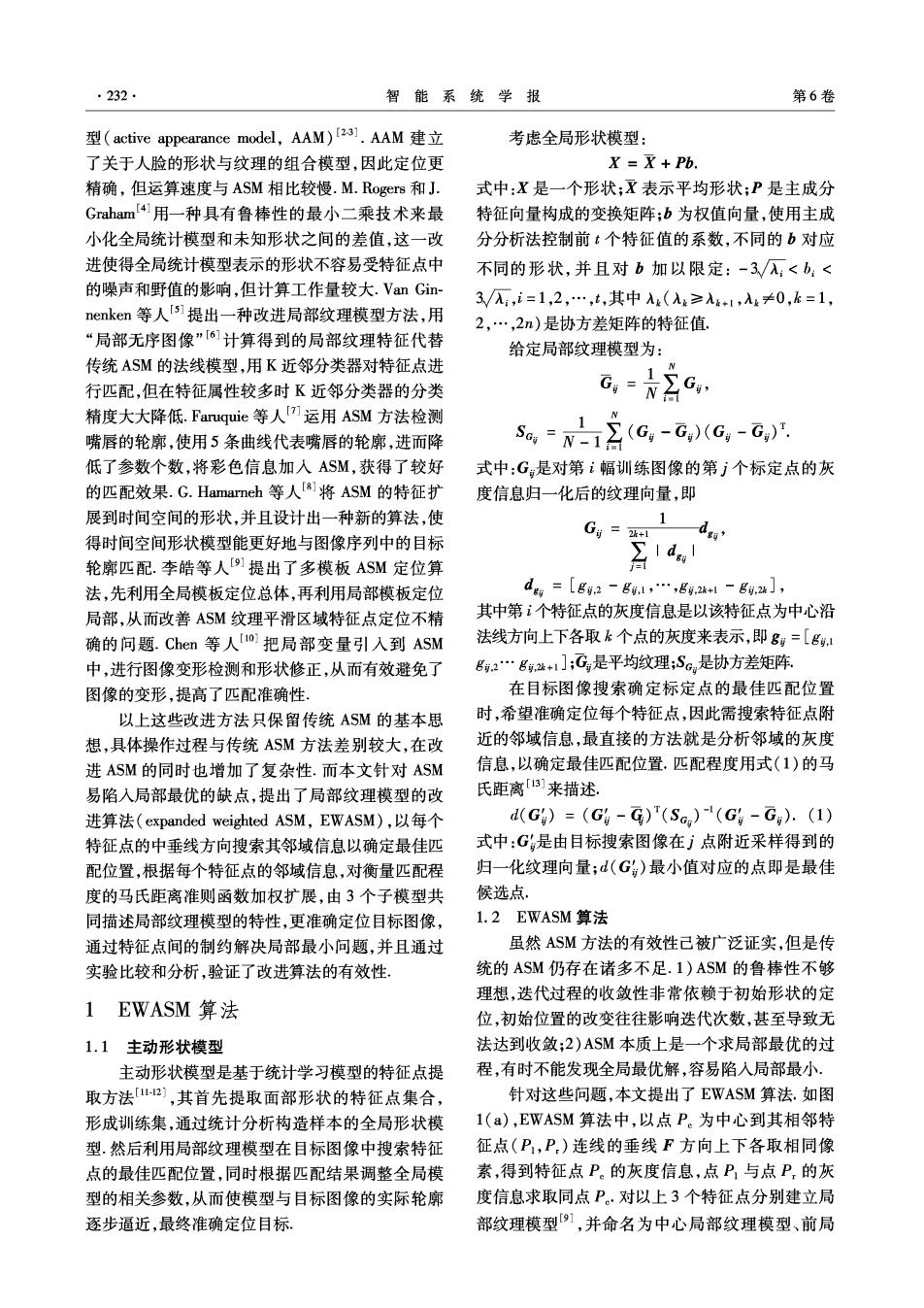

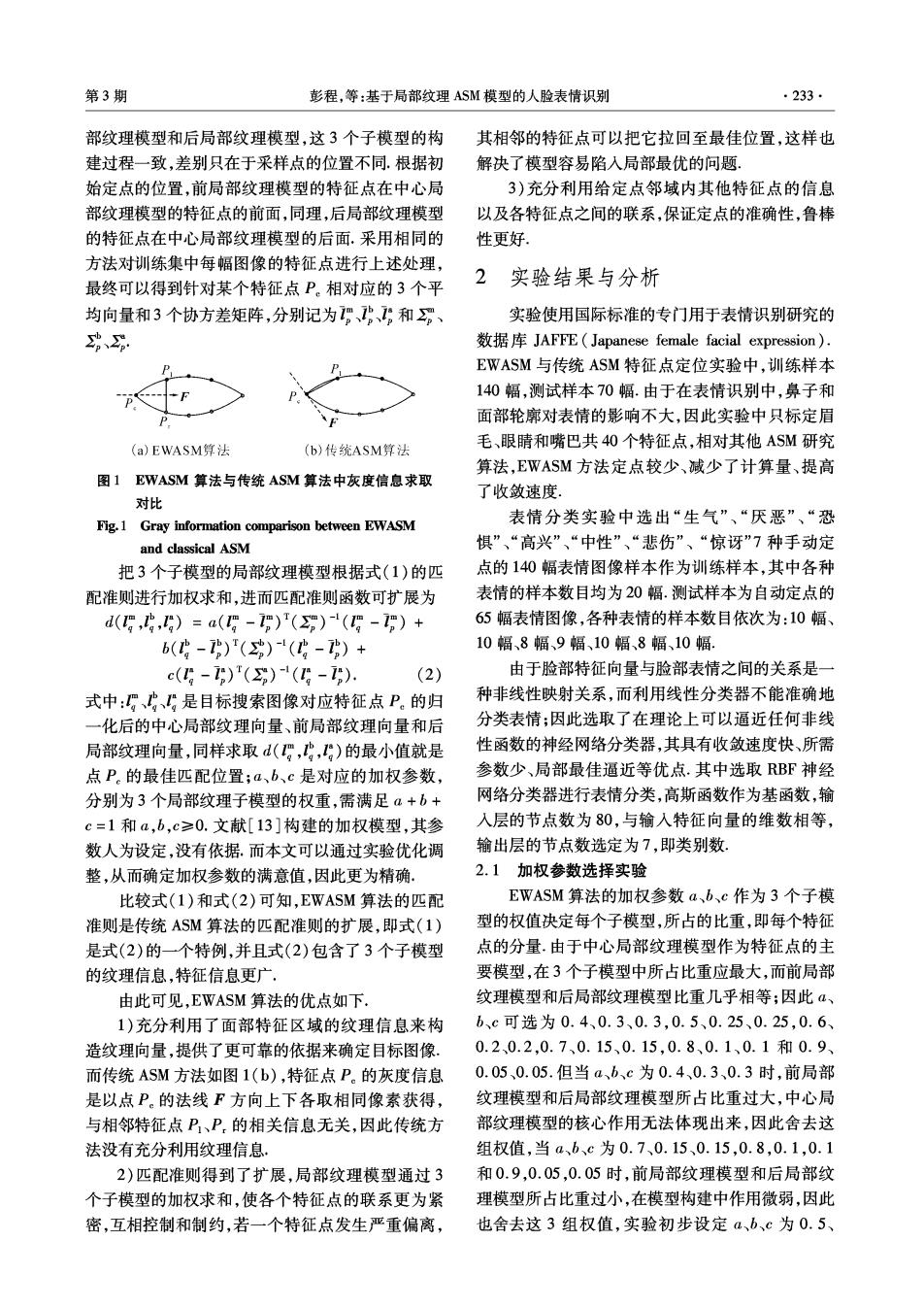

234 智能系统学报 第6卷 0.25、0.25及0.6、0.2、0.2较为合理 特征点定位更准确,表情识别率最高;因此本文通过 图2为EWASM特征点定位实验的加权参数比 实验优化调整,从而确定加权参数a、b、c的满意值 较.其中(a)、(b)是同一幅图像并且初始状态相同, 为0.6、0.2、0.2 (c)、(d)是同一幅图像并且初始状态相同.图2 (a)、(c)是加权参数为0.5、0.25、0.25迭代7次的 结果,(b)、(d)是加权参数为0.6、0.2、0.2迭代7 次的结果.可见加权参数a、b、c设定为0.6、0.2、0.2 的搜索效果相对较好一些, 在EWASM算法表情识别实验中,径向基宽度 (a) (b》 系数r可调节高斯函数的响应范围,依次设为0.1~ 0.9.表1的加权参数a、b、c为0.6、0.2、0.2,当r= 0.3和0.4时,达到最高识别率为80.91%,此时设定 径向基宽度系数为0.3或0.4取得最佳值.表2的加 权参数a、bc为0.5、0.25、0.25,当r=0.5时,达到 最高识别率为7769%,故此时设定径向基宽度系 数为0.5. (c) (d) 通过EWASM特征点定位实验和表情分类实验 图2 EWASM实验中加权参数4、b、c的结果对比 可见,加权参数a、b、c的满意值选定为0.60.20.2时, Fig.2 Comparison of weighted parameters a,b,c in EWASM experiment 表1基于EWASM与RBF表情识别结果(a=0.6、b=0.2、c=0.2) Table 1 Expression recognition results based on the EWASM algorithm and RBF (a=0.6,b=0.2,c=0.2) 正确识别数目 正确识别率/% 表情样本 类别 数目r=0.1r=0.3 '=0.5r=0.6 r=0.1r=0.3 r=0.8r=0.9 r=0.8r=0.9 r=0.2r=0.4 r=0.7 r=0.2r=0.4 r=0.5r=0.6 r=0.7 生气 10 8 1 6 6 50.00 80.0070.00 70.00 60.00 60.00 厌恶 10 &P 8 6 9 80.0080.0080.0090.0090.00 90.00 恐惧8 6 J 4 4 J 4 75.0062.5050.0050.0062.5050.00 高兴 9 6 8 8 6 6 7 66.6788.89 88.8966.67 66.6777.78 中性 10 8 9 9 9 8 8 80.0090.0090.0090.00 80.0080.00 悲伤 6 6 6 6 6 5 75.0075.0075.0075.0075.0062.50 惊讶 10 9 9 9 P > 90.0090.0090.0080.0080.0070.00 平均识别率/% 73.8180.9177.6974.5273.4570.04 表2基于EWASM与RBF表情识别结果(a=0.5、b=0.25、c=0.25) Table 2 Expression recognition results based on EWASM algorithm and RBF(a =0.5,b=0.25,c =0.25) 正确识别数目 正确识别率/% 表情 样本 类别数目 r=0.1 r=0.3 r=0.4 r=0.7 r=0.5 r=0.6 r=0.2 -0.8r=0.9 r=0.1 r=0.2 r=0.3=0.4 -0.7=0.5r=0.6 r=0.8r=0.9 生气 10 6 6 > 50.0060.00 60.0070.0050.00 50.00 厌恶 10 8 9 8 8 9 80.00 90.00 80.0080.00 90.00 90.00 恐惧 8 6 5 5 75.0050.0062.5050.00 62.5050.00 高兴 9 6 7 6 > 55.5566.6777.78 88.8966.67 77.78 中性 10 9 9 9 & & 80.0090.0090.00 90.0080.00 80.00 悲伤 & 6 6 6 6 6 75.0075.0075.0075.0075.00 62.50 惊讶 10 9 & & 90.0080.0080.0090.0080.0080.00 平均识别率/% 72.2273.1075.0477.6972.0270.04

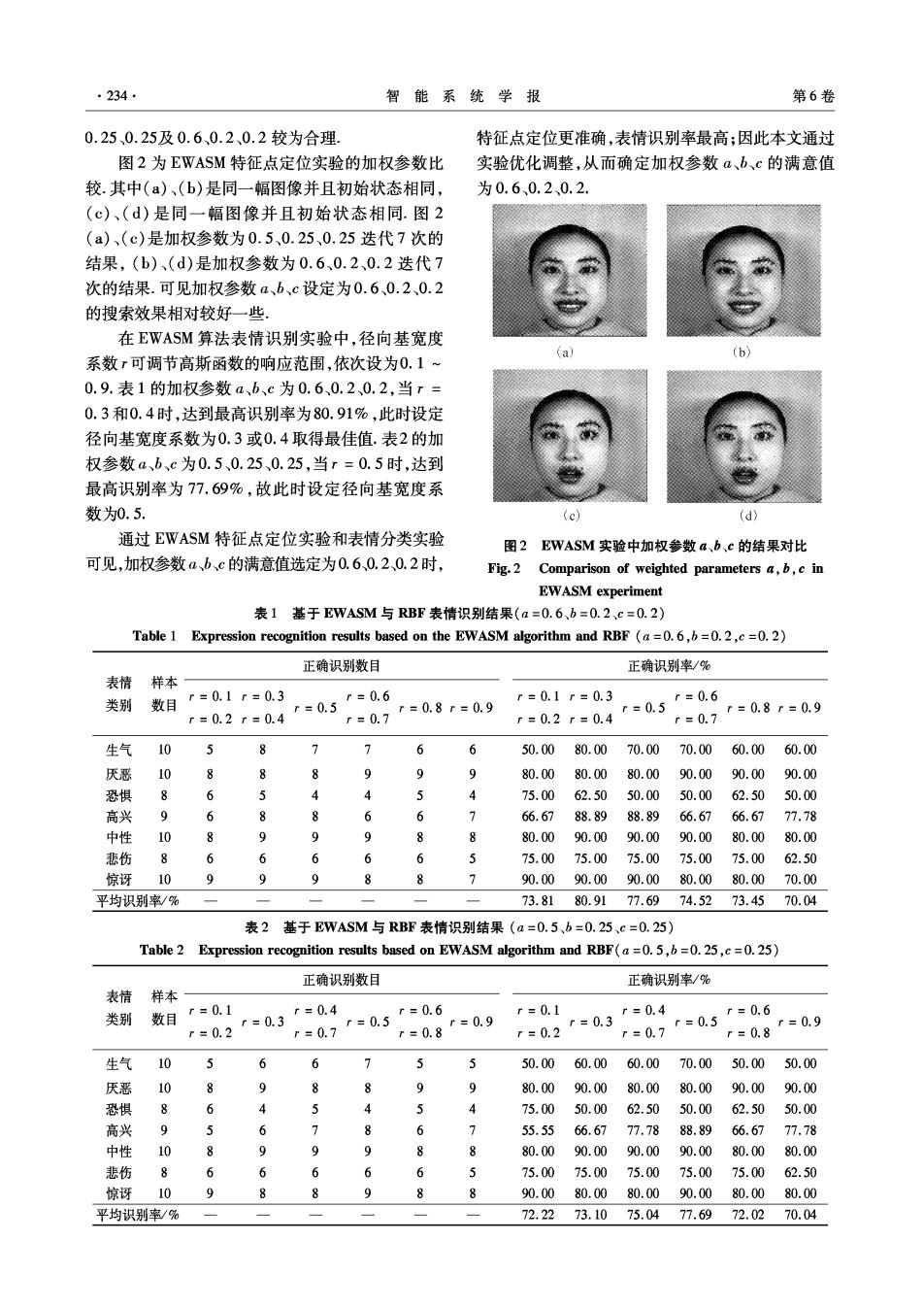

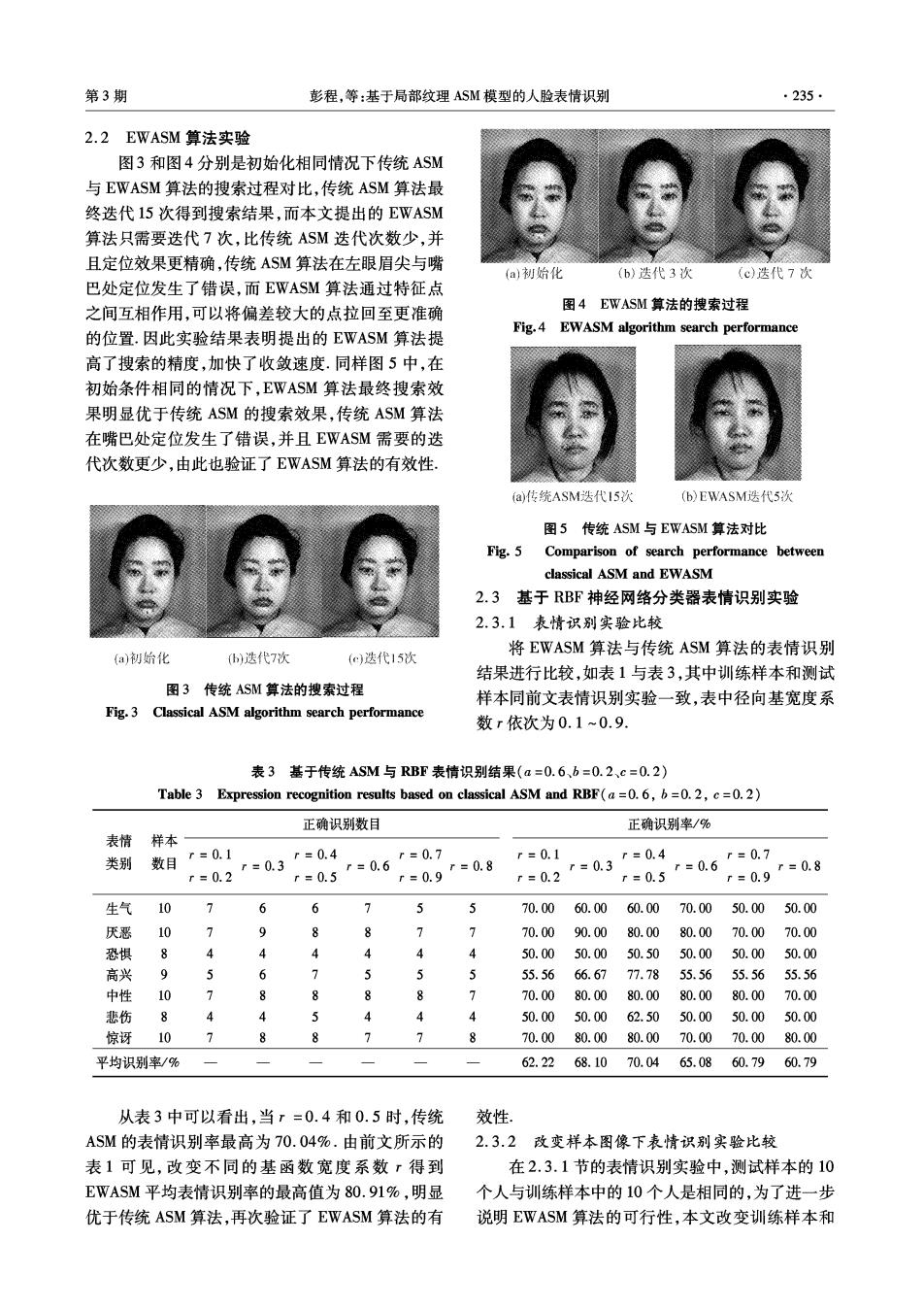

第3期 彭程,等:基于局部纹理ASM模型的人脸表情识别 ·235· 2.2 EWASM算法实验 图3和图4分别是初始化相同情况下传统ASM 与EWASM算法的搜索过程对比,传统ASM算法最 终迭代15次得到搜索结果,而本文提出的EWASM 算法只需要迭代7次,比传统ASM迭代次数少,并 且定位效果更精确,传统ASM算法在左眼眉尖与嘴 (a)初始化 (b)迭代3次 (c)迭代7次 巴处定位发生了错误,而EWASM算法通过特征点 之间互相作用,可以将偏差较大的点拉回至更准确 图4 EWASM算法的搜索过程 Fig.4 EWASM algorithm search performance 的位置.因此实验结果表明提出的EWASM算法提 高了搜索的精度,加快了收敛速度.同样图5中,在 初始条件相同的情况下,EWASM算法最终搜索效 果明显优于传统ASM的搜索效果,传统ASM算法 在嘴巴处定位发生了错误,并且EWASM需要的迭 代次数更少,由此也验证了EWASM算法的有效性 (a传统ASM迭代I5次 (b)EWASM.迭代5次 图5传统ASM与EWASM算法对比 Fig.5 Comparison of search performance between classical ASM and EWASM 2.3基于RBF神经网络分类器表情识别实验 2.3.1表情识别实验比较 将EWASM算法与传统ASM算法的表情识别 (a)初始化 b)迭代7次 ()迭代15次 结果进行比较,如表1与表3,其中训练样本和测试 图3传统ASM算法的搜索过程 样本同前文表情识别实验一致,表中径向基宽度系 Fig.3 Classical ASM algorithm search performance 数r依次为0.1~0.9 表3基于传统ASM与RBF表情识别结果(a=0.6、b=0.2、c=0.2) Table 3 Expression recognition results based on classical ASM and RBF(a=0.6,b=0.2,c=0.2) 正确识别数目 正确识别率/% 表情 样本 类别 数目r=0.1 =0.3r=0.4 r=0.7 r=0.1 r=0.6 r=0.8 r=0.4 r=0.8 r=0.2 r=0.5 r=0.9 r=0.2 r=0.3 r=0.5 rs0.6r=0.7 r=0.9 生气10 7 6 6 5 5 70.00 60.0060.0070.00 50.00 50.00 厌恶10 > 9 & e > 70.0090.0080.00 80.0070.0070.00 恐惧 8 4 50.0050.0050.5050.0050.00 50.00 高兴 9 5 6 7 5 5 5 55.56 66.6777.78 55.5655.56 55.56 中性 10 7 8 8 8 8 70.00 80.00 80.0080.00 80.00 70.00 悲伤 4 4 5 4 4 4 50.0050.00 62.5050.0050.00 50.00 惊讶 10 > 8 8 70.0080.0080.0070.0070.0080.00 平均识别率/% 62.2268.1070.0465.0860.7960.79 从表3中可以看出,当r=0.4和0.5时,传统 效性 ASM的表情识别率最高为70.04%.由前文所示的 2.3.2改变样本图像下表情识别实验比较 表1可见,改变不同的基函数宽度系数r得到 在2.3.1节的表情识别实验中,测试样本的10 EWASM平均表情识别率的最高值为80.91%,明显 个人与训练样本中的10个人是相同的,为了进一步 优于传统ASM算法,再次验证了EWASM算法的有 说明EWASM算法的可行性,本文改变训练样本和