举例 ■对每类构造k个最有区别能力的term ■例如: ·计算机领域: ·主机、芯片、内存、编译… ·汽车领域: ·轮胎,方向盘,底盘,气缸

举例 对每类构造k 个最有区别能力的term 例如: 计算机领域: 主机、芯片、内存、编译 … 汽车领域: 轮胎,方向盘,底盘,气缸,…

文本表示 向量空间模型(Vector Space Model)) ·M个无序标引项t(特征) ■词根/词/短语/其他 ·每个文档d可以用标引项向量来表示 .(aya2y…,am ·权重计算,N个训练文档 -AM+N=(a) ·相似度比较 Cosine计算 ·内积计算

文本表示 向量空间模型(Vector Space Model) M个无序标引项ti(特征) 词根/词/短语/其他 每个文档dj可以用标引项向量来表示 (a1j,a2j,…,amj) 权重计算,N个训练文档 AM*N= (aij) 相似度比较 Cosine计算 内积计算

Term的粒度 ■字(Character):中 ■词(Word):中国 ·短语(Phrase):中国人民银行 。7 概念(Concept): ■同义词:开心/高兴兴奋 ·相关词词簇(word cluster):葛非/顾俊 "N-gram(N元组): ·中国/国人/人民/民银/银行 ■某种规律性模式:比如某个window中出现的固定模式 David Lewis等一致地认为:(英文分类中)使用优化合 并后的Words比较合适

Term的粒度 字(Character):中 词(Word):中国 短语(Phrase):中国人民银行 概念(Concept): 同义词:开心/高兴/兴奋 相关词词簇(word cluster):葛非/顾俊 N-gram(N元组): 中国/国人/人民/民银/银行 某种规律性模式:比如某个window中出现的固定模式 David Lewis等一致地认为:(英文分类中)使用优化合 并后的 Words比较合适

用文档频率选特征 词频 TF (Term Frequency) ·TF:特征在文档冲出现次数 ■文档频率 DF Document Frequency) ■DFi:所有文档集合中出现特征的文档数目 ■基本假设:稀少的词或者对于目录预测没有帮助,或 者不会影响整体性能。 实现方法:,先计算所有词的DF,然后删除所有DF小于 某个阈值的词,从而降低特征空间的维数。 ■优缺点: 。最简单的降低特征空间维数的方法 ·稀少的词具有更多的信息,因此不宜用DF大幅度地删除词

用文档频率选特征 词频 TF (Term Frequency) TFi,j:特征 i在文档j中出现次数 文档频率 DF (Document Frequency) DFi:所有文档集合中出现特征 i的文档数目 基本假设:稀少的词或者对于目录预测没有帮助,或 者不会影响整体性能。 实现方法:先计算所有词的DF,然后删除所有DF小于 某个阈值的词,从而降低特征空间的维数。 优缺点: 最简单的降低特征空间维数的方法 稀少的词具有更多的信息,因此不宜用DF大幅度地删除词

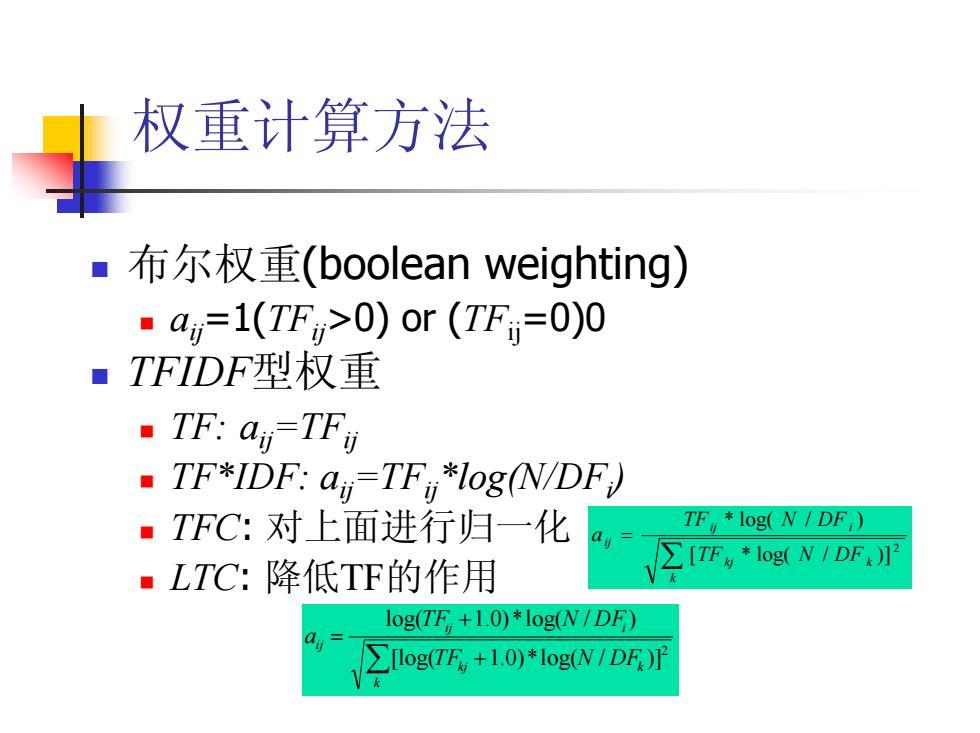

权重计算方法 布尔权重(boolean weighting) ·a=1(TFm>0)or(TF=0)0 ■TFIDF型权重 TF:an=TFy TF*IDF:ai=TFlog(N/DF) ·TFC:对上面进行归一化 TF,*log(N/DF,)》 ■LTC:降低TF的作用 ∑[TF4*log(NIDF log(TF,+1.0)*log(N/DF) 0 √∑log(TF,+1.0)*IogN/DE

权重计算方法 布尔权重(boolean weighting) aij=1(TFij>0) or (TFij=0)0 TFIDF型权重 TF: aij=TFij TF*IDF: aij=TFij*log(N/DFi ) TFC: 对上面进行归一化 LTC: 降低TF的作用 ∑ = k kj k ij i ij TF N DF TF N DF a 2 [ * log( / )] * log( / ) ∑ + + = k kj k ij i ij TF N DF TF N DF a 2 [log( 1.0 ) *log( / )] log( 1.0 ) *log( / )