从图2-可以得出,如果二元信源的输出符号是确定的,即p=1或q=1 时,则H()=0,说明该信源不提供任何信息量。若二元信源符号0和1以 等概率发生,即p=q=0.5时,则该信源熵达到最大值,H)=1bit/符号。 对任一有限离散值的集合而言,其熵是一有界函数,即0≤H(X)≤1ogM M是可能的离散取值的个数。 熵H)是随机变量x的不确定性的测度,如果增加一个随机变量y,那么 如何度量在观测到y之后x的不确定性呢?这需要定义给定y情况下x的条件 熵。 在给定条件下,的条件自信息量为(x,y),X集合的条件信息熵为: H(XIy,)=>p(x,Iy)I(x,Iy 进一步,在给定各个,即Y的条件下,X集合的条件信息熵为: H(XIY)=∑Py,HXIy,) =∑P(y)p(xly,I(xly,) ∑pxy,I(xIy) 条件熵H(XY)表示已知Y后,X的不确定性。 在给定X的条件下,Y集合的条件信息熵定义为: H(YIX)=∑P(xy,)y,lx)

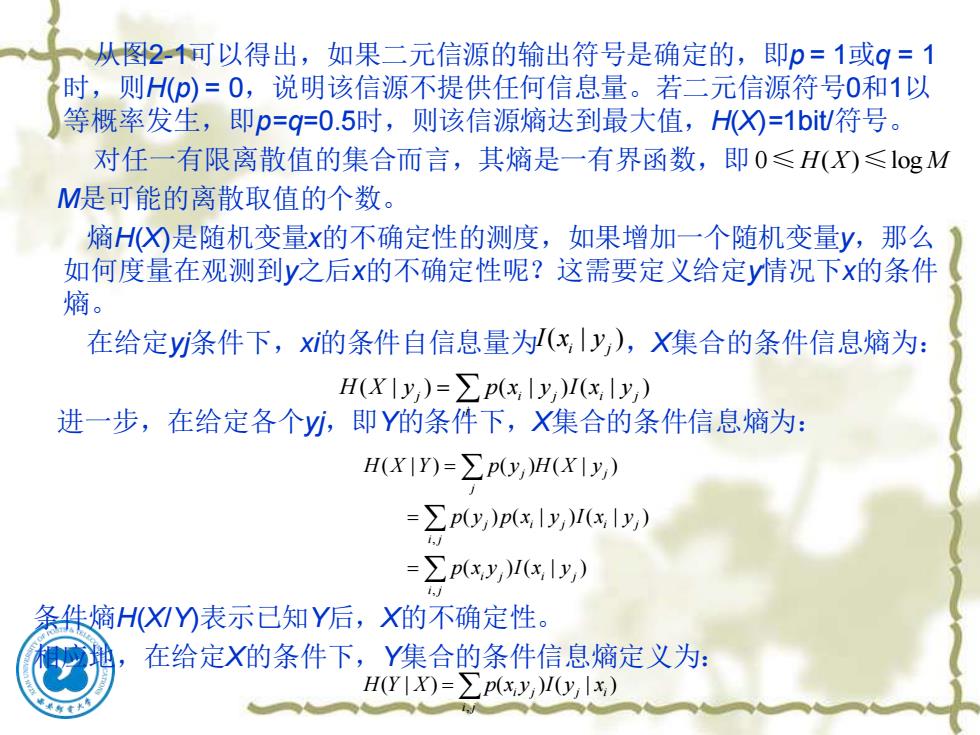

从图2-1可以得出,如果二元信源的输出符号是确定的,即p = 1或q = 1 时,则H(p) = 0,说明该信源不提供任何信息量。若二元信源符号0和1以 等概率发生,即p=q=0.5时,则该信源熵达到最大值,H(X)=1bit/符号。 对任一有限离散值的集合而言,其熵是一有界函数,即 M是可能的离散取值的个数。 熵H(X)是随机变量x的不确定性的测度,如果增加一个随机变量y,那么 如何度量在观测到y之后x的不确定性呢?这需要定义给定y情况下x的条件 熵。 在给定yj条件下,xi的条件自信息量为 ,X集合的条件信息熵为: 进一步,在给定各个yj,即Y的条件下,X集合的条件信息熵为: 条件熵H(X/Y)表示已知Y后,X的不确定性。 相应地,在给定X的条件下,Y集合的条件信息熵定义为: 0 ( ) log ≤H X M ≤ ( | ) i j I x y ( | ) ( | ) ( | ) j i j i j i H X y p x y I x y = , , ( | ) ( ) ( | ) ( ) ( | ) ( | ) ( ) ( | ) j j j j i j i j i j i j i j i j H X Y p y H X y p y p x y I x y p x y I x y = = = , ( | ) ( ) ( | ) i j j i i j H Y X p x y I y x =

定义联合信息熵为: H(XY)=∑pxy,)I(xy,) -∑pxy,)log p(x,y) i,i HXY)表示了联合概率分布所具有的信息量的概率平均值,即X和Y同时发 生的不确定性。联合信息熵与各条件信息熵的关系式为: H(XY)=H(X)+H(YX) =H(Y)+H(X Y)

定义联合信息熵为: H(XY)表示了联合概率分布所具有的信息量的概率平均值,即X和Y同时发 生的不确定性。联合信息熵与各条件信息熵的关系式为: , , ( ) ( ) ( ) ( )log ( ) i j i j i j i j i j i j H XY p x y I x y p x y p x y = = − ( ) ( ) ( | ) ( ) ( | ) H XY H X H Y X H Y H X Y = + = +

2.2.3互信息量 假设X为信源发出的离散消息符号的集合,X的各消息符号的先验概率 己知为p():Y为信宿收到的离散消息符号的集合。信宿收到一个消息符 号后计算出信源各消息符号的条件概率为P(x,1,)(即后验概率),则互 信息量定义为: I(x,;y)=log p(xly,) p(x,) 由于无法确漫(,少)和()的大小关系,所以I(x;y,)不一定大于或等于0, 有可能小于0。 对互信息量在X集合上取统计平均值,得(Xy,)=∑(xy)xy,) =∑pxly,)log p() IX;Y)=∑p0yx,y) 再对在Y集合上的概率加权统计平均,有 =∑py,)pxly,)log p(x) p(x,) =∑Ppxy)lo pxly) p(x) 此X,Y)称为平均互信息量(熵)

2.2.3 互信息量 假设X为信源发出的离散消息符号的集合,X的各消息符号的先验概率 已知为p(xi);Y为信宿收到的离散消息符号的集合。信宿收到一个消息符 号yj后计算出信源各消息符号的条件概率为 (即后验概率),则互 信息量定义为: 由于无法确定 和p(xi)的大小关系,所以 不一定大于或等于0, 有可能小于0。 对互信息量在X集合上取统计平均值,得 再对在Y集合上的概率加权统计平均,有 此I(X;Y)称为平均互信息量(熵)。 ( | ) ( ; ) log ( ) i j i j i p x y I x y p x = ( | ) p x y i j ( | ) i j p x y ( ; ) i j I x y ( ; ) ( | ) ( ; ) ( | ) ( | )log ( ) j i j i j i i j i j i i I X y p x y I x y p x y p x y p x = = , , ( ; ) ( ) ( ; ) ( | ) ( ) ( | )log ( ) ( | ) ( )log ( ) j j j i j j i j i j i i j i j i j i I X Y p y I X y p x y p y p x y p x p x y p x y p x = = =

在通信系统中,若发送端的消息符号为X,接收端的消息符号为Y, 测平均互信息量X,)就是在接收端收到消息符号Y后所能获得的关于 发送的消息符号X的平均信息量,反之亦然。且X;Y)是非负的。注意 平均互信息量X;)与联合信息熵HX)的区别。 由以上的结果,可得出下面的性质: I(X;Y)=H(X)-H(X Y) =H(Y)-H(YX) =I(Y;X) =H(X)+H(Y)-H(XY) 这几个关系式说明:平均互信息量对X与Y呈对称性;联合信息熵 与平均互信息量之和等于X与的熵之和。这些关系可以用图来表示, 如图2-2所示。 H(X) H(XIY) H(YX) H(Y) I(X:Y) H(XY) 图2-2联合熵与条件熵的关系 两个圆分别为H)和H(y,交叠的部分为X;)。 关系式X;)=H)-HXY)说明了接收信号所提供的有关传输消息 的平均信息量等于确定消息X所需的平均信息量减去接收Y信号后要 达到此目的尚需要的平均信息量

❖ 在通信系统中,若发送端的消息符号为X,接收端的消息符号为Y, 则平均互信息量I(X;Y)就是在接收端收到消息符号Y后所能获得的关于 发送的消息符号X的平均信息量,反之亦然。且I(X;Y)是非负的。注意 平均互信息量I(X;Y)与联合信息熵H(XY)的区别。 由以上的结果,可得出下面的性质: 这几个关系式说明:平均互信息量对X与Y呈对称性;联合信息熵 与平均互信息量之和等于X与Y的熵之和。这些关系可以用图来表示, 如图2-2所示。 图2-2 联合熵与条件熵的关系 两个圆分别为H(X)和H(Y),交叠的部分为I(X;Y)。 关系式I(X;Y)=H(X) − H(X|Y)说明了接收信号所提供的有关传输消息 的平均信息量等于确定消息X所需的平均信息量减去接收Y信号后要 达到此目的尚需要的平均信息量。 ( ; ) ( ) ( | ) ( ) ( | ) ( ; ) ( ) ( ) ( ) I X Y H X H X Y H Y H Y X I Y X H X H Y H XY = − = − = = + −

可以把熵当作发出的平均信息量,把X;Y)作为接收Y后所提供的有关 发出消息X的平均信息量,把条件熵HXY)看作是由于信道噪声而损失的 平均信息量。条件熵HX)也称为可疑度或疑义度。 而关系式X,)=H()-H(Y)也可看做所接收的平均信息量,它是确 定接收到信号需要的平均信息量减去当发出的消息为已知时,欲确定同 接收到信号所需的平均信息量。 因此,H(Y)是确定信道中出现某种干扰时需要的平均信息量,称为 信道噪声的熵;或者说,H(Y)代表Y集合中由于噪声所产生的那部分熵。 噪声熵也称为散布度 如果X与Y是相互独立的,则Y已知时,X的条件概率就等于无条件概率, 那么X的条件熵就等于X的无条件熵。此时,X,=0,说明由于X与Y相 互独立,无法从Y中提取有关X的信息量,可以看做信道中的噪声相当大, 能传输的平均信息量为零,由信源发出的信息量在信道上全部损失掉了, 这种信道称为全损离散信道。 如果输出Y是输入X的确定的、 一一 对应的函数,则Y已知时X的条件概 率不是“1”就是“0”,此时:X;Y)=HX),由Y所获得的信息量就是X的 不确定性或熵。这种情况下,信道不损失信息量,噪声熵为0。这种信道 称为无扰离散信道,有X;)=H)=H(Y)这是两种特殊的情况

可以把熵当作发出的平均信息量,把I(X;Y)作为接收Y后所提供的有关 发出消息X的平均信息量,把条件熵H(X|Y)看作是由于信道噪声而损失的 平均信息量。条件熵H(X|Y)也称为可疑度或疑义度。 而关系式I(X;Y)=H(Y) − H(Y|X)也可看做所接收的平均信息量,它是确 定接收到信号需要的平均信息量减去当发出的消息为已知时,欲确定同 一接收到信号所需的平均信息量。 因此,H(Y|X)是确定信道中出现某种干扰时需要的平均信息量,称为 信道噪声的熵;或者说,H(Y|X)代表Y集合中由于噪声所产生的那部分熵。 噪声熵也称为散布度。 如果X与Y是相互独立的,则Y已知时,X的条件概率就等于无条件概率, 那么X的条件熵就等于X的无条件熵。此时,I(X;Y)=0,说明由于X与Y相 互独立,无法从Y中提取有关X的信息量,可以看做信道中的噪声相当大, 能传输的平均信息量为零,由信源发出的信息量在信道上全部损失掉了, 这种信道称为全损离散信道。 如果输出Y是输入X的确定的、一一对应的函数,则Y已知时X的条件概 率不是“1”就是“0”,此时:I(X;Y)=H(X),由Y所获得的信息量就是X的 不确定性或熵。这种情况下,信道不损失信息量,噪声熵为0。这种信道 称为无扰离散信道,有 I(X;Y)=H(X)=H(Y)这是两种特殊的情况