第二章信源与信息熵 2.1信源的数学模型及分类 。2.2离散信源熵和互信息 2.3信息熵的性质 。2.4离散序列信源熵 ·2.5连续信源熵与互信息 ÷2.6信源的冗余度

第二章 信源与信息熵 ❖ 2.1 信源的数学模型及分类 ❖ 2.2 离散信源熵和互信息 ❖ 2.3 信息熵的性质 ❖ 2.4 离散序列信源熵 ❖ 2.5 连续信源熵与互信息 ❖ 2.6 信源的冗余度

2.1 信源的数学模型及分类 。信源分类 连续信源 信源 离散无记忆信源 离散信源 离散有记忆信源 离散无记忆信源:包括发出单个符号的无记忆信源 和发出符号序列的无记忆信源两种。 离散有记忆信源:包括发出符号序列的有记忆信源 和发出符号序列的马尔可夫信源两种

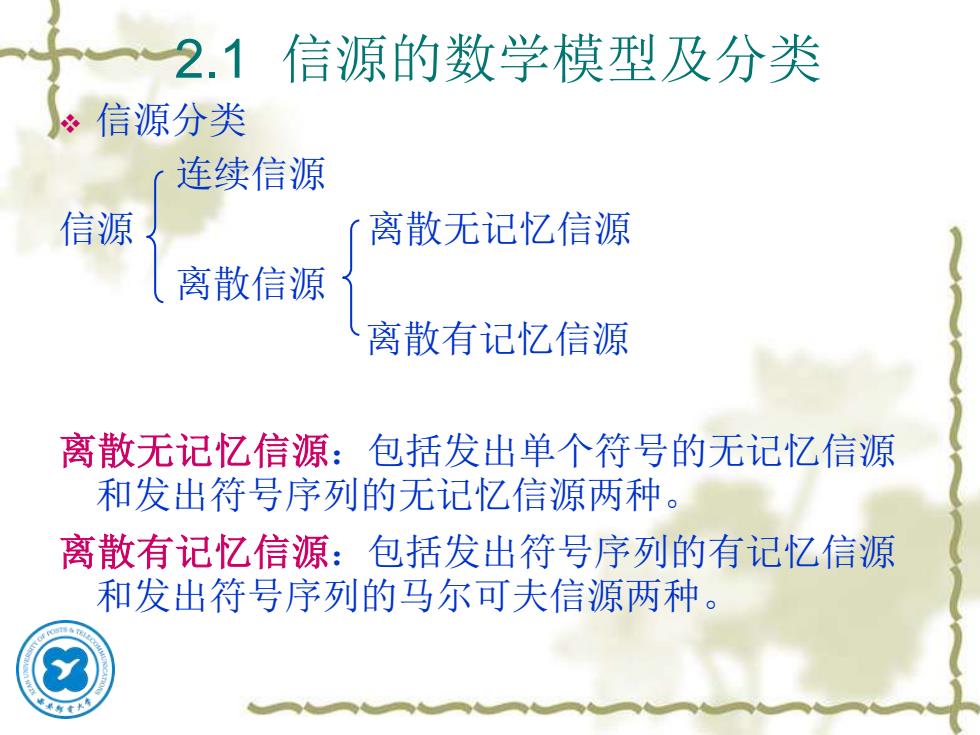

2.1 信源的数学模型及分类 ❖ 信源分类 连续信源 信源 离散无记忆信源 离散信源 离散有记忆信源 离散无记忆信源:包括发出单个符号的无记忆信源 和发出符号序列的无记忆信源两种。 离散有记忆信源:包括发出符号序列的有记忆信源 和发出符号序列的马尔可夫信源两种

假定某一离散信源发出的各个符号消息的集合为: X={x1,x2,.,Xn} 各个符号的先验概率为: P={p(x),p(x2),.,p(xn)} 通常将它们写在一起: 称为概率空间,其中 p(x)≥20 p(x,)=1 i=1 最简单的有记忆信源是=2的情况,此时信源为:仁Ⅺ2,其概率空间为: xx XX2 . XnXn p(xx)p(xx2). p(xx) 对于无记忆信源来说,其联合概率为:p.x)=px)p(x).px,) 若其满足平稳性: p(xx2.xn)=p(x)px2).pxn)=p

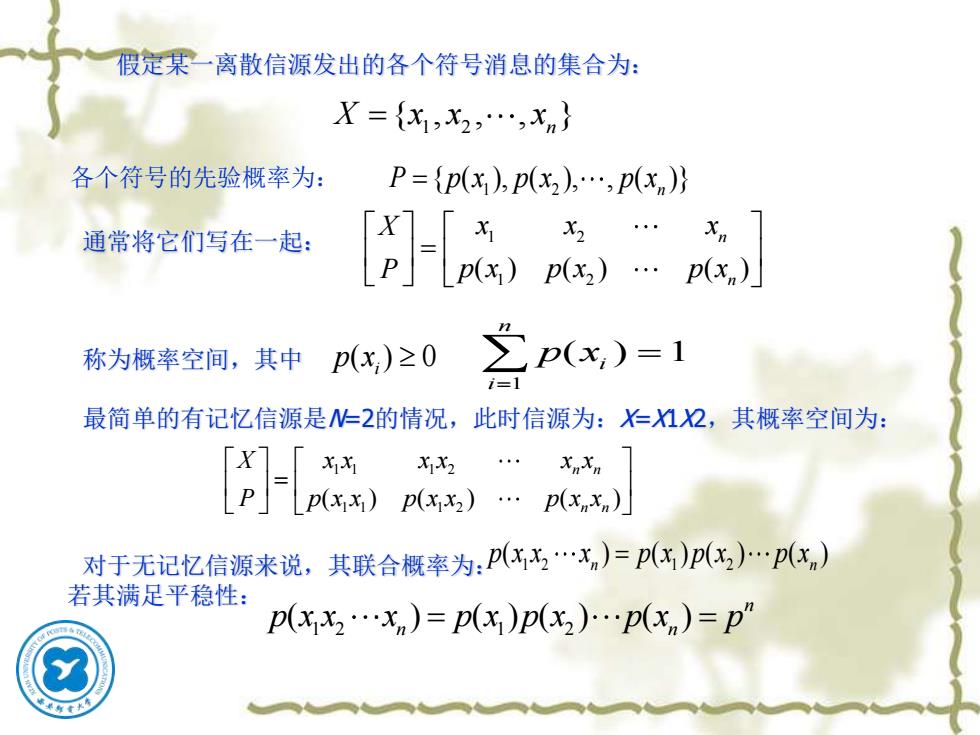

各个符号的先验概率为: 1 2 { , , , } X x x x = n 假定某一离散信源发出的各个符号消息的集合为: 1 2 { ( ), ( ), , ( )} P p x p x p x = n 通常将它们写在一起: 称为概率空间,其中 最简单的有记忆信源是N=2的情况,此时信源为:X=X1X2,其概率空间为: 对于无记忆信源来说,其联合概率为: 若其满足平稳性: 1 2 1 2 ( ) ( ) ( ) n n X x x x P p x p x p x = ( ) 0 i p x 1 ( ) 1 n i i p x = = 1 1 1 2 1 1 1 2 ( ) ( ) ( ) n n n n X x x x x x x P p x x p x x p x x = 1 2 1 2 ( ) ( ) ( ) ( ) n n p x x x p x p x p x = 1 2 1 2 ( ) ( ) ( ) ( ) n n n p x x x p x p x p x p = =

更一般情况:随机波形信源 ÷实际信源输出的消息常常是时间和取值都是连续 的。这类信源称为随机波形信源。 ÷随机波形信源在某一固定时间o的可能取值是连 续和随机的。对于这种信源输出的消息,可用随 机过程来描述。 ÷例:语音信号X()、热噪声信号n(①)、电视图像信 号X(r(),g(①),b()等时间连续函数

更一般情况:随机波形信源 ❖ 实际信源输出的消息常常是时间和取值都是连续 的。这类信源称为随机波形信源。 ❖ 随机波形信源在某一固定时间 t0 的可能取值是连 续和随机的。对于这种信源输出的消息,可用随 机过程来描述。 ❖ 例:语音信号X(t)、热噪声信号n(t)、电视图像信 号X(r(t),g(t),b(t))等时间连续函数

2.2离散信源熵和互信息 2.2.1信息量 在一切有意义的通信中,虽然消息的传递意味着信息的传递,但对于接收 者来说,某些消息比另外一些消息却含有更多的信息。消息中的信息量与消 息发生的概率紧密相关,消息出现的概率越小,则消息中包含的信息量就越 大。 为了计算信息量,消息中所含信息量与消息出现的概率(X间的关系式应 当反映如下规律: ①消息中所含信息量偍出现该消息的概率p(X的函数,即I=I[p(x)] ②消息出现的概率越小,它所含的信息量越大;消息出现的概率越大,它所含 的信息量越小;且当p(X)=1时,/=0。 ③若干个互相独立的事件构成的消息,其所含信息量等于各独立事件的信息量 之和,即[p(x)p(x2)=[px】+Lpx】+. 不难看出,若与p(X)之间的关系式为: 满足上述要求。 I=loga p(x) =-loga p(x)

2.2 离散信源熵和互信息 2.2.1 信息量 在一切有意义的通信中,虽然消息的传递意味着信息的传递,但对于接收 者来说,某些消息比另外一些消息却含有更多的信息。消息中的信息量与消 息发生的概率紧密相关,消息出现的概率越小,则消息中包含的信息量就越 大。 为了计算信息量,消息中所含信息量I与消息出现的概率p(x)间的关系式应 当反映如下规律: ① 消息中所含信息量I是出现该消息的概率p(x)的函数,即 ② 消息出现的概率越小,它所含的信息量越大;消息出现的概率越大,它所含 的信息量越小;且当p(x) = 1时,I = 0。 ③ 若干个互相独立的事件构成的消息,其所含信息量等于各独立事件的信息量 之和,即 不难看出,若I与p(x)之间的关系式为: 就可满足上述要求。 I I p x = [ ( )] 1 2 1 2 I p x p x I p x I p x [ ( ) ( ) ] [ ( )] [ ( )] = + + 1 log log ( ) ( ) a a I p x p x = = −