前面定义的自信息量(x)是表征信源中各个符号的不确定性。由于信源 中各个符号的概率分布(先验概率)不同,因而各个符号的自信息量就不 相同,所以,自信息量不能作为信源总体的信息量。而平均信息量H)或 信源熵H()是从平均意义上来表征信源的总体特征,因此可以表征信源的 平均不确定性。 定义信源的平均不确定性H)为信源中各个符号不确定性的数学期望, 即H(X)=EI(x=∑p(x)(x)=-∑p(x)log2p(x),称作信息熵,简称熵。 由于X)是非负值的量,所以熵H)也是非负值的,只有在p(X)=0和 p(X)=1时,熵H)才为零p(X)=0时,规定0IOg0=0,其合理性由极限 lim xlogx=0得证]。 x01 例题2-3一幅500×600的图像,每个像素的灰度等级为10, 若为均匀分布,计算平均每幅图像能提供的信息量。 解:能够组成的图像有n=1030,有 H(X)=-p(x,)log.P(x,)=-log,10-)=9.9x105 (bit/图像)

前面定义的自信息量I(xi)是表征信源中各个符号的不确定性。由于信源 中各个符号的概率分布(先验概率)不同,因而各个符号的自信息量就不 相同,所以,自信息量不能作为信源总体的信息量。而平均信息量H(X)或 信源熵H(X)是从平均意义上来表征信源的总体特征,因此可以表征信源的 平均不确定性。 定义信源的平均不确定性H(X)为信源中各个符号不确定性的数学期望, 即 ,称作信息熵,简称熵。 由于I(X)是非负值的量,所以熵H(X)也是非负值的,只有在p(x) = 0和 p(x) = 1时,熵H(X)才为零[p(x) = 0时,规定0log0 = 0,其合理性由极限 得证]。 ❖ 例题2-3 一幅500×600的图像,每个像素的灰度等级为10, 若为均匀分布,计算平均每幅图像能提供的信息量。 解 :能够组成的图像有 ,有 (bit/图像) 2 ( ) [ ( )] ( ) ( ) ( )log ( ) i i i i i i H X E I x p x I x p x p x = = = − 0 lim log 0 x x x → + = 5 3 10 n 10 = 5 (3 10 ) 5 2 2 1 ( ) ( )log ( ) log 10 9.96 10 n i i i H X p x p x − = = − = − =

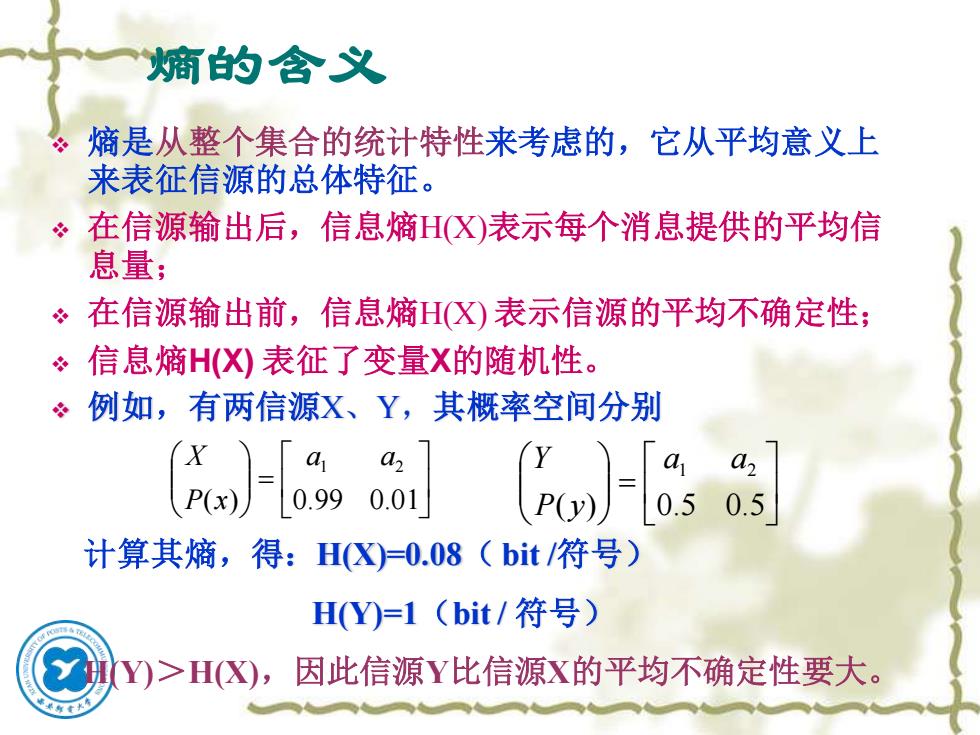

熵的含义 熵是从整个集合的统计特性来考虑的,它从平均意义上 来表征信源的总体特征。 在信源输出后,信息熵H(X)表示每个消息提供的平均信 息量; 。在信源输出前,信息熵HX)表示信源的平均不确定性; 信息熵H(X)表征了变量X的随机性。 例如,有两信源X、Y,其概率空间分别 a 2 P(y) 0.5 0.5 计算其熵,得:HX)=0.08(bit/符号) H(Y)=1(bit/符号) Y)>H(X),因此信源Y比信源X的平均不确定性要大

熵的含义 ❖ 熵是从整个集合的统计特性来考虑的,它从平均意义上 来表征信源的总体特征。 ❖ 在信源输出后,信息熵H(X)表示每个消息提供的平均信 息量; ❖ 在信源输出前,信息熵H(X) 表示信源的平均不确定性; ❖ 信息熵H(X) 表征了变量X的随机性。 ❖ 例如,有两信源X、Y,其概率空间分别 = ( ) 0.99 0.01 a1 a2 P x X = ( ) 0.5 0.5 a1 a2 P y Y 计算其熵,得:H(X)=0.08( bit /符号) H(Y)=1(bit / 符号) H(Y)>H(X),因此信源Y比信源X的平均不确定性要大

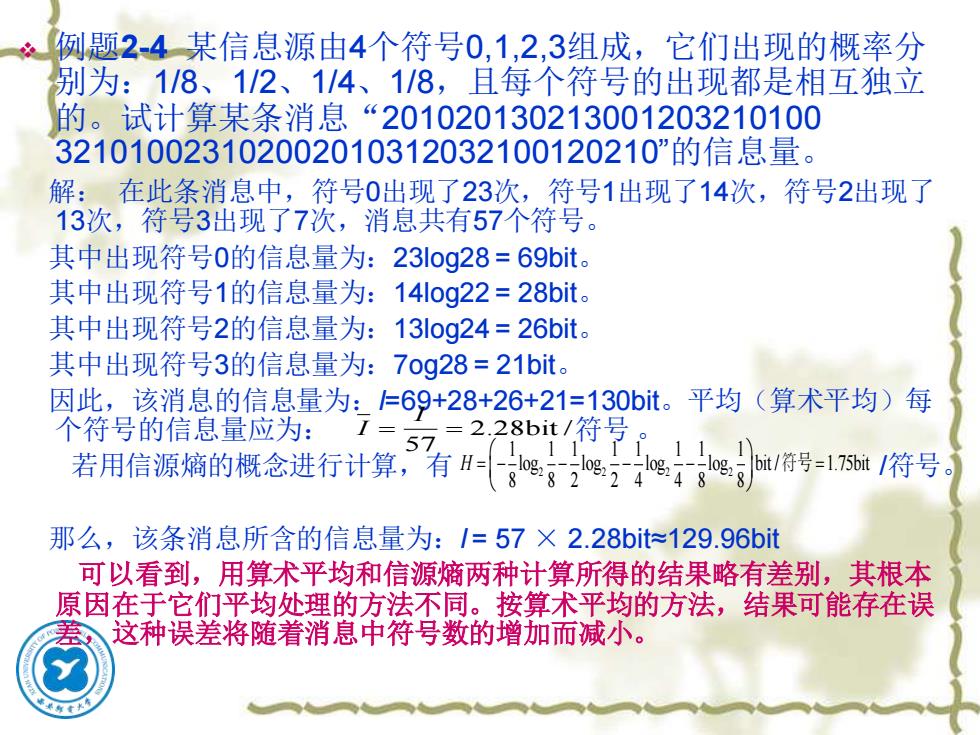

例题2-4某信息源由4个符号0,1,2,3组成,它们出现的概率分 别为:1/8、112、1/4、1/8,且每个符号的出现都是相互独立 的。试计算某条消息“201020130213001203210100 321010023102002010312032100120210"”的信息量。 解:在此条消息中,符号0出现了23次,符号1出现了14次,符号2出现了 13次,符号3出现了7次,消息共有57个符号。 其中出现符号0的信息量为:23log28=69bit。 其中出现符号1的信息量为:14log22=28bit。 其中出现符号2的信息量为:13log24=26bit。 其中出现符号3的信息量为:7og28=21bit。 因此,该消息的信息量为:=69+28+26+21=130bit。平均(算术平均)每 个符号的信息量应为: I= 57 228bit/符号 1 11 若用信源熵的概念进行计算,有H。g5248 bt/符号=175bt/符号 8 那么,该条消息所含的信息量为:/=57×2.28bit129.96bit 可以看到,用算术平均和信源熵两种计算所得的结果略有差别,其根本 原因在于它们平均处理的方法不同。按算术平均的方法,结果可能存在误 这种误差将随着消息中符号数的增加而减小

❖ 例题2-4 某信息源由4个符号0,1,2,3组成,它们出现的概率分 别为:1/8、1/2、1/4、1/8,且每个符号的出现都是相互独立 的。试计算某条消息“201020130213001203210100 321010023102002010312032100120210”的信息量。 解: 在此条消息中,符号0出现了23次,符号1出现了14次,符号2出现了 13次,符号3出现了7次,消息共有57个符号。 其中出现符号0的信息量为:23log28 = 69bit。 其中出现符号1的信息量为:14log22 = 28bit。 其中出现符号2的信息量为:13log24 = 26bit。 其中出现符号3的信息量为:7og28 = 21bit。 因此,该消息的信息量为:I=69+28+26+21=130bit。平均(算术平均)每 个符号的信息量应为: 符号 。 若用信源熵的概念进行计算,有 /符号。 那么,该条消息所含的信息量为:I = 57 × 2.28bit≈129.96bit 可以看到,用算术平均和信源熵两种计算所得的结果略有差别,其根本 原因在于它们平均处理的方法不同。按算术平均的方法,结果可能存在误 差,这种误差将随着消息中符号数的增加而减小。 2.28bit / 57 I I = = 2 2 2 2 1 1 1 1 1 1 1 1 log log log log bit / 1.75bit 8 8 2 2 4 4 8 8 H = − − − − = 符号

例题2-5一个由字母A、B、C、D组成的字, 对于传输的 每一个字母用二进制脉冲编码,A:00,B:01,C:10,D:11, 每个脉冲的宽度为5ms。 (1)若每个字母是等概率出现时,计算传输的平均信息速率。 (2)若每个字母出现的概率分别为:pA=0.2,pB=0.25,pC=0.25, pD=0.3,计算传输的平均信息速率。 解:信息传输速率也称为信息速率或传信率,它被定义为每秒传递的信 息量,单位是比特/秒,记为b刊s,它是衡量通信系统的一个主要性能 指标。 (1)各字母等概率出现时,平均每个符号所含的信息量为 H0)=-4x}84 =2bit/符号 4 传输一个符号需要10ms,因此,每秒钟可传100个符号。所以,信 息速率为R,=2×100=200bit/s (2)同理,各字母不等概率出现时,平均每个符号所含的信息量为 H(X)=-∑p,l1og,p,=1.985bit/符号 速率为:R=198.5bit/s

❖ 例题2-5 一个由字母A、B、C、D组成的字,对于传输的 每一个字母用二进制脉冲编码,A:00,B:01,C:10,D:11, 每个脉冲的宽度为5ms。 (1)若每个字母是等概率出现时,计算传输的平均信息速率。 (2)若每个字母出现的概率分别为:pA = 0.2,pB = 0.25,pC = 0.25, pD = 0.3,计算传输的平均信息速率。 解:信息传输速率也称为信息速率或传信率,它被定义为每秒传递的信 息量,单位是比特/秒,记为bit/s,它是衡量通信系统的一个主要性能 指标。 (1)各字母等概率出现时,平均每个符号所含的信息量为 传输一个符号需要10ms,因此,每秒钟可传100个符号。所以,信 息速率为 (2)同理,各字母不等概率出现时,平均每个符号所含的信息量为 信息速率为: 。 2 1 1 ( ) 4 log 2bit / 4 4 H X = − = 符号 b R = = 2 100 200bit / s 4 2 1 ( ) log 1.985bit / i i i H X p p = = − = 符号 b R =198.5bit / s

对于二元离散信源X,其输出的符号只有0和1两个,发生的概率分 别为p和q,且p+qF1,该信源的概率空间为: [[8 该二元信源的熵为: H(X)=-plogp-glogq =-plog p-(1-p)log(1-p) =H(p) 由于p的取值区间为O≤p≤,1给定p的值,做出H(pP)~p的变化曲线, 如图2-1所示。 H(p) 0.5 图2-1H(p)~p曲线

对于二元离散信源X,其输出的符号只有0和1两个,发生的概率分 别为p和q,且p+q=1,该信源的概率空间为: 该二元信源的熵为: 由于p的取值区间为 ,给定p的值,做出 的变化曲线, 如图2-1所示。 图2-1 H(p)~p曲线 X 0 1 P p q = ( ) log log log (1 )log(1 ) ( ) H X p p q q p p p p H p = − − = − − − − = 0 1 ≤ p≤ H p p ( ) ~