基于最小风险的贝叶斯决策 口条件期望损失:对于特定的观察样本x(特征向 量),决策口,造成的损失对x实际所属类别的 第二章贝叶斯决策理论 各种可能的平均,也叫做条件风险: R(a,Ix)=E[i(a.0,)] 2009.09.29 若ao,jPo,l 口期望风险:对所有x取值所作的决策a(x)所带 来的平均风险,即条件风险对x的数学期望。 R(a)=E[R(a(x)Ix)]=[R(a(x)Ix)p(x)dx 基于最小风险的贝叶斯决策 基于最小风险的贝叶斯决策 口目标:决策带来的损失的平均值一一(平均)风 口最小风险决策的计算步骤 险最小。 ■在已知P(o,pk|w山,i=l,,c,以及给定待识 口决策规则 别样本x的情况下,根据贝叶斯公式计算后验概 率: Decide a.if R(x)=min R(a) ■利用后验概率及决策表(或损失矩阵),算出每 个决策的条件风险(a,x); ■通过保证对于每个观测值下的条件风险最小,使 ■按照最小的条件风险进行决策。 得决策的数学期望一一平均风险最小。基于最小 ◆ 损失矩阵在某些特殊问题,存在简单的解 风险的贝叶斯决策是一致最优决策。 析表达式。 实际问题中得到合适的损失矩阵不容易, 基于最小风险的贝叶斯决策 基于最小风险的贝叶斯决策 口两类别问题 口两类别问题 ■定义(符号简化) ■决策规则 。行为a:deciding,: a,if(221-Ai)P(0lx)>(a2-22)P(o21x) Decide ·行为a2:deciding2; @otherwise ·损失=(c,0),i,j=1,2. 用贝叶斯公式展开 ■条件风险 if P(xl()P(o) R(aIx)=P(@Ix)+42P(@2Ix) Decide P|o2)(21-)P(@) R(a2|x)=21P(o1|x)+22P(o21x) otherwise

第二章 贝叶斯决策理论 2009.09.29 2 基于最小风险的贝叶斯决策 条件期望损失:对于特定的观察样本 x(特征向 量),决策 造成的损失对 x 实际所属类别的 各种可能的平均,也叫做条件风险: 期望风险:对所有 x 取值所作的决策α(x)所带 来的平均风险,即条件风险对 x 的数学期望。 i 1 ( |) ( , ) ( , )( | ) i ij c ij j j R E P x x R ER R p d ( ) [ ( ( ) | )] ( ( ) | ) ( ) xx xx xx 3 基于最小风险的贝叶斯决策 目标:决策带来的损失的平均值——(平均)风 险最小。 决策规则 通过保证对于每个观测值下的条件风险最小,使 得决策的数学期望——平均风险最小。基于最小 风险的贝叶斯决策是一致最优决策。 1, , , if ( | ) min ( | ) kk i j a Decide R R x x 4 基于最小风险的贝叶斯决策 最小风险决策的计算步骤 在已知P(ωi),p(x |ωi),i=1,…,c,以及给定待识 别样本 x 的情况下,根据贝叶斯公式计算后验概 率; 利用后验概率及决策表(或损失矩阵),算出每 个决策的条件风险 ; 按照最小的条件风险进行决策。 ( | ) R i x 5 基于最小风险的贝叶斯决策 两类别问题 定义(符号简化) 条件风险 1 1 2 2 ij j : deciding ; : deciding ; ( , ), , 1, 2. i i j 行为 行为 损失 1 11 1 12 2 2 21 1 22 2 ( |) ( |) ( |) ( |) ( |) ( |) R PP R PP xxx xxx 6 基于最小风险的贝叶斯决策 两类别问题 决策规则 用贝叶斯公式展开 1 21 11 1 12 22 2 2 , if ( ) ( | ) ( )( | ) Decide , otherwise P P x x 12 22 2 1 2 21 11 1 2 1 ( )() , if > Decide ( )() , otherwise (| ) ( | ) P P P P x x

基于最小风险的贝叶斯决策 基于最小风险的贝叶斯决策 口例解:两类细胞识别问题:正常类(ω,)和异常 口利用贝叶斯公式计算两类的后验概率: 类(ω) 0.9×0.2 =0.818 ■根据已有知识和经验,两类的先验概率为: P(@Ix)= 0.9×0.2+0.1×0.4 正常(o):P(w)=0.9 0.4×0.1 P(@x)= 异常(w):Po=0.1 02x0.9+0,4×0.=0.182 对某一样本观察值x,通过计算或查表得到: Ralx)=22,Po,lx)=e(o,)=1.092, po=0.2,pxw-0.4 入10,入26,入21=1,入20 Ra,l)=2,P@,)=ay=0.818 ■按最小风险决策如何对细胞x进行分类? .R(a Ix)>R(a Ix),.Decide az,xE 两种决策方法之间的关系 两种决策方法之间的关系 口基于最小错误率的Bayes决策可作为最小风险 口条件风险 Bayes决策的一种特殊情形。 口定义损失为 R(a,Ix)=>i(a:@,)P(@,Ix) =1 0,i=j,i,j=l,…c a,o,)-i,i≠j =P(o,1x)=1-P(@1) j=1,≠i ■不考虑"拒绝"等其他决策; 口决策规则 ■决策正确时没有损失;决策错误时损失为1;即 min R(a;Ix)max P(@,Ix) 0-1损失函数。 12 两种决策方法之间的关系 两种决策方法之间的关系 口图例一 口图例二 ■由0-1损失函数确定阅值0 ■给予假设入12>入21确定阁值6b。(R变小) 0。=Po2)/P(o) Po2,-) 0=P(o(

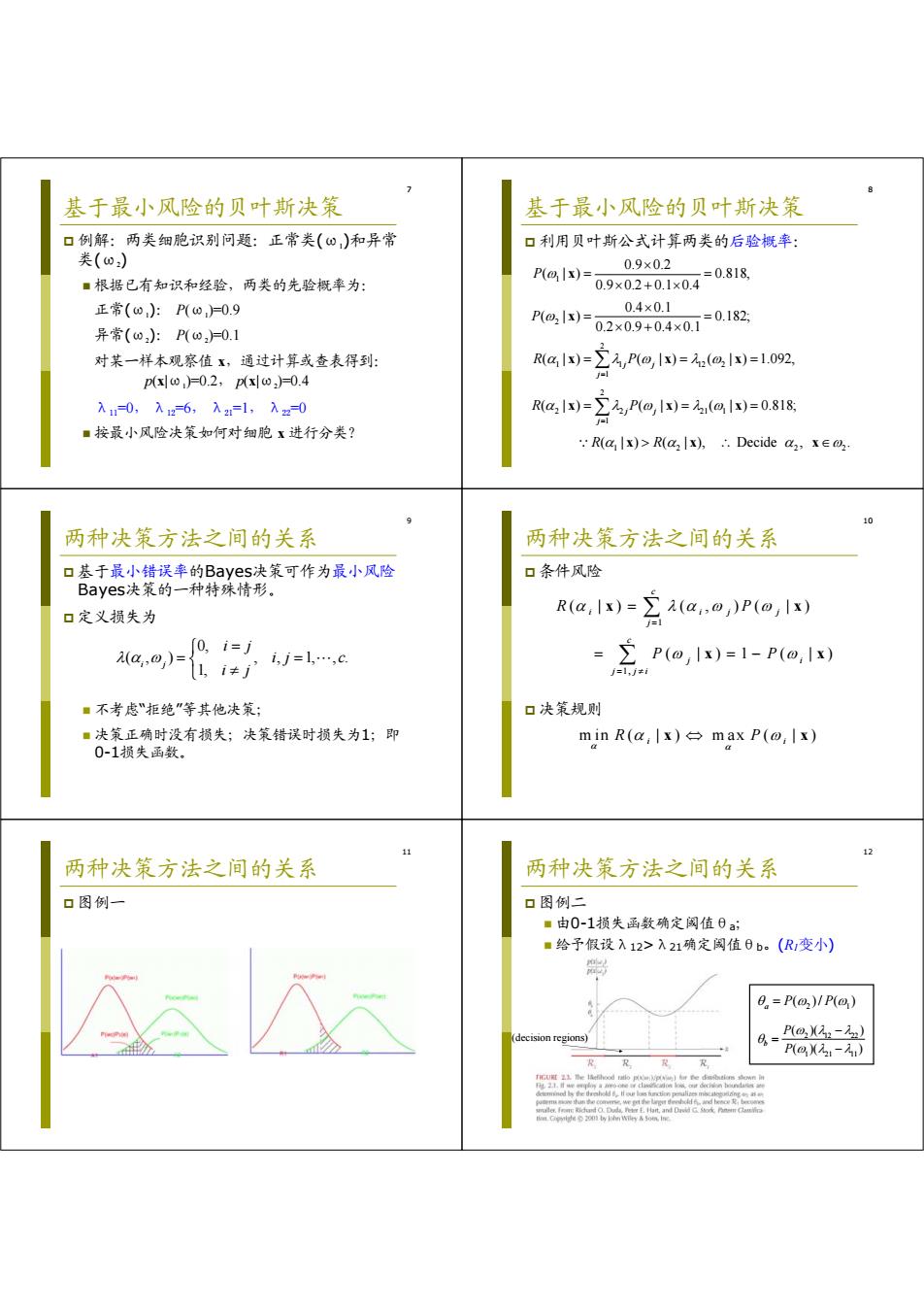

7 基于最小风险的贝叶斯决策 例解:两类细胞识别问题:正常类(ω1)和异常 类(ω2) 根据已有知识和经验,两类的先验概率为: 正常(ω1): P(ω1)=0.9 异常(ω2): P(ω2)=0.1 对某一样本观察值 x,通过计算或查表得到: p(x|ω1)=0.2, p(x|ω2)=0.4 λ11=0, λ12=6, λ21=1, λ22=0 按最小风险决策如何对细胞 x 进行分类? 8 基于最小风险的贝叶斯决策 利用贝叶斯公式计算两类的后验概率: 1 2 2 1 1 12 2 1 2 2 2 21 1 1 1 2 22 0.9 0.2 ( | ) 0.818, 0.9 0.2 0.1 0.4 0.4 0.1 ( | ) 0.182; 0.2 0.9 0.4 0.1 ( | ) ( | ) ( | ) 1.092, ( | ) ( | ) ( | ) 0.818; ( | ) ( | ), Decide , . j j j j j j P P R P R P R R x x x xx x xx xx x 9 两种决策方法之间的关系 基于最小错误率的Bayes决策可作为最小风险 Bayes决策的一种特殊情形。 定义损失为 不考虑“拒绝”等其他决策; 决策正确时没有损失;决策错误时损失为1;即 0-1损失函数。 0, ( , ) , , 1, , . 1, i j i j i j c i j 10 两种决策方法之间的关系 条件风险 决策规则 1 1, ( | ) ( , )( | ) ( | )1 ( | ) c i ij j j c j i j ji R P P P x x x x min ( | ) max ( | ) R P i i x x 11 两种决策方法之间的关系 图例一 12 两种决策方法之间的关系 图例二 由0-1损失函数确定阈值θa; 给予假设λ12>λ21确定阈值θb。(R1变小) (decision regions) 2 1 ( )/ ( ) a P P 2 12 22 1 21 11 ( )( ) ( )( ) b P P

13 Neyman-Pearson决策 Neyman-Pearson决策 口问题的提出 口两类错误率 ■某些两类判决问题,某一类错误较另一类错误更 ■令R是整个特征空间,R是类别w1的决策域, 为重要一损失更为严重。例如在癌细胞识别问 R2是类别O2的决策域:R,+R2=R 题中,把异常误判为正常的损失更为严重。 P(error)=P(@.Ix)p(xx+P(lx)p(xds ■先验概率未知. 口基本思想 =jpa)Po,h+∫pa)Pah ■严格限制较重要的一类错误概率,在令其等于某 =P(@:)S.p(xI@:)dx+P(o)J.P(xl0,)ds 常数的约束下使另一类误判概率最小。 =P(@)P(error)+P(@)P(error) ■P1eror,P2eror)即两类错误率。 15 16 Neyman-Pearson决策 Neyman-Pearson决策 口决策目标:在P2erro)=E条件下,求P1(eror) 口决策目标:极小化Y 极小值。 ■根据Lagrange乘子法,建立数学模型 r=(1-E)+J [Ap(x)-p(xx: 或者 y=P(error)+(B(error)-So), y=-)2+[pxo)-ipxo,达: 其中入是Lagrange乘子,目标是求y的极小值. ■对于固定的入,要使得y最小,应满足 注意:R(eor)=pa达=l-pa x∈R,p(x|o2)-p(x)<0: B(error)=Sp(xl@.)ds=1-Sp(xl0.Xds=6o. VxER,p(xl@)-Ap(xl@2)<O, Neyman-Pearson决策 Neyman-Pearson决策 口决策准则 口求决策准则的方法二 if().then xe ■令1是R和R的分界点(面),将Y分别对t 02 和入求偏导,Y极值点存在的必要条件是: Or lx=pa)>a,then x =0→=x/ p|o2) p(x@)< 器-0一人AaM=6 →N-P决策规则归结为找阁值入,使得 D方程式确定一个分界面,使得Peor=c0,同 Jap(xlo)ds=to 时又使得P,(error)尽可能小。该分界面上x值具有 一个特点,即它们的两类条件密度函数之比是一 口入的显式解不易求解,可用试探法。 个常数,该比值就是Lagrange乘子入

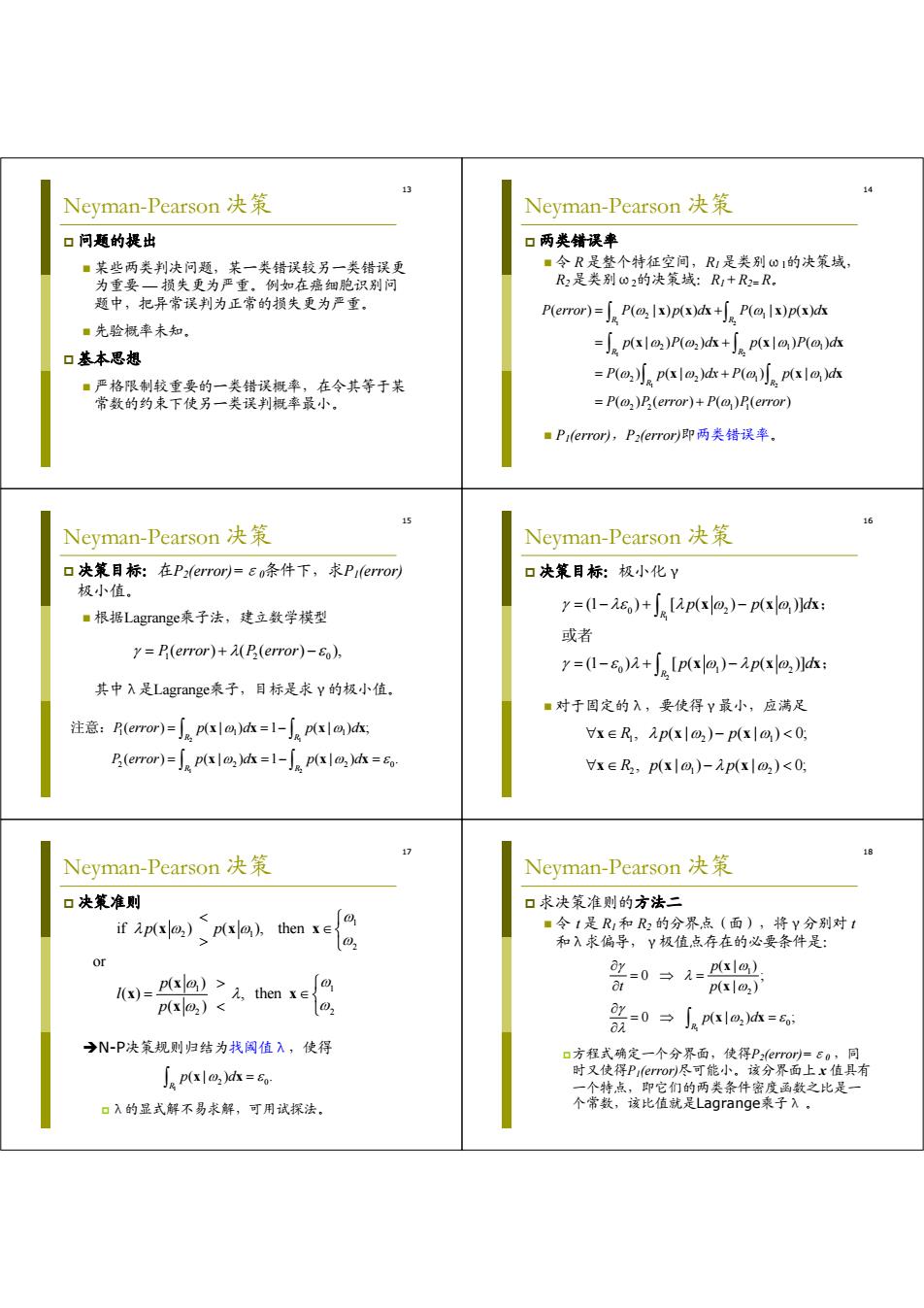

13 Neyman-Pearson 决策 问题的提出 某些两类判决问题,某一类错误较另一类错误更 为重要 — 损失更为严重。例如在癌细胞识别问 题中,把异常误判为正常的损失更为严重。 先验概率未知。 基本思想 严格限制较重要的一类错误概率,在令其等于某 常数的约束下使另一类误判概率最小。 14 Neyman-Pearson 决策 两类错误率 令 R 是整个特征空间,R1 是类别ω1的决策域, R2 是类别ω2的决策域:R1 + R2= R。 P1(error),P2(error)即两类错误率。 1 2 1 2 1 2 2 1 2 2 11 2 21 1 2 2 11 ( ) ( | ) () ( | ) () ( | )( ) ( | )( ) () ( | ) () ( | ) ( )( ) ( )( ) R R R R R R P error P p d P p d p Pd p Pd P p dx P p d P P error P P error x xx x xx x xx x x xx 15 Neyman-Pearson 决策 决策目标:在P2(error)=ε0条件下,求P1(error) 极小值。 根据Lagrange乘子法,建立数学模型 其中λ是Lagrange乘子,目标是求γ的极小值。 1 20 P error P error ( ) ( ( ) ), 2 1 1 2 1 11 2 2 20 ( ) (| ) 1 (| ) ; () ( | )1 ( | ) . R R R R P error p d p d P error p d p d xx xx xx xx 注意: 16 Neyman-Pearson 决策 决策目标:极小化γ 对于固定的λ,要使得γ最小,应满足 1 2 0 21 0 12 (1 ) [ ( ) ( )] (1 ) [ ( ) ( )] R R p p d p p d x xx x xx ; 或者 ; 1 21 21 2 , ( | ) ( | ) 0; , ( | ) ( | ) 0; Rp p Rp p x xx xx x 17 Neyman-Pearson 决策 决策准则 N-P决策规则归结为找阈值λ,使得 λ的显式解不易求解,可用试探法。 1 2 1 2 1 1 2 2 if ( ) ( ), then or ( ) ( ) , then ( ) p p p l p xx x x x x x 1 2 0 (| ) . R p d x x 18 Neyman-Pearson 决策 求决策准则的方法二 令 t 是 R1 和 R2 的分界点(面),将γ分别对 t 和λ求偏导,γ极值点存在的必要条件是: 方程式确定一个分界面,使得P2(error)=ε0 ,同 时又使得P1(error)尽可能小。该分界面上 x 值具有 一个特点,即它们的两类条件密度函数之比是一 个常数,该比值就是Lagrange乘子λ 。 1 1 2 2 0 (| ) 0 ; (| ) 0 ( | ) ; R p t p p d x x x x

19 20 Neyman-Pearson决策 Neyman-Pearson决策 口例解:一个两类问题中,模式均为二维正态分 口例解 布,其均值失量和协方差阵分别为: ■判决准则: 4=(-1,0),42=1,0),=2=1 设&。=0.09,求Neyman--Pearson的决策阈值。 fem-2)之1e4 then :.对于不同的2,决策边界是平行于x,的不同直线。(如图) ■解: 脚[-%-小立++ p(x1o)=1 pe=e[-4-}---+到 ()=eoxp(-2x) po2) 21 22 Neyman-Pearson决策 Neyman-Pearson决策 口例解 口最小错误率的Bayes.决策与N-P决策 ■通过计算P2(error)=6o求解入: ■均以似然比为基础; B(error)=p(xo:)dx ■最小错误率的Bayes决策的阈值是先验概率之比 P(@2) 2 P() 4 ■Neyman-Pearson.决策的闵值是Lagrange乘子 (和先验概率无关)。 入 4 2 1 1/2 1/4 0.046 0.0890.0159 0.258 0.378 1与的关系表 其他决策方法(自学)》 分类器设计 口最大最小决策 口分类器(classifier):能够将每个样本都分到某 ■基本思想:类先验概率未知,考查先验概率变化 个类别中去(或者拒绝)的计算机算法。 对错误率的影响,找出使最小风险贝叶斯决策的 ■是从特征空间到决策空间的映射。 风险最大的先验概率,以这种最坏情况设计分类 口决策城(decision region):分类器将d维特征 空间划分为若千区域。 口序贯分类方法 口决策面(decision boundary):小不同类别区域 ■基本思想:除考虑分类造成的损失外,还考虑特 之间的边界,又叫作分类边界、决策边界或分类 征获取所造成的代价。先用一部分特征分类,然 面。数学上用解析形式表示成决策面方程。 后逐步加入新特征以减少分类损失,同时衡量总 的损失,以求得最优的效益

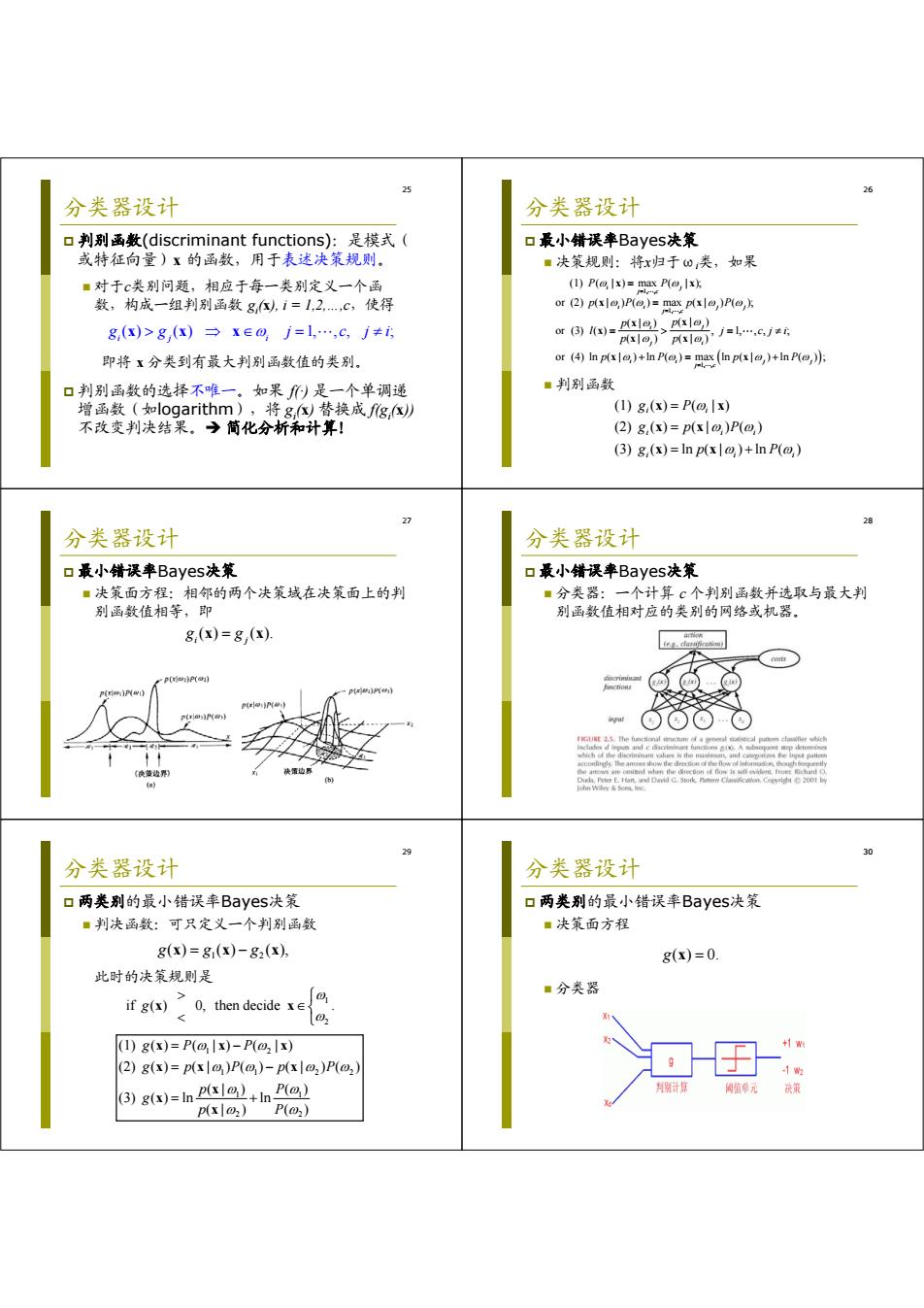

19 Neyman-Pearson 决策 例解:一个两类问题中,模式均为二维正态分 布,其均值矢量和协方差阵分别为: 解: 1 2 12 ( 1,0) , (1,0) , . T T I 0 设 , 0.09 Neyman-Pearson 求 的决策阈值。 2 2 1 11 12 2 2 2 2 2 12 1 1 2 11 11 ( | ) exp exp 1 ; 22 22 11 11 ( | ) exp exp 1 ; 22 22 (| ) exp( 2 ). (| ) T T p xx p xx p x p x xx x xx x x 20 Neyman-Pearson 决策 例解 判决准则: 1 1 2 2 1 if exp( 2 ) i e , th 1 - ln 2 en ; x x x , . . x 对于不同的 ,决策边界是平行于 的不同直线。(如图) 21 Neyman-Pearson 决策 例解 通过计算P2(error)=ε0求解λ: 1 2 2 1 2 2 ln 2 1 2 2 1 1 2 ln 2 1 1 ( ) (| ) 1 ( 1) exp 2 2 1 ( 1) exp . 2 2 R P error p d x x dx dx x dx x x 0.046 0.089 0.0159 0.258 0.378 0 4 2 1 1/2 1/4 0 与 的关系表 22 Neyman-Pearson 决策 最小错误率的Bayes决策与N-P决策 均以似然比为基础; 最小错误率的Bayes决策的阈值是先验概率之比 Neyman-Pearson决策的阈值是Lagrange乘子 (和先验概率无关)。 ; ( ) ( ) 1 2 P P 23 其他决策方法(自学) 最大最小决策 基本思想:类先验概率未知,考查先验概率变化 对错误率的影响,找出使最小风险贝叶斯决策的 风险最大的先验概率,以这种最坏情况设计分类 器。 序贯分类方法 基本思想:除考虑分类造成的损失外,还考虑特 征获取所造成的代价。先用一部分特征分类,然 后逐步加入新特征以减少分类损失,同时衡量总 的损失,以求得最优的效益。 24 分类器设计 分类器(classifier):能够将每个样本都分到某 个类别中去(或者拒绝)的计算机算法。 是从特征空间到决策空间的映射。 决策域(decision region):分类器将 d 维特征 空间划分为若干区域。 决策面(decision boundary):不同类别区域 之间的边界,又叫作分类边界、决策边界或分类 面。数学上用解析形式表示成决策面方程

25 26 分类器设计 分类器设计 口判别函数(discriminant functions):是模式( 口最小错误率Bayes.决策 或特征向量)x的函数,用于表述决策规则。 ■决策规则:将x归于o类,如果 ■对于c类别问题,相应于每一类别定义一个函 (1)P(o,Ix)=max P(o,x 数,构成一组判别函数g,i=1,2,c,使得 or (2)p()P()=m()P(,) 8(x)>g,(x)→x∈0j=1…,cj≠6 or3)国=pa2、Px1o,) I回广2回jL,6 即将x分类到有最大判别函数值的类别。 or (4)In p(x)+n P()=max (in p(x)+inP(,)) 口判别函数的选择不唯一。如果)是一个单调递 ■判别函数 增函数(如logarithm),将g,x替换成fg,x (1)g(x)=P(a,Ix) 不改变判决结果。简化分析和计算! (2)g,(x)=px|o,)P(@,) (3)8,(x)=In p(xl@)+In P(@,) 27 28 分类器设计 分类器设计 口最小错误率Bayes.决策 口最小错误率Bayes:决策 ■决策面方程:相邻的两个决策域在决策面上的判 ■分类器:一个计算c个判别函数并选取与最大判 别函数值相等,即 别函数值相对应的类别的网络或机器」 8,(x)=8,(x) p(riw:)P(on) p()) ([w (n) 29 分类器设计 分类器设计 口两类别的最小错误率Bayes.决策 口两类别的最小错误率Bayes:决策 ■判决函数:可只定义一个判别函数 ■决策面方程 g(x)=8(x)-82(x), g(x)=0. 此时的决策规则是 ifgy>o,then decide∈ ■分类器 (1)g(x)=P(@,Ix)-P(@2 Ix) (2)g(x)=p(x|a)P(,)-px|o2)P(o2) (3)g(x)=In)in P() 判期计算 值单元 块策 p(xlo2) P(2)

25 分类器设计 判别函数(discriminant functions):是模式( 或特征向量)x 的函数,用于表述决策规则。 对于c类别问题,相应于每一类别定义一个函 数,构成一组判别函数 gi (x), i = 1,2,…,c,使得 即将 x 分类到有最大判别函数值的类别。 判别函数的选择不唯一。如果 f(·) 是一个单调递 增函数(如logarithm),将 gi (x) 替换成 f(gi (x)) 不改变判决结果。 简化分析和计算! ( ) ( ) 1, , , ; ij i gg j xx x c j i 26 分类器设计 最小错误率Bayes决策 决策规则:将x归于ωi类,如果 判别函数 (1) ( ) ( | ) (2) ( ) ( | ) ( ) (3) ( ) ln ( | ) ln ( ) i i i ii i ii g P gpP gp P x x x x x x 1, , 1, , 1, , (1) ( | ) max ( | ); or (2) ( | ) ( ) max ( | ) ( ); (| ) (| ) or (3) ( ) , 1, , , ; (| ) (| ) or (4) ln ( | ) ln ( ) max ln ( | ) ln ( ) ; i j j c ii j j j c j i j i ii j j j c P P pP p P p p l j cj i p p pP p P x x x x x x x x x x x 27 分类器设计 最小错误率Bayes决策 决策面方程:相邻的两个决策域在决策面上的判 别函数值相等,即 ( ) ( ). i j g g x x 28 分类器设计 最小错误率Bayes决策 分类器:一个计算 c 个判别函数并选取与最大判 别函数值相对应的类别的网络或机器。 29 分类器设计 两类别的最小错误率Bayes决策 判决函数:可只定义一个判别函数 此时的决策规则是 1 2 gg g ( ) ( ) ( ), xxx 1 2 11 2 2 1 1 2 2 (1) ( ) ( | ) ( | ) (2) ( ) ( | )( ) ( | )( ) (| ) ( ) (3) ( ) ln ln (| ) ( ) gP P gp P p P p P g p P xxx xx x x x x 1 2 if ( ) 0, then decide . g x x 30 分类器设计 两类别的最小错误率Bayes决策 决策面方程 分类器 g( ) 0. x