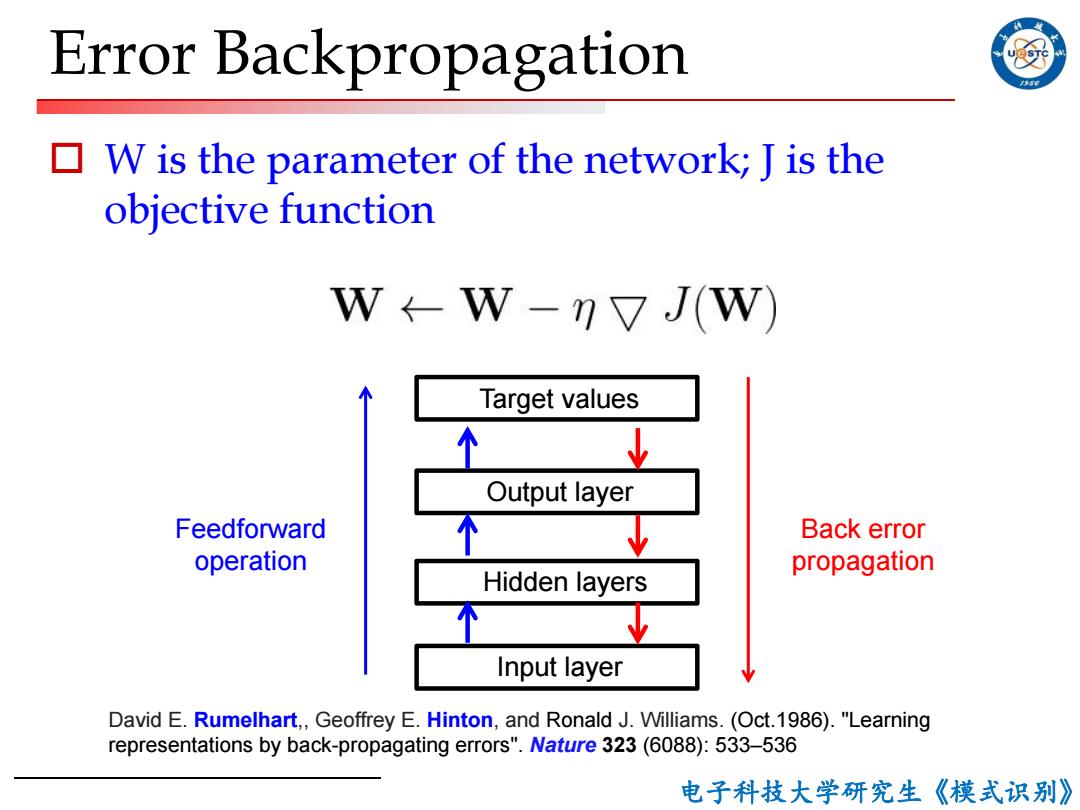

Error Backpropagation 56 W is the parameter of the network;J is the objective function W←W-?又J(W) Target values 个 Output layer Feedforward Back error operation propagation Hidden layers Input layer David E.Rumelhart,,Geoffrey E.Hinton,and Ronald J.Williams.(Oct.1986)."Learning representations by back-propagating errors".Nature 323(6088):533-536 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 Error Backpropagation o W is the parameter of the network; J is the objective function Feedforward operation Back error propagation David E. Rumelhart,, Geoffrey E. Hinton, and Ronald J. Williams. (Oct.1986). "Learning representations by back-propagating errors". Nature 323 (6088): 533–536 Output layer Hidden layers Input layer Target values

2nd generation neural networks /956 口理论上多层好 ■两层权重即可逼近任何连续函数映射 口遗憾的是,训练困难 It requires labeled training data Almost all data is unlabeled. The learning time does not scale well It is very slow in networks with multiple hidden layers. ■ It can get stuck in poor local optima These are often quite good,but for deep nets they are far from optimal. 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 2nd Generation Neural Networks o 理论上多层好 n 两层权重即可逼近任何连续函数映射 o 遗憾的是,训练困难 n It requires labeled training data p Almost all data is unlabeled. n The learning time does not scale well p It is very slow in networks with multiple hidden layers. n It can get stuck in poor local optima p These are often quite good, but for deep nets they are far from optimal. 12

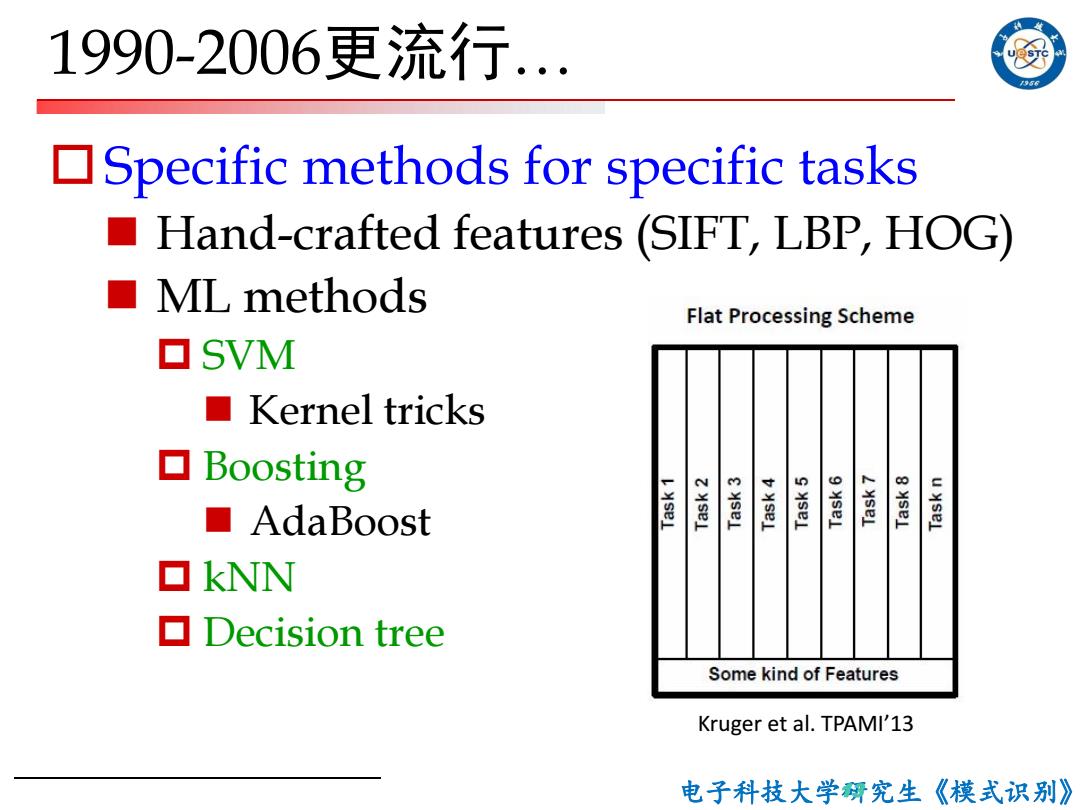

1990-2006更流行.. 956 Specific methods for specific tasks ■ Hand-crafted features (SIFT,LBP,HOG) ■ML methods Flat Processing Scheme ▣SVM ■Kernel tricks ▣Boosting ■AdaBoost 童 适 遥 篷 產 ▣kNN ▣Decision tree Some kind of Features Kruger et al.TPAMI'13 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 1990-2006更流行… oSpecific methods for specific tasks n Hand-crafted features (SIFT, LBP, HOG) n ML methods p SVM n Kernel tricks p Boosting n AdaBoost p kNN p Decision tree 13 Kruger et al. TPAMI’13

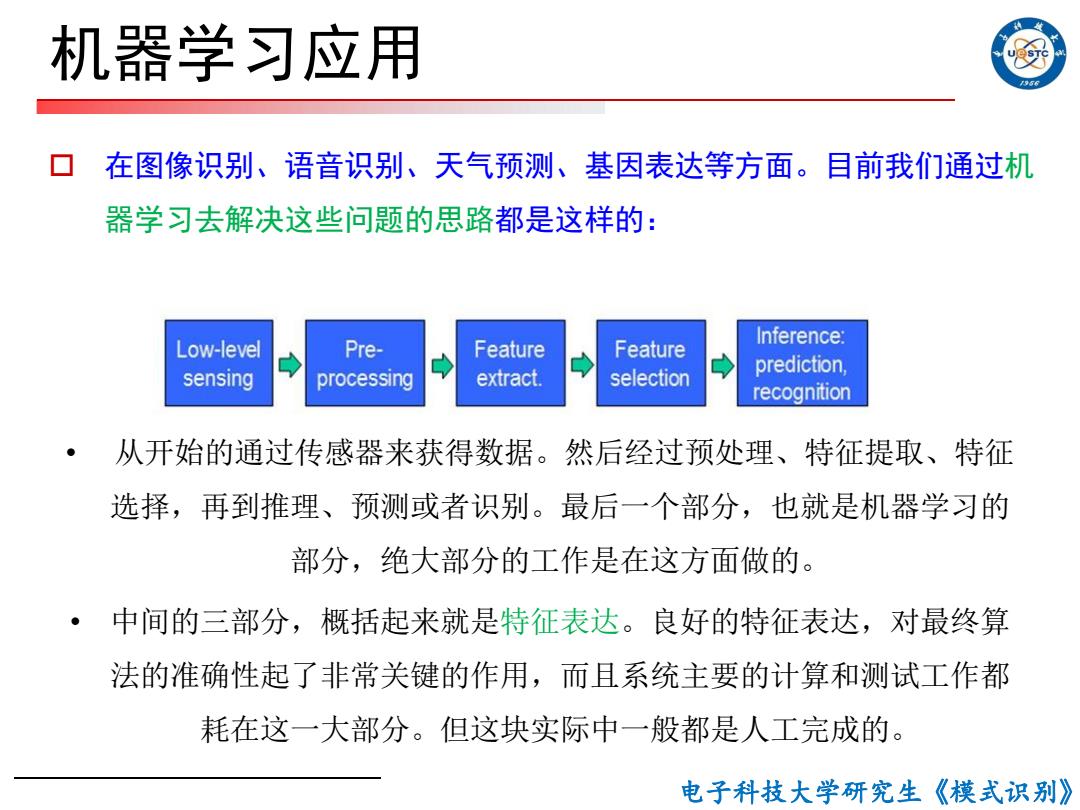

机器学习应用 在图像识别、语音识别、天气预测、基因表达等方面。目前我们通过机 器学习去解决这些问题的思路都是这样的: Inference: Low-level Pre- Feature Feature extract. prediction, sensing processing selection recognition 从开始的通过传感器来获得数据。然后经过预处理、特征提取、特征 选择,再到推理、预测或者识别。最后一个部分,也就是机器学习的 部分,绝大部分的工作是在这方面做的。 中间的三部分,概括起来就是特征表达。良好的特征表达,对最终算 法的准确性起了非常关键的作用,而且系统主要的计算和测试工作都 耗在这一大部分。但这块实际中一般都是人工完成的。 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 机器学习应用 o 在图像识别、语音识别、天气预测、基因表达等方面。目前我们通过机 器学习去解决这些问题的思路都是这样的: • 从开始的通过传感器来获得数据。然后经过预处理、特征提取、特征 选择,再到推理、预测或者识别。最后一个部分,也就是机器学习的 部分,绝大部分的工作是在这方面做的。 • 中间的三部分,概括起来就是特征表达。良好的特征表达,对最终算 法的准确性起了非常关键的作用,而且系统主要的计算和测试工作都 耗在这一大部分。但这块实际中一般都是人工完成的

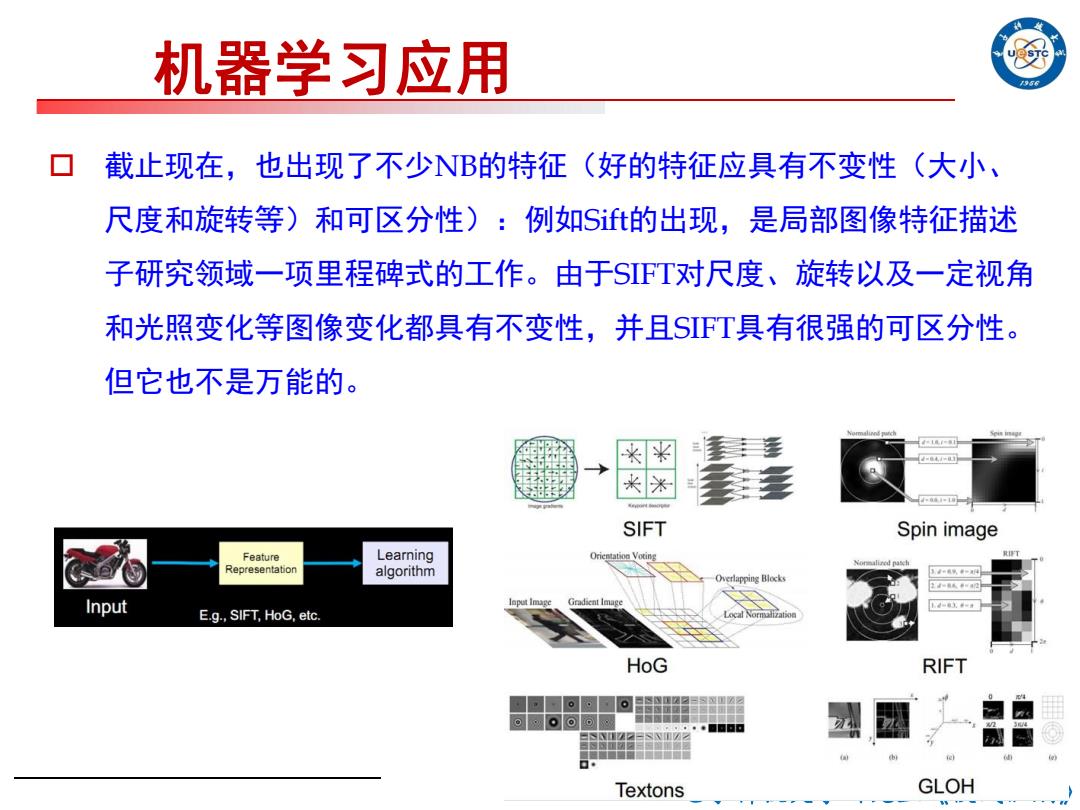

机器学习应用 56 截止现在,也出现了不少NB的特征(好的特征应具有不变性(大小、 尺度和旋转等)和可区分性):例如St的出现,是局部图像特征描述 子研究领域一项里程碑式的工作。由于SFT对尺度、旋转以及一定视角 和光照变化等图像变化都具有不变性,并且SFT具有很强的可区分性。 但它也不是万能的。 典片 电=回 米 SIFT Spin image Feature Learning Orientation Voting Nonmalired pasch Representation algorithm -Overlapping Blocks 2k4阳 Input E.g.,SIFT,HoG,etc. HoG RIFT Textons GLOH

电子科技大学研究生《模式识别》 o 截止现在,也出现了不少NB的特征(好的特征应具有不变性(大小、 尺度和旋转等)和可区分性):例如Sift的出现,是局部图像特征描述 子研究领域一项里程碑式的工作。由于SIFT对尺度、旋转以及一定视角 和光照变化等图像变化都具有不变性,并且SIFT具有很强的可区分性。 但它也不是万能的。 机器学习应用