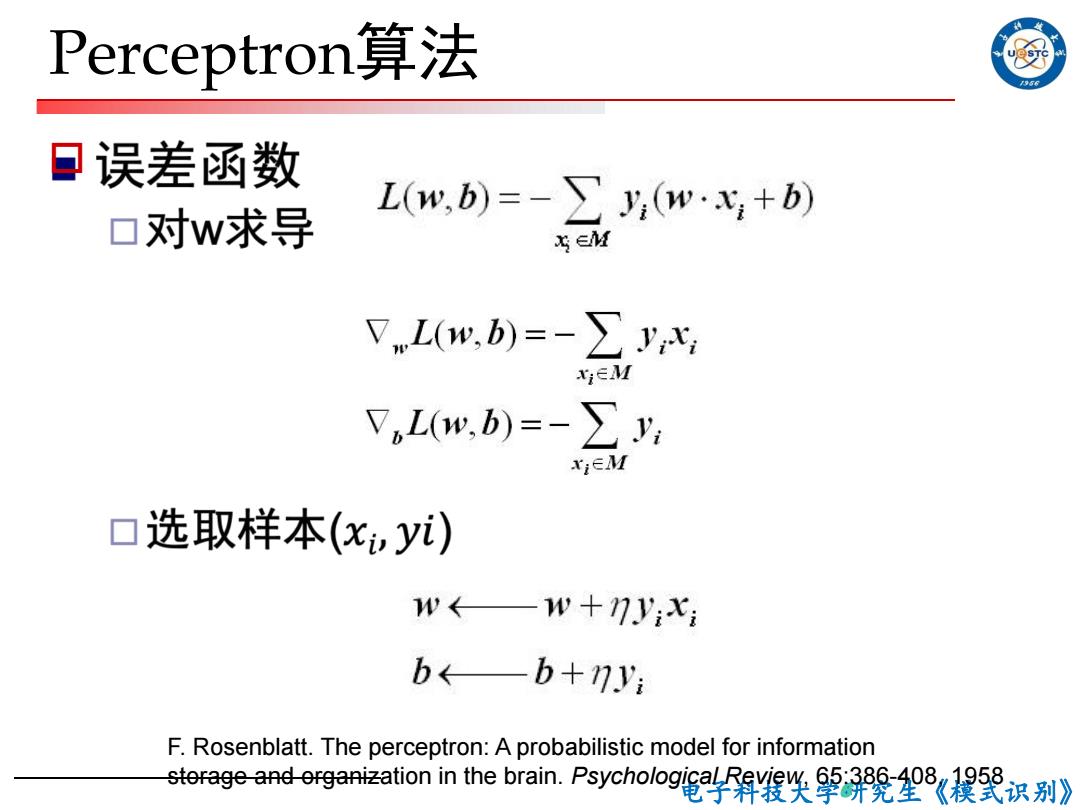

Perceptron算法 口误差函数 口对w求导 L(w,b)=-y:(w·X+b) S∈M VL(w,b)=-∑y XIEM VL(w,b)=-∑y, XIEM 口选取样本(xyi) w←—w+7y:x: b←—b+7.y F.Rosenblatt.The perceptron:A probabilistic model for information tora9e3nd-6 iinthbrain..Psycholog线关2望(程识别》

电子科技大学研究生《模式识别》 Perceptron算法 o 6 F. Rosenblatt. The perceptron: A probabilistic model for information storage and organization in the brain. Psychological Review, 65:386-408, 1958

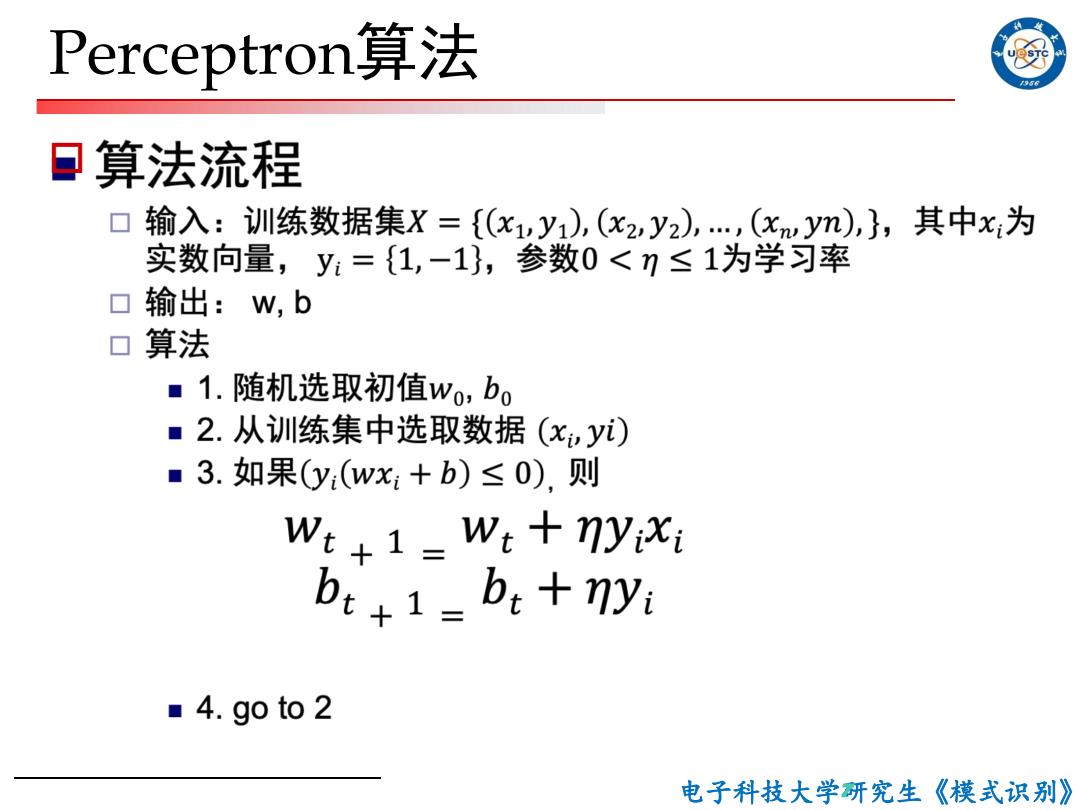

Perceptron算法 口算法流程 输入:训练数据集X={(x1vy1),(x2,y2),,(xwym),},其中x:为 实数向量,y={1,-1},参数0<1≤1为学习率 口输出:w,b 口算法 ■1.随机选取初值wo,bo ■2.从训练集中选取数据(xyi) ■3.如果y(wx:+b)≤0),则 W:+1-W:+nyixi bt:1=bi+nyi ■4.goto2 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 Perceptron算法 o 7

第一代神经网络 口 单层感知机(Perceptrons)模型的局限性 ■Minsky&Papert的专著Perceptron(1969) ■只能对线性可分的模式进行分类 ■解决不了异或问题 ■几乎宣判了这类模型的死刑,导致了随后 多年NN研究的低潮 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 第一代神经网络 o单层感知机(Perceptrons)模型的局限性 n Minsky & Papert的专著Perceptron(1969) n 只能对线性可分的模式进行分类 n 解决不了异或问题 n 几乎宣判了这类模型的死刑,导致了随后 多年NN研究的低潮 8

前馈神经网络的BP学习算法 David E.Rumelhart,,Geoffrey E.Hinton,and Ronald J.Williams.(Oct.1986)."Learning representations by back-propagating errors".Nature 323(6088):533-536

前馈神经网络的BP学习算法 David E. Rumelhart,, Geoffrey E. Hinton, and Ronald J. Williams. (Oct.1986). "Learning representations by back-propagating errors". Nature 323 (6088): 533–536

2nd generation neural networks /956 多层感知机(Multi--layer Perceptron,MLP) ■ 超过1层的hidden layers(正确输出未知的层) ▣BP算法[Rumelhart et al..,1986] ■Compute error signal Then,back-propagate error signal to get derivatives for learning X1 y1 X2 y2 X3 David E.Rumelhart,,Geoffrey E.Hinton,and Ronald J.Williams.(Oct.1986)."Learning reproontation-电yea6 ingors.Nature323(608笔斜大学研究生《模式识别》

电子科技大学研究生《模式识别》 2nd Generation Neural Networks o 多层感知机(Multi-layer Perceptron, MLP) n 超过1层的hidden layers(正确输出未知的层) o BP算法 [Rumelhart et al., 1986] n Compute error signal; n Then, back-propagate error signal to get derivatives for learning 10 David E. Rumelhart,, Geoffrey E. Hinton, and Ronald J. Williams. (Oct.1986). "Learning representations by back-propagating errors". Nature 323 (6088): 533–536