956 Example 1: ·设k=4→p1=0.25,P2=0.25,p3=0.25,p4=0.25 1=-(.25*log2(.25)*4)=2 Example 2: 。设k=4→p1=0p2=0.5,P3=0,p4=0.5 1=-(.5*l0g2(.5)*2)=1 Example 3: ·设k=4→P1=1,p2=0,P3=0P4=0 1=-(1*l0g2(1)=0 15 2016/10/20 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》

决策树:ID3 5 ▣样本集信息熵 I(16,4)=-(告log2()+11o92()=0.8113 口逐个特征计算节点不纯度,及与上级不纯度减少量 1age=8I(6,1)+8I(10,3)=0.7914 △Iage(16)=I(16,4)-Iage=0.0177 AIgender(16)=I(16,4)-Igender =0.0972 Alincome(16)=I(16,4)-Iincome =0.0177 口最优特征,最大减小不纯度 ■性别 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 o 样本集信息熵 o 逐个特征计算节点不纯度,及与上级不纯度减少量 o 最优特征,最大减小不纯度 n 性别 决策树:ID3

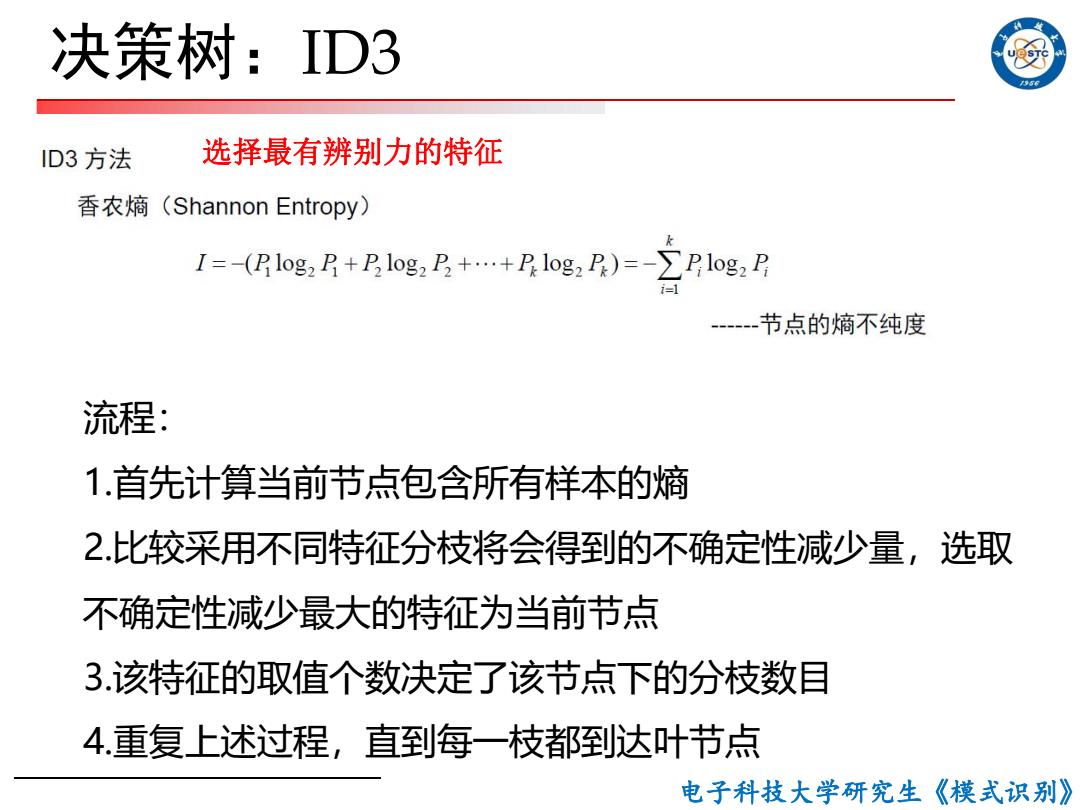

决策树:ID3 56 ID3方法 选择最有辨别力的特征 香农熵(Shannon Entropy) I=-(log2+Blog2D+…+Plog2P)=-∑Plog2P --2 节点的熵不纯度 流程: 1.首先计算当前节点包含所有样本的熵 2.比较采用不同特征分枝将会得到的不确定性减少量,选取 不确定性减少最大的特征为当前节点 3.该特征的取值个数决定了该节点下的分枝数目 4重复上述过程,直到每一枝都到达叶节点 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 流程: 1.首先计算当前节点包含所有样本的熵 2.比较采用不同特征分枝将会得到的不确定性减少量,选取 不确定性减少最大的特征为当前节点 3.该特征的取值个数决定了该节点下的分枝数目 4.重复上述过程,直到每一枝都到达叶节点 选择最有辨别力的特征 决策树:ID3

决策树:ID3 956 性别 女 男 月收入 年龄 低 中 高 <30 ≥30 否 否 是 否 是 若(性别=女)且(月收人<6000元),则(买车二否) 若(性别=女)且(月收人>6000元),则(买车=是) 若(性别=男)且(年龄<30岁),则(买车=否) 若(性别=男)且(年龄≥30岁),则(买车=是) 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 决策树:ID3

决策树:ID3 口基于信息增益的缺点? ■ 节点划分偏向取值较多的特征,导致过度分支 口原因 ■划分越多,内部越纯 信息增益对可取值数目较多的属性有所偏好 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 o 基于信息增益的缺点? n 节点划分偏向取值较多的特征,导致过度分支 o 原因 n 划分越多,内部越纯 决策树:ID3 信息增益对可取值数目较多的属性有所偏好