9.2.2线性不可分问题 1962年Rosenblatt宣布人工神经网络可以学会它能表示的任何东西。但是 l969 Minsky发表了一书《perceptron》,书中指出单层感知器不能解决许多最 基本的问题,如异或问题(XO),这类问题统称为线性不可分问题,即输入的 训练样本集是否是线性可分的,如果是线性可分的,则训练算法收敛,否则不收 敛。 异或问题的定义如下: 0,fx1=x2 y(x1,x2)= (9.1) 1,其它 相应的真值表如下: 点 输入x1 输入x2 输出y A1 0 0 0 B1 1 0 1 A2 1 1 0 B2 0 如果用单层感知器的话,其输出为 y(xI,x2)=f(ol*x1+02*x2-0) (9.2) 如果用单层感知器解决异或问题的话,根据异或问题的定义以及真值表可知,日 o1,o1的取值必须满足下面方程组: 0+0-0<0 o1-020 (9.3) ol+o2-0<0 02-0≥0 该方程组是无解的。所以单层感知器是无法解决异或问题的。 该问题的几何意义如图所示,感知器的输出为1用空心圆表示,输出为0用实心 圆表示,可以看出满足x1XORx2=1的点集(输入集)为B={B1,B2},满足x1XOR x2=0的点集(输入集)为A={A1,A2}。显然无论如何选择0,o1,o1的取值

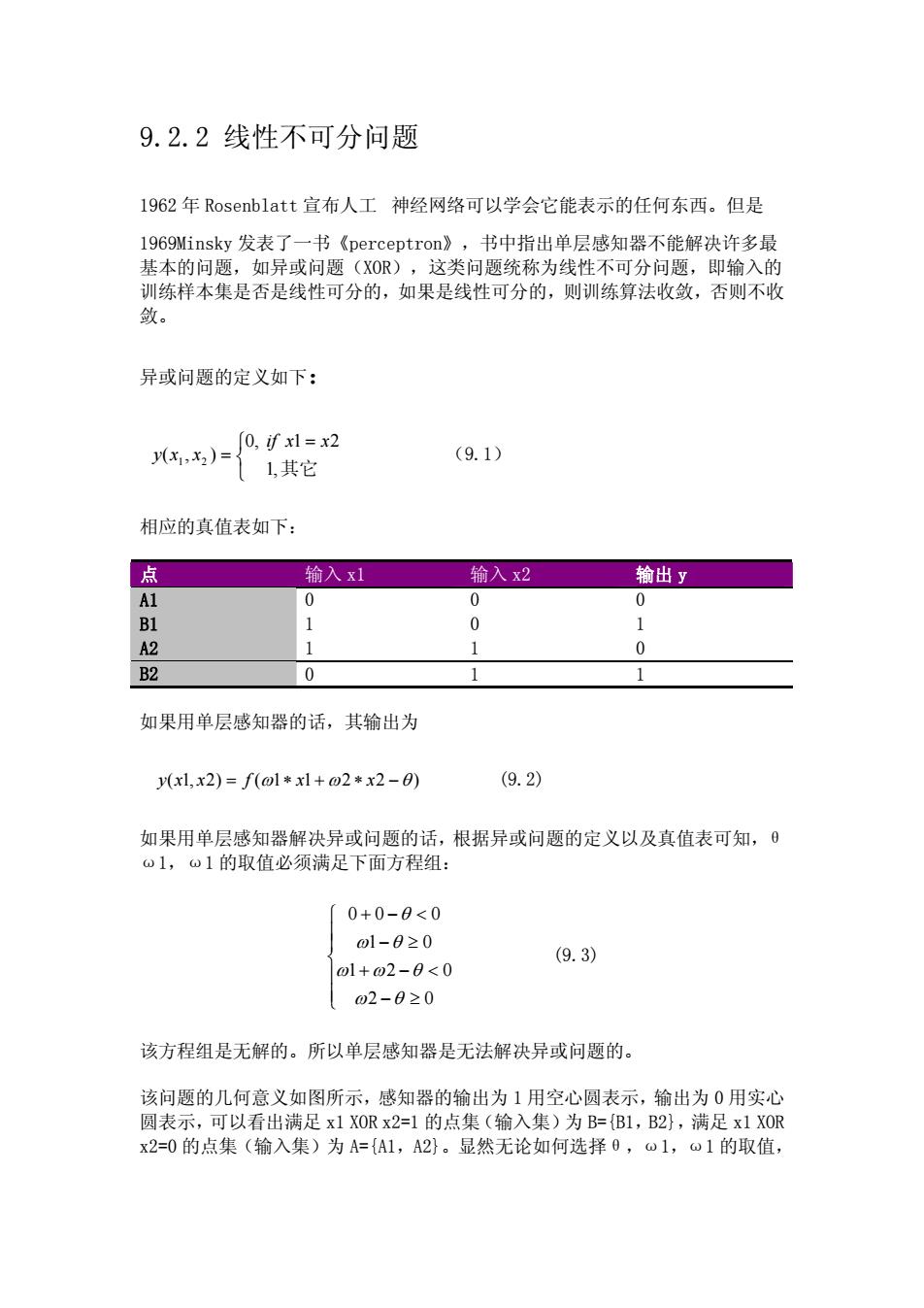

9.2.2 线性不可分问题 1962 年 Rosenblatt 宣布人工 神经网络可以学会它能表示的任何东西。但是 1969Minsky 发表了一书《perceptron》,书中指出单层感知器不能解决许多最 基本的问题,如异或问题(XOR),这类问题统称为线性不可分问题,即输入的 训练样本集是否是线性可分的,如果是线性可分的,则训练算法收敛,否则不收 敛。 异或问题的定义如下: (9.1) ⎩ ⎨ ⎧ = = ,1 其它 21 ,0 ),( 21 xxif xxy 相应的真值表如下: 点 输入 x1 输入 x2 输出 y A1 0 0 0 B1 1 0 1 A2 1 1 0 B2 0 1 1 如果用单层感知器的话,其输出为 = ω ∗ ω ∗+ xxfxxy −θ )2211()2,1( (9.2) 如果用单层感知器解决异或问题的话,根据异或问题的定义以及真值表可知,θ ω1,ω1 的取值必须满足下面方程组: ⎪ ⎪ ⎩ ⎪ ⎪ ⎨ ⎧ ≥− <−+ ≥− <−+ 02 021 01 000 θω θωω θω θ (9.3) 该方程组是无解的。所以单层感知器是无法解决异或问题的。 该问题的几何意义如图所示,感知器的输出为 1 用空心圆表示,输出为 0 用实心 圆表示,可以看出满足 x1 XOR x2=1 的点集(输入集)为 B={B1,B2},满足 x1 XOR x2=0 的点集(输入集)为 A={A1,A2}。显然无论如何选择θ,ω1,ω1 的取值

都无法找到一条直线在该平面上将A、B两类输入集分开,即使其它的激发函数 也很难做到。这种单层感知器所不能表达的问题称为线性不可分问题。 事实上很多问题都不能用单层感知器表达,这也是单层感知器的缺陷。 x2 B2(0.1 A21.1) ● xl ○ A1(0,0) B1(1,0) 9.2.3梯度下降和Delta法则 尽管训练样本线性可分时,感知器法则可以成功地找到一个权向量,但如果样本 不是线性可分的它将不能收敛。因此人们设计了另一个训练法则来克服这个不 足,称为Delta法则(delta rule)。如果训练样本不是线性可分的,那么delta 法则会收敛到目标概念的最佳近似。 Delta法则的关键思想是使用梯度下降(gradient descent)来搜索可能的权向 量的假设空间,以找到最佳拟合训练样本的权向量。 可以把Delta训练法则理解为训练一个无阈值的感知器,也就是一个线性单元 (Linear unit),它的输出o如下: 0(x)=0●x (9.4) 为了推导线性单元的权值学习法则,先指定一个度量标准来衡量假设的权向量相 对于训练样本的训练误差(training error): E=∑-o)尸 (9.5) 2 deD 其中D是训练样本集合,t,是训练样本d的目标输出,o。是线性单元对训练样 本d的输出。在这里把E定义为o的函数,是因为线性单元的输出o依赖于这个

都无法找到一条直线在该平面上将 A、B 两类输入集分开,即使其它的激发函数 也很难做到。这种单层感知器所不能表达的问题称为线性不可分问题。 事实上很多问题都不能用单层感知器表达,这也是单层感知器的缺陷。 x2 B2(0,1) A1(0,0) B1(1,0) A2(1,1) x1 9.2.3 梯度下降和 Delta 法则 尽管训练样本线性可分时,感知器法则可以成功地找到一个权向量,但如果样本 不是线性可分的它将不能收敛。因此人们设计了另一个训练法则来克服这个不 足,称为 Delta 法则(delta rule)。如果训练样本不是线性可分的,那么 delta 法则会收敛到目标概念的最佳近似。 Delta 法则的关键思想是使用梯度下降(gradient descent)来搜索可能的权向 量的假设空间,以找到最佳拟合训练样本的权向量。 可以把 Delta 训练法则理解为训练一个无阈值的感知器,也就是一个线性单元 (Linear unit),它的输出 o 如下: )( ω •= xxo (9.4) 为了推导线性单元的权值学习法则,先指定一个度量标准来衡量假设的权向量相 对于训练样本的训练误差(training error): ∑∈ −≡ Dd E ot dd 2 )( 2 1 ω)( (9.5) 其中 D 是训练样本集合, 是训练样本 d 的目标输出, 是线性单元对训练样 本 d 的输出。在这里把 E 定义为 dt od ω 的函数,是因为线性单元的输出 o 依赖于这个

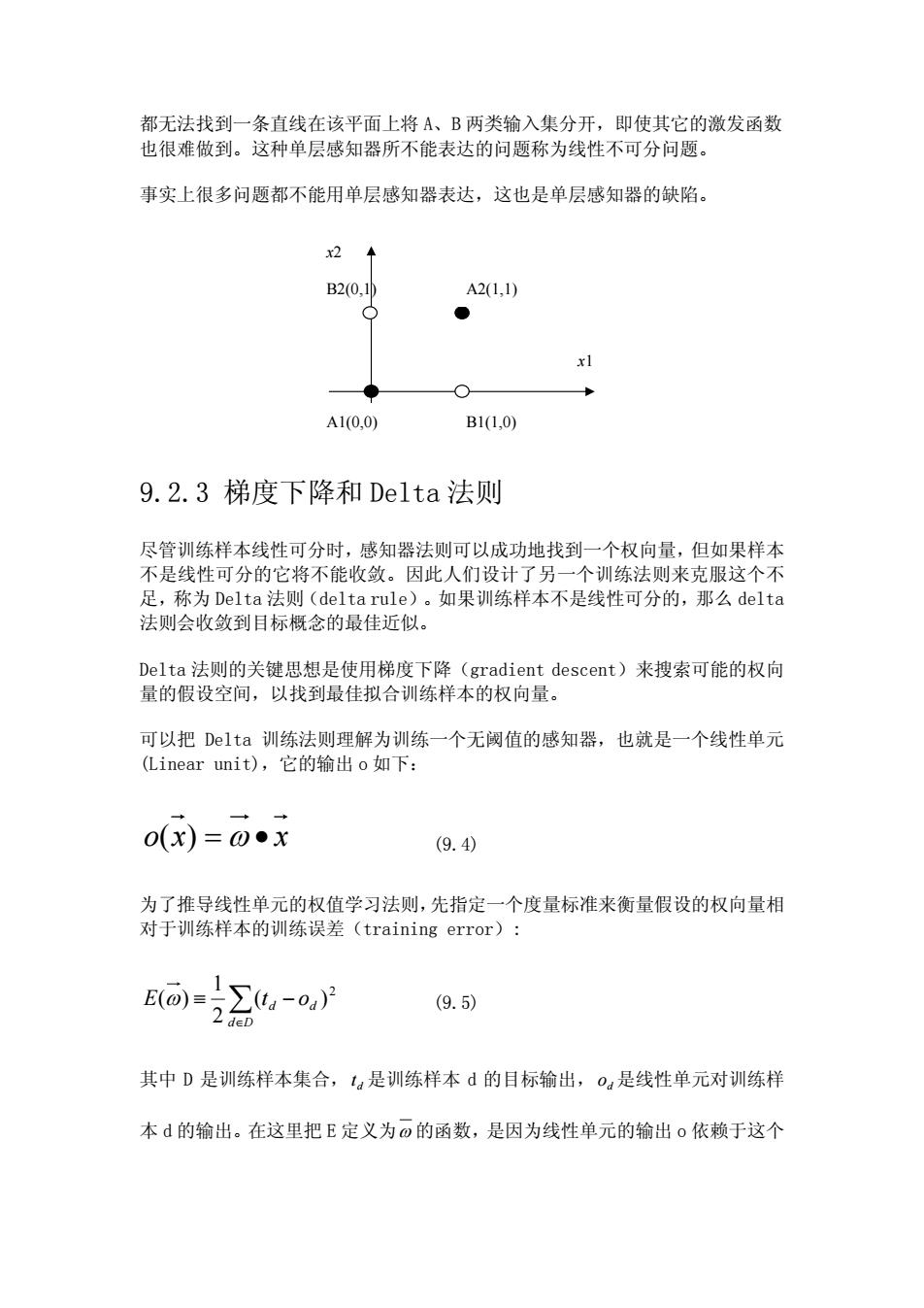

权值,当然E也依赖于特定的训练样本集合,但一般在训练期间训练样本集合是 固定的,所以没有把E也定义成训练样本的函数。 1.可视化假设空间 为了理解梯度下降算法,可视化地表示包含所有可能的权向量和相关联的E值的 整个假设空间。如图所示。这里坐标,o,表示一个简单的线性单元中两个权可 能的取值,纵轴表示相对于某固定训练样本的误差E。因此图中的误差曲面概括 了假设空间中每一个权向量的期望度(desirability)(期望得到一个具有最小 误差的假设)。如果定义E的方法已知,那么对于线性单元,这个误差曲面必然 是具有单一全局最小值的抛物面。当然抛物面的形状依赖于具体的训练样本集。 25 20 15 10 wO w1 为了确定一个E最小化的权向量,梯度下降搜索从一个任意的初始权向量开始, 然后以很小的步伐反复修改这个向量。每一步都沿误差曲面产生最陡峭下降的方 面修改权向量,继续这个过程直到得到全局最小误差点。 2.梯度下降法则的推导 如何计算出沿误差曲面最陡峭下降的方向?可通过计算E相对于向量。的每个 分量的偏导数来得到这个方向。这个向量导数被称为E对于0的梯度,记作 VE(@)

权值,当然 E 也依赖于特定的训练样本集合,但一般在训练期间训练样本集合是 固定的,所以没有把 E 也定义成训练样本的函数。 1.可视化假设空间 为了理解梯度下降算法,可视化地表示包含所有可能的权向量和相关联的 E 值的 整个假设空间。如图所示。这里坐标 10 ω ,ω 表示一个简单的线性单元中两个权可 能的取值,纵轴表示相对于某固定训练样本的误差 E。因此图中的误差曲面概括 了假设空间中每一个权向量的期望度(desirability)(期望得到一个具有最小 误差的假设)。如果定义 E 的方法已知,那么对于线性单元,这个误差曲面必然 是具有单一全局最小值的抛物面。当然抛物面的形状依赖于具体的训练样本集。 为了确定一个 E 最小化的权向量,梯度下降搜索从一个任意的初始权向量开始, 然后以很小的步伐反复修改这个向量。每一步都沿误差曲面产生最陡峭下降的方 面修改权向量,继续这个过程直到得到全局最小误差点。 2. 梯度下降法则的推导 如何计算出沿误差曲面最陡峭下降的方向?可通过计算 E 相对于向量ω 的每个 分量的偏导数来得到这个方向。这个向量导数被称为 E 对于ω 的梯度,记作 ∇E ω)(